Итак, мы нашли формулы для коэффициентов парной линейной регрессии с помощью МНК и указали условия, при которых этот метод обеспечивает наиболее эффективные оценки для параметров (коэффициентов) парной линейной регрессии. Теперь можно заняться проблемами качества оценки (приближения) объясняемой (зависимой) переменной, а также вопросами нахождения дисперсий и доверительных интервалов для найденных параметров регрессионных уравнений. Но сначала приведем три формулы, которые весьма полезны при оценке качества найденного уравнения регрессии.

(2.4)

(2.4)

(2.5)

(2.5)

Cov( ,ε) = 0 (2.6)

,ε) = 0 (2.6)

Первая из формул довольно очевидна – если отклонение содержит постоянную составляющую, то ее можно добавить к коэффициенту и при этом средний квадрат отклонений уменьшится, что невозможно при применении МНК. Вторая прямое следствие первой:  . Доказательство третьей также не представляет особых затруднений.

. Доказательство третьей также не представляет особых затруднений.

|

|

|

Приступим теперь непосредственно к нашей задаче. Пусть мы для переменной Y построили уравнение регрессии и получили представление:  . Мы можем использовать это представление для такого представления дисперсии величины Y:

. Мы можем использовать это представление для такого представления дисперсии величины Y:

Var(Y) = Var( + ε) = Var(

+ ε) = Var( ) + Var(ε) +2Cov(

) + Var(ε) +2Cov( ,ε)

,ε)

Однако из предыдущего (2.6) видно, что последнее слагаемое равно нулю, отсюда найдем:

Var(Y) = Var( ) + Var(ε)

) + Var(ε)

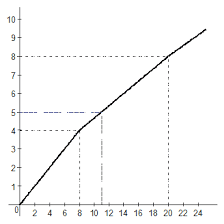

Т.е. мы разложили дисперсию величины Y на две части. Одна называется «объясненной» в том смысле, что наше уравнение регрессии объясняет ее происхождение, а вторая вызвана расхождением между самой величиной и ее регрессионным уравнением, ее называют «необъясненной». Тогда отношение:

(2.7)

(2.7)

указывает на ту долю в дисперсии Y, которую объясняет уравнение.

Максимальное значение  равно единице, таким будет показатель

равно единице, таким будет показатель  лишь в том случае, когда регрессионное уравнение описывает поведение величины Y абсолютно точно, а все величины εi равны нулю. Напротив, величина

лишь в том случае, когда регрессионное уравнение описывает поведение величины Y абсолютно точно, а все величины εi равны нулю. Напротив, величина  близкая к нулю означает, что в нашей выборке заметная связь между величинами Х и Y отсутствует.

близкая к нулю означает, что в нашей выборке заметная связь между величинами Х и Y отсутствует.

Заметим, что показатель  можно также интерпретировать как квадарат коэффициента корреляции между фактическими значениями

можно также интерпретировать как квадарат коэффициента корреляции между фактическими значениями  и модельными значениями

и модельными значениями  :

:

2.1.6 Качество модели – F -критерий (критерий Фишера)

Мы указали, что параметр  указывает, насколько наша модель хорошо описывает реальную зависимость. Если

указывает, насколько наша модель хорошо описывает реальную зависимость. Если  близко к единице, то все в порядке, а если близко к нулю, то адекватность регрессионной модели сомнительна. Однако возникает естественный вопрос – а что значит «близко к нулю»? при какой величине

близко к единице, то все в порядке, а если близко к нулю, то адекватность регрессионной модели сомнительна. Однако возникает естественный вопрос – а что значит «близко к нулю»? при какой величине  следует считать, что от модели следует отказаться, и наше регрессионное уравнение вообще неадекватно? Заметим, что подобный вопрос возникает не только в ситуации с уравнением линейной регрессии для одной независимой переменной, но и при попытках использовать более сложные регрессионные модели. И хотелось бы получить способ оценивания качества модели, применимый для различных регрессионных моделей.

следует считать, что от модели следует отказаться, и наше регрессионное уравнение вообще неадекватно? Заметим, что подобный вопрос возникает не только в ситуации с уравнением линейной регрессии для одной независимой переменной, но и при попытках использовать более сложные регрессионные модели. И хотелось бы получить способ оценивания качества модели, применимый для различных регрессионных моделей.

|

|

|

Такой ответ действительно можно получить в достаточно общем случае, и дает его так называемый F-критерий или критерий Фишера.

Пусть мы построили уравнение регрессии, содержащее k коэффициентов. Для линейной регрессии с одной независимой переменной k будет равно двум, т.к. у нас используются два коэффициента – b1 и b2. Если мы попробуем использовать квадратичную модель  (мы еще будем ее рассматривать), то очевидно у нас будет 3 коэффициента, если у нас задача с несколькими независимыми переменными, то число коэффициентов k будет еще больше. Но во всяком случае раз мы выбрали модель, то количество коэффициентов нам известно.

(мы еще будем ее рассматривать), то очевидно у нас будет 3 коэффициента, если у нас задача с несколькими независимыми переменными, то число коэффициентов k будет еще больше. Но во всяком случае раз мы выбрали модель, то количество коэффициентов нам известно.

Теперь пусть используя МНК мы вычислили значения всех наших коэффициентов, нашли все величины  и вычислили характеристику

и вычислили характеристику  . Тогда мы можем вычислить величину F -критерия по следующей формуле:

. Тогда мы можем вычислить величину F -критерия по следующей формуле:

(2.8)

(2.8)

Здесь n – количество значений в таблице yi.

Далее мы действуем по обычной схеме нулевой гипотезы. В качестве нулевой гипотезы мы выбираем предположение, что все подобие между значениями y и  возникло случайно[17]. И вычисляем значение критерия Фишера по формуле (2.8). После этого смотрим в таблицы критерия Фишера, отвечающие нашему числу степеней свободы f1 = k–1 и f2 = n–k. Согласно обычной схеме, если получится число, большее критического для уровня значимости 1%, мы должны отвергнуть нулевую гипотезу. Т.е. у нас нет оснований полагать, что совпадения между yi и

возникло случайно[17]. И вычисляем значение критерия Фишера по формуле (2.8). После этого смотрим в таблицы критерия Фишера, отвечающие нашему числу степеней свободы f1 = k–1 и f2 = n–k. Согласно обычной схеме, если получится число, большее критического для уровня значимости 1%, мы должны отвергнуть нулевую гипотезу. Т.е. у нас нет оснований полагать, что совпадения между yi и  вызваны только случайными причинами, и наше уравнение регрессии действительно описывает реальную связь. Если величина F окажется меньше значения, которое в таблице отвечает пятипроцентному уровню значимости, мы принимаем предположение, что связи между объясняющими переменными и величинами yi реально не выявлено. И как обычно промежуточный случай означает некую неопределенность – избранный нами критерий не может достаточно надежно разрешить проблему.

вызваны только случайными причинами, и наше уравнение регрессии действительно описывает реальную связь. Если величина F окажется меньше значения, которое в таблице отвечает пятипроцентному уровню значимости, мы принимаем предположение, что связи между объясняющими переменными и величинами yi реально не выявлено. И как обычно промежуточный случай означает некую неопределенность – избранный нами критерий не может достаточно надежно разрешить проблему.

Заметим еще, что формулу (2.8) несложно обратить, получив критические значения параметра

(2.9)

(2.9)

Здесь мы выбираем из таблиц критические значения критерия Фишера, отвечающие нашему числу степеней свободы и выбранному нами уровню значимости (5% или 1%, для критерия Фишера иногда используют и уровень 0,1%). Если полученная нами величина  превышает критическую при 1%-ном уровне значимости, у нас нет оснований полагать, что наша модель неадекватна. При величине

превышает критическую при 1%-ном уровне значимости, у нас нет оснований полагать, что наша модель неадекватна. При величине  меньшей, чем та, что отвечает 5%-ному уровню значимости, у нас нет оснований отвергнуть нулевую гипотезу – а она, напомню, состоит в том, что все совпадения между моделью и реальностью носят случайный характер.

меньшей, чем та, что отвечает 5%-ному уровню значимости, у нас нет оснований отвергнуть нулевую гипотезу – а она, напомню, состоит в том, что все совпадения между моделью и реальностью носят случайный характер.

2018-02-14

2018-02-14 420

420