Элементы теории информации.

Лекция 32.

Количественная мера информации. Из определения информации как совокупности неизвестных для получателя сведений следует, что в общем случае дать оценку количества информации довольно затруднительно, так как всякое подлежащее передаче сообщение имеет свое содержание, свой смысл и определенную ценность для получателя. Одно и то же сообщение может давать одному получателю много информации, другому мало. Однако содержательная сторона сообщений несущественна для теории и техники связи и поэтому не учитывается при определении количественной меры информации.

В основу измерения количества информации положены вероятностные характеристики передаваемых сообщений, которые не связаны с конкретным содержанием сообщений, а отражают степень их неопределенности (неожиданности). Естественно, что чем меньше вероятность сообщения, тем больше информации оно несет.

Логарифмическая мера, впервые предложенная в 1928 г. английским ученым Р. Хартли, обладает свойством аддитивности, что соответствует нашим интуитивным представлениям об информации (сведения, полученные от двух источников, складываются). Кроме того, при Р(а) = 1 количество информации равно нулю, что соответствует принятому определению информации (сообщение об известном событии никакой информации не несет).

|

|

|

Энтропия источника. Большинство реальных источников выдают сообщения с различными вероятностями. Например, в тексте буквы А, Е, О встречаются сравнительно часто, а Щ, Ы, Ъ — редко. При разных вероятностях сообщения несут различное количество информации. При решении большинства практических задач необходимо знать среднее количество информации, приходящееся на одно сообщение.

Термин «энтропия» заимствован из термодинамики, где выражение характеризует среднюю неопределенность состояния системы молекул вещества. В теории информации этот термин и способ вычисления введен в 1948 г. американским ученым К. Шенноном и далее более строго определен советскими математиками А. Я- Хинчиным и А. Н. Колмогоровым. Физически энтропия Я (Л) выражает среднюю неопределенность состояния источника сообщений и является объективной информационной характеристикой источника. Энтропия всегда положительна и принимает максимальное значение.

Для источника с зависимыми сообщениями энтропия также вычисляется как математическое ожидание количества информации этих сообщений. Следует отметить, что полученное в этом случае значение энтропии меньше, чем источника независимых сообщений. Это физически следует из того, что при наличии зависимости сообщений неопределенность выбора уменьшается и, соответственно, уменьшается энтропия. Так, в тексте после сочетания «чт» вероятнее всего, что третьей буквой будет «о» и маловероятно появление в качестве третьей буквы «ж» или «ъ». В среднем сочетание «что» несет меньше информации, чем эти буквы в отдельности.

|

|

|

Избыточность источника. Под избыточностью всегда понимают что-то лишнее (ненужное). Что же избыточное (лишнее) имеется в источнике, выдающим какую-то информацию? Избыточными в источнике считаются сообщения, которые несут малое, а иногда и нулевое, количество информации. Время на их передачу тратится, а информации передается мало. Наличие избыточности означает, что часть сообщений можно и не передавать по каналу связи, а восстановить на приеме по известным статистическим связям. Так и поступают при передаче телеграмм, исключая из текста союзы, предлоги, знаки препинания, поскольку они легко восстанавливаются по смыслу телеграммы на основании известных правил построения фаз.

Избыточность при передаче сообщений имеет свои положительные и отрицательные стороны. Увеличение избыточности приводит к увеличению времени передачи сообщений, излишней загрузке каналов связи. За заданный промежуток времени по каналу передается меньшее количество информации, чем это возможно, поэтому одной из задач теории информации и техники кодирования является задача сокращения избыточности.

Однако при увеличении избыточности появляется возможность повышения помехоустойчивости передачи сообщений. Так, избыточность текста позволяет легко исправлять отдельные ошибки или восстанавливать пропуски букв или даже слов в телеграмме. У русского, да и у всех европейских языков, избыточность с учетом всех статистических зависимостей букв примерно одинакова. Она сформировалась в результате длительной, общественной практики на основе требований исправления искажения слов и фраз под воздействием различных мешающих факторов. При практическом выполнении систем связи устанавливается компромиссное значение избыточности, обеспечивающее заданные скорость и надежность передачи сообщений.

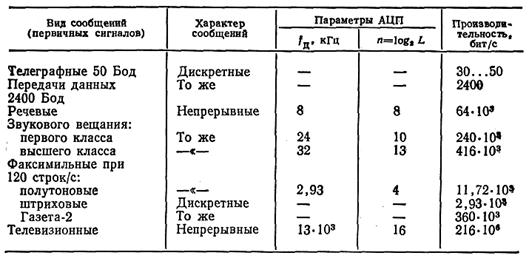

Производительность источников сообщений

Производительность источника сообщений является одной иэ основных его характеристик, так как каналы передачи сообщений должны строиться так, чтобы обеспечить передачу выдаваемого источником количества информации. Для типовых первичных сигналов, считая, что преобразователь сообщения — первичный сигнал — не вносит искажений, расчеты производительности сведены в таблицу. При подсчете производительности источников непрерывных сообщений (первичных сигналов) считалось, что распределение уровней квантования равновероятно и АЦП обеспечивает высокое качество (малый шум квантования).

2014-02-02

2014-02-02 4179

4179