Глубинная интеграция нечетких систем и нейросетей связана с разработкой моделей нейронов, функции которых отличаются от функций традиционного нейрона.

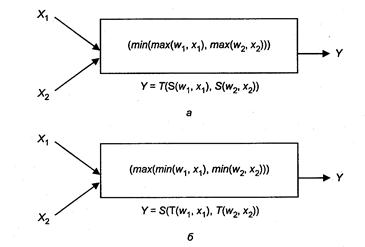

Рисунок 9.1 – Примеры нечётких нейронов:

а) И-нейрон, б) ИЛИ-нейрон.

Модификация модели нейрона для адаптации к нечетким системам касается выбора функции активации, реализации операций сложения и умножения, так как в нечеткой логике сложение моделируется любой треугольной конормой (например, max, a + b — a b,...),a операция умножения – треугольной нормой (min, a • b,...).

b,...),a операция умножения – треугольной нормой (min, a • b,...).

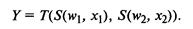

И-нейроном называется нейрон, в котором умножение веса w на вход х моделируется конормой S(w, x), а сложение нормой T(w, x). Для двухвходового И-нейрона справедлива формула:

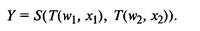

ИЛИ-нейроном называется нейрон, в котором умножение веса w и входа х моделируется нормой T(w, х), а сложение взвешенных весов – конормой S(w, у). Для двухвходового ИЛИ-нейрона справедлива формула:

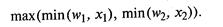

Если выбрать в качестве Т — min, а S — max, то формула преобразования ИЛИ-нейрона уточняется следующим образом:

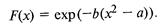

В качестве функции активации обычно используют радиальную базисную функцию:

Нечеткой нейронной сетью (ННС) называют четкую нейронную сеть прямого распространения сигнала, которая построена на основе многослойной архитектуры с использованием И-, ИЛИ-нейронов.

Нечеткая нейросеть функционирует стандартным образом на основе четких действительных чисел. Нечеткой является только интерпретация результатов. При создании гибридной технологии можно использовать нейрокомпъютинг для решения частной задачи нечетких экспертных систем, а именно настройки параметров функции принадлежности.

Традиционно функции принадлежности формируют двумя способами: методом экспертной оценки или на основе статистики. Гибридные технологии предлагают третий способ: в качестве функции принадлежности выбирается параметризованная функция формы (например, параметризованная Гауссова кривая), параметры которой настраиваются с помощью нейросетей. Настройка параметров может быть получена с помощью алгоритма обратного распространения ошибки.

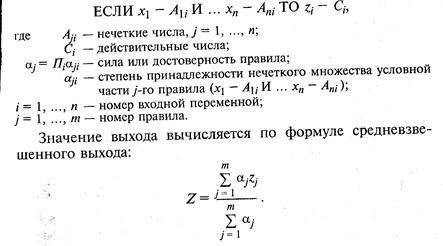

Рассмотрим его применение для обучения ННС. Пусть задана следующая система нечетких правил:

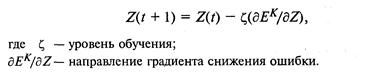

Допустим, что разработана нейросеть с п входами и одним выходом. Каким образом такая НС может аппроксимировать базу нечетких правил? Любая совокупность нечетких продукций может рассматриваться как нелинейное соответствие, заданное таблицей определения {(xk, yk}}, где k= 1,..., К – номер строки-образца в обучающей выборке, х – вектор входа, у – желаемое значение выхода, a z – значение выхода, вычисляемое нейросетью. Если определить текущую ошибку с помощью формулы  , то можно применить стандартный алгоритм коррекции ошибки, корректируя выход Z по следующему правилу:

, то можно применить стандартный алгоритм коррекции ошибки, корректируя выход Z по следующему правилу:

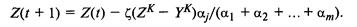

Подставляя в правило формулу для средневзвешенного выхода ННС, получим:

При применении стандартного алгоритма обратного распространения ошибки для настройки выхода НС необходимо изменить параметры функций принадлежности условных частей правил, т. е. обучение сети позволит настроить их на обучающую выборку.

2014-02-09

2014-02-09 1181

1181