Автоматическую каталогизацию Web-pecypcoв и удовлетворение запросов клиентов выполняют так называемые поисковые указатели. Из процесса наполнения базы данных поисковой системы исключается человеческий фактор. При этом значительно падает качество ссылок, предоставляемых системой по результатам поиска, но одновременно увеличивается их количество.

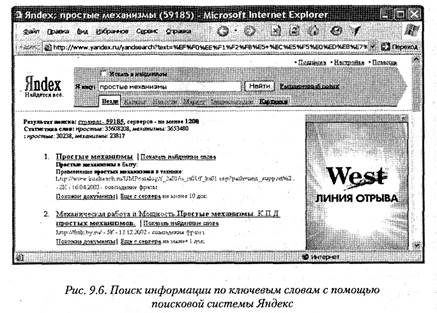

Основной принцип работы поискового указателя заключается в поиске Web-pecyр сов по ключевым словам. Пользователь описывает искомый ресурс с помощью ключевых слов, после чего дает задание на поиск. Поисковая система анализирует данные, хранящиеся в своей базе, и выдает список Web-страниц, соответствующих запросу. Вместе с гиперссылками выдаются краткие сведения о найденных ресурсах, на основании которых пользователь может выбрать нужные ему ресурсы (рис. 9.6).

Разные поисковые указатели применяют разные информационные технологии для обработки запросов пользователей. Чтобы эффективно выполнять поиск информации в WWW, надо хотя бы в общих чертах понимать принципы их работы.

Три этапа работы поискового указателя. Работу поискового указателя можно условно разделить на три этапа. Из них два этапа являются подготовительными — они незаметны для клиента, и лишь на третьем этапе происходит взаимодействие с пользователем, но от каждого из этапов зависят функциональные свойства поисковой системы и эффективность работы с ней.

Сбор первичной базы данных. На первом этапе поисковая система занимается сканированием информационного пространства World Wide Web. Для этого используют специальные агентские программы — черви. Не следует путать агентов поисковых систем с разновидностью сетевых компьютерных вирусов, тоже именуемых червями. Черви поисковых систем совершенно безобидны для серверов и клиентов WWW. По своей сути это очень эффективные малоразмерные браузеры. Им не надо выполнять функции просмотра и воспроизведения содержимого — их задача состоит только в том, чтобы автоматически разыскивать Web-ресурсы, следуя по гиперссылкам, и, убедившись, что этот ресурс системе еще не известен, копировать его в свою базу данных. Так же происходит и обновление ранее принятых документов, но измененных за время после предыдущего копирования.

Индексация базы данных. Собрать базу данных сетевых Web-pecypcoв — еще не значит получить функционирующую поисковую систему. Поиск ключевых слов, введенных пользователем, в обширной базе — это весьма продолжительная операция. Чтобы не задерживать клиента более чем на доли секунды, собранные базы данных проходят предварительную обработку, называемую индексацией. На этапе индексации создаются специализированные документы — поисковые указатели.

Рафинирование результирующего списка. Это третий этап работы, в ходе которого осуществляется взаимодействие с пользователем. На этом этапе создается список ссылок, который будет передан пользователю в качестве результирующего. Пользовательское представление о качестве работы поисковой системы напрямую зависит от технологий, использованных на этом этапе.

Рафинирование заключается в фильтрации и ранжировании результатов поиска. Под фильтрацией понимается отсев ссылок, которые выдавать пользователю нецелесообразно. Прежде всего проверяется наличие дубликатов. Если система в одном списке выдает множество ссылок, ведущих к одному и тому же Web-pecypcy, это говорит о том, что ее средства добросовестно отработали два первых этапа, но ничего не сделали на третьем этапе. Дублирующиеся ссылки перегружают результирующий список и затрудняют выбор действительно полезных ресурсов.

Ранжирование заключается в создании специального порядка представления результирующего списка, при котором наиболее «полезные» (с точки зрения поисковой системы) ссылки приводятся в вершине списка, а наименее полезные — в его конце. Понимание критерия «полезности» для клиента той или иной ссылки может быть самым разнообразным. Именно поэтому разные поисковые системы, даже работающие с одинаковыми базами ресурсов, выдают разные результаты поиска.

2015-06-24

2015-06-24 535

535