Существует множество систем представления данных. С одной из них, принятой в информатике и вычислительной технике, двоичным кодом, мы познакомились выше. Наименьшей единицей такого представления является бит (двоичный разряд).

Совокупность двоичных разрядов, выражающих числовые или иные данные, образует некий битовый рисунок. Практика показывает, что с битовым представлением удобнее рабо-

«Информатика». Коломейченко А.С. 12

тать, если этот рисунок имеет регулярную форму. В настоящее время в качестве таких форм используются группы из восьми битов, которые называются байтами.

Десятич- ное число

Двоичное число

Байт 1 1 0000 0001 2 10 00000010

255 11111111 1111 1111

Понятие о байте как о группе взаимосвязанных битов появилось вместе с первыми образцами электронной вычислительной техники. Долгое время оно было машин- нозависимым, то есть для разных вычислительных машин длина байта была разной. Только в конце 60-х годов понятие байта стало универсальным и машиннонезависимым.

Выше мы видели, что во многих случаях целесообразно использовать не восьми- разрядное кодирование, а 16-разрядное, 24-разрядное, 32-разрядное и более. Группа из 16 взаимосвязанных битов (двух взаимосвязанных байтов) в информатике называется словом. Соответственно, группы из четырех взаимосвязанных байтов (32 разряда) называются удво- енным словом, а группы из восьми байтов (64 разряда) — учетверенным словом. Пока, на се- годняшний день, такой системы обозначения достаточно.

Единицы измерения данных Существует много различных систем и единиц измерения данных. Каждая научная дисциплина и каждая область человеческой деятельности может использовать свои, наибо- лее удобные или традиционно устоявшиеся единицы. В информатике для измерения данных используют тот факт, что разные типы данных имеют универсальное двоичное представле- ние, и потому вводят свои единицы данных, основанные на нем.

Наименьшей единицей измерения является байт. Поскольку одним байтом, как пра- вило, кодируется один символ текстовой информации, то для текстовых документов размер в байтах соответствует лексическому объему в символах (пока исключение представляет рас- смотренная выше универсальная кодировка UNICODE).

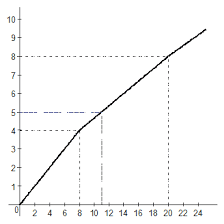

Более крупная единица измерения — килобайт (Кбайт). Условно можно считать, что 1 Кбайт примерно равен 1000 байт. Условность связана с тем, что для вычислительной техни- ки, работающей с двоичными числами, более удобно представление чисел в виде степени двойки, и потому на самом деле 1 Кбайт равен 2

байт (1024 байт). Однако всюду, где это не принципиально, с погрешностью до 3% «забывают» о «лишних» байтах.

В килобайтах измеряют сравнительно небольшие объемы данных. Условно можно считать, что одна страница неформатированного машинописного текста составляет около 2 Кбайт.

Более крупные единицы измерения данных образуются добавлением префиксов мега-, гига- тера- более крупных единицах пока нет практической надобности.

1 Мбайт = 1024 Кбайт = 220 байт 1 Гбайт = 1024 Мбайт = 230 байт 1 Тбайт = 1024 Гбайт = 2

байт Особо обратим внимание на то, что при переходе к более крупным единицам погреш- ность, связанная с округлением, накапливается и становится недопустимой, поэтому на старших единицах измерения округление производится реже.

Единицы хранения данных При хранении данных решаются две проблемы: как сохранить данные в наиболее компактном виде и как обеспечить к ним удобный и быстрый доступ (если доступ не обеспе- чен, то это не хранение). Для обеспечения доступа необходимо, чтобы данные имели упоря- доченную структуру, а при этом, как мы уже знаем, образуется «паразитная нагрузка» в виде адресных данных. Без них нельзя получить доступ к нужным элементам данных, входящих в структуру. Поскольку адресные данные тоже имеют размер и тоже подлежат хранению, хра- нить данные в виде мелких единиц, таких, как байты, неудобно. Их неудобно хранить и в бо-

«Информатика». Коломейченко А.С. 13

лее крупных единицах (килобайтах, мегабайтах и т. п.), поскольку неполное заполнение од- ной единицы хранения приводит к неэффективности хранения. В качестве единицы хранения данных принят объект переменной длины, называемый файлом. Количество информации Какое количество информации содержится, к примеру, в тексте романа "Война и мир", во фресках Рафаэля или в генетическом коде человека? Ответа на эти вопросы наука не даѐт и, по всей вероятности, даст не скоро. А возможно ли объективно измерить количество ин- формации? Важнейшим результатом теории информации является следующий вывод:

В определенных, весьма широких условиях можно пренебречь качественными особенностями информации, выразить еѐ количество числом, а также срав- нить количество информации, содержащейся в различных группах данных.

В настоящее время получили распространение подходы к определению понятия "количество информации", основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле еѐ новизны или, иначе, уменьшения неопределѐнности наших знаний об объекте. Эти подходы используют математические понятия вероятно- сти и логарифма.

Подходы к определению количества информации. Формулы Хартли и Шеннона. Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматри- вал как выбор одного сообщения из конечного наперѐд заданного множества из N рав- новероятных сообщений, а количество информации I, содержащееся в выбранном со- общении, определял как двоичный логарифм N.

Формула Хартли: I = log

N

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле Хартли можно вычислить, какое количество информации для этого требуется: I = log

6,644. Таким образом, сообщение о верно угаданном числе содержит количество информации, при- близительно равное 6,644 единицы информации. Приведем другие примеры равновероятных сообщений:

1. при бросании монеты: "выпала решка", "выпал орел"; 2. на странице книги: "количество букв чѐтное", "количество букв нечѐтное". Определим теперь, являются ли равновероятными сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, напри- мер, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и жен- щины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины. Для задач такого рода американский учѐный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинако- вую вероятность сообщений в наборе.

Формула Шеннона: I = — (p

), где p

i

Log

p

+ p

Log

p

+... + p

N

Log

p

2018-01-08

2018-01-08 396

396