4.1 Количественное определение информации.

Любая передаваемое сообщение содержит в себе определенное количество информации о каком-либо событии (или об отсутствии такового).

С точки зрения получателя информации, чем неожиданнее событие, тем больше информации в сообщении.

Задача придания численного выражения степени неожиданности сообщения решается методами теории вероятности. Необходимость придания численного значения информации обсуждалось в работе Р. Хартли еще в 1928 году, в которой он предложил логарифмическую меру информации. В последующих работах американского ученого К. Шеккона (1948) и советского ученого В. А. Котельникова (1946) «Теория потенциальной помехоустойчивости и теория информации» сформулированы основные положения и теоремы теории информации.

Логарифмический подход придания численного значения информации, полученной из сообщения, разберем на примере:

Если по каналу связи передается сообщение о событии, вероятность которого до свержения (до передачи) – априорная была Р1, а после приема сообщения стала – апостериорно равной Р2, то прирост количества информации, связанной с приемом сообщения, определяется соотношением этих вероятностей, таким образом, полученное количество информации I можно определить формулой:

I = log  = log P2 – log P1 (4.1)

= log P2 – log P1 (4.1)

Применение логарифмической функции для количественной оценке прироста информации дает существенные преимущества:

1) Полная информация, содержащаяся в сообщении, состоящем из нескольких элементов, может быть получена сложением количества информации, содержащейся в этих элементах;

2) Если канал связи идеален, то есть в нем отсутствуют помехи и искажения и, следовательно, принятое сообщение вполне достоверно, то приведенное выражение (4.1) упрощается, поскольку Р2 = 1, а logР2 = 0, тогда для I имеем:

I = - log P1 (4.2)

Поскольку первоначальная вероятность всегда находится в пределах между «нулем» и «единицей», то количество информации всегда положительно, то есть I ≥ 0 всегда.

Численное значение I зависит от основания логарифма. Учитывая, что технические средства передачи и счета дискретной информации чаще всего используют два различных состояния («0» и «1»), т.е. Объем алфавита =2, то для определения I выгодно использовать логарифм с основанием 2.

Тогда единица количества информации соответствует сообщению о том, что произошло одно из двух равновероятных событий. Она называется двоичной единицей информации или битом.

I=log2 P2 – log2 P1 =1бит. (4.3)

Если в вычислениях использовать десятичный логарифм (log), то количество информации будет в «дитах», а если использовать натуральный логарифм (ln), то I будет в «нитах».

Наряду с абсолютным количеством информации, содержащимся в сообщении, употребляется понятие «удельной информативности», или «Энтропии сообщения». Под энтропией сообщения (Н) понимается Среднее количество информации, приходящиеся на один символ сообщения:

Н = I1 = (бит/букву) (4.4)

(бит/букву) (4.4)

Энтропия характеризует сообщение с точки зрения его насыщенности информацией. Чем больше энтропия, тем больше информации воспринимается в единицу времени (при одинаковой скорости передачи букв сообщения).

4.2 Дискретный источник информации. Его характеристики и модели.

Дискретными – называют источники информации, сообщения которых представляют собой последовательности четко различимых знаков, букв, цифр, символов, принадлежащих конечному упорядоченному множеству.

Образующие сообщения символы называют буквами, а упорядочные множества – алфавитами. Конечный алфавит, состоящий из № букв, будем обозначать:

А=(а1, а2, а3,....., аN)

или (4.5)

(i = 1, 2, 3,...., N)

(i = 1, 2, 3,...., N)

Например, типичным дискретным источником может служить выход телеграфного аппарата.

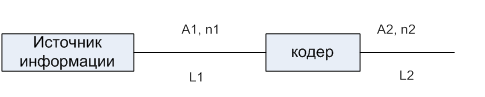

Дискретный источник следует представлять из двух частей (рис.4.1.)

| Текст |

| Считывающее устройство |

Рис.4.1

Текст – определяет содержание и ценность информации

Считывающее устройство – скорость передачи во времени.

(скорость передачи – определяется физическими характеристиками считывающего устройства и скоростью переходных процессов в канале передачи.)

4.2.1 Дискретный источник информации, работающий равновероятными и

независимыми буквами.

Рассмотрим схему (рис.4.2.)

Рис.4.2

Пусть источник информации пользуется алфавитом

A1 =(а1, а2, а3,....., аN1)

и вырабатывает сообщения, одинаковой длины n1.(Длина сообщения – это число букв в нем).

n1 – может быть и больше N1, т.к. многие буквы могут входить в сообщение несколько раз.

При равновероятности этих букв число таких сообщений L1 определяется как число размещений с повторениями из N1 букв по n1;

L1 = N (4.6.)

(4.6.)

Действительно, число трех элементных двоичных комбинаций 8 = 23 и т.д.

001 011 000

010 101 111 = 8 = 23 n=3, N=2

100 110

Допустим, что сообщение источника с алфавитом А1 необходимо перекодировать с использованием алфавита А2 = (0,1), т. е двоичного кода N2 = 2.

В этой связи, длина двоичных кодовых комбинаций n2 должна удовлетворять соотношению:

L2 = 2n2 ≥ L1 = N (4.7)

(4.7)

Переходя к равенству, получим, что

n2 = n1 log2 N1 (4.8)

(4.8) – определяет наименьшее число двоичных знаков n2 двоичного сообщения, в которое следует кодировать сообщение n1, написанное алфавитом А1.

Поскольку сообщение до и после кодирования несет одну и ту же информацию, то каждая буква до и после кодирования несет разное количество информации.

Пусть А1 – это Кириллица (N1 = 32 буквы), а n1 = 1 (сообщения однобуквенные) по формуле (4.8)

n2 = log2N1 = log232 = 5

т. е для кодирования одной буквы Кириллицы требуется 5 двоичных знаков.

Из-за большой распространенности двоичных кодов удобно за единицу количества информации принять ее наибольшее значение, переносимое одной буквой двоичного алфавита, что наблюдается при равновероятности и независимости букв в сообщении. Такую единицу называют Бит.

Таким образом, если каждая буква двоичного кода несет 1 бит информации, то ее количество в тексте

I =log2N (4.9)

Где N- объем алфавита, перекодируемого в двоичный. (В случае равновероятности и независимости 1 и 0 в двоичном сообщении).

Если А1 = (0,1); (N1 = 2); I = log22 = 1 (бит/букву)

В вычислительной технике для измерения количества информации часто применяют более крупную единицу:

Байт = 8 Бит

Сообщение содержащее 4 Байта называют – словом.

1 слово = 4 байта = 32 бита.

Совокупность (4.7) и (4.9), определяющих возможное число различных сообщений и количество информации в каждой букве, задает модель источника работающего равновероятными и независимыми буквами.

L2 = 2n2 ≥ L1 = N

I = log2N (4.10)

Из (4.9) следует, что количество информации обладает обязательным свойством – аддитивностью.

Действительно, пусть, например, имеются два одинаковых источника информации, работающих десятибуквенными алфавитами:

А = (0, 1, 2,..., 9)

Каждый из них может давать десять различных простейших сигналов 0….9.

Если использовать два таких источника совместно, то от них можно получить 100 различных двухбуквенных сочетаний 00,01, ….., 99.

В этих сочетаниях первая цифра передается первым источником, а вторая-вторым.

Таким образом, два источника с 10-буквенными алфавитами А=(0,1,…,9) образовали источник со 100-буквенным алфавитом А=(00,01,…,99).

Количество информации, передаваемой двумя одинаковыми источниками должно быть в 2 раза больше, чем одним. Этому условию как раз удовлетворяет формула (4.9), так как

I = log2 100 = log2 102 = 2log2 10.

Таким образом, количество информации выдаваемой двумя одинаковыми источниками – удваивается.

4.2.2 Модель источника, работающего не равновероятными и не зависимыми буквами (источник без памяти).

Рассмотрим уже известный случай, когда источник информации работает алфавитом из № букв и все буквы встречаются в тексте одинаково часто и таким образом равновероятны. Тогда вероятность какой-либо одной i-той буквы будет:

P(ai) = P =  (4.11)

(4.11)

Вероятность P(ai) характеризует состояние неопределенности, существующее до появления очередной буквы сообщения ai. Чем P(ai) меньше, тем неопределенность больше.

В соответствии с (4.11) (4.9) может быть переписана в виде

I=log2N=log2 = -log2P. (4.12)

= -log2P. (4.12)

Определение:

Количество информации, приносимое буквой ai и устраняющее имеющуюся неопределенность, является мерой этой неопределенности.

Только то сообщение приносит информацию, которое устраняет имеющуюся неопределенность до поступления сообщения.

Формула (4.12) для всего последующего курса является основной, так как выражает зависимость количества информации в сообщении о ком-либо событии от вероятности последнего.

Допустим (что бывает довольно часто), что буквы в сообщениях данного источника информации появляются неодинаково часто, и для каждой буквы ai имеется определенная вероятность ее появления: P(ai).

Для стационарных эргодических источников информации, если все буквы алфавита взаимонезависимы, алфавит и вероятносные свойства источника информации удобно задавать таблицей, указывающей вероятности появления каждой из букв:

Табл.4.1

| а1 | а2 | а3 | …… | аi | …….. | аN |

| Р(а1) | Р(а2) | Р(а3) | …… | Р(аi) | …….. | Р(аN) |

Табл.4.1 определяет состояние неопределенности перед получением очередной буквы аi в случае неодинаковых р(аi) чем более равномерно распределены р(аi), тем больше неопределенность.

Если некоторые р(аi) велики, а остальные малы, то неопределенность меньше.

Табл.4.1 характеризует так же информационные свойства любого достаточно длительного сообщения

Определим количество информации, содержащееся в некотором n – буквенном сообщении источника.

Пусть n >> N

Пусть, так же, в этом сообщении буква а1 встречается n1 раз, буква а2 – n2 раз, и т.д.

n1 + n2 + ……+ ni + ……..+ nN = n

n – длина сообщения.

Используя формулу (4.12), найдем, что буква аi несет количество информации.

Ii = -log2 p(ai)

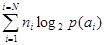

ni и ai несут ni∙Ii единиц информации. Таким образом, всего информации (бит) в сообщении из n букв будет:

I = - (4.13)

(4.13)

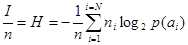

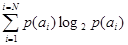

Для определения среднего количества информации, переносимого одной буквой, разделим (4.13) на число букв n в сообщении.

(4.14)

(4.14)

При большом n (т.е. при n  )

)  , т.е.

, т.е.

H = - (4.15)

(4.15)

Где Н – это количество информации (бит), содержащееся в одной букве сообщения источника в среднем при неравномерности и независимости букв.

Оно является численной мерой неопределенности, существующей, перед получением очередной буквы сообщения и называется энтропией источника информации.

При измерении энтропии Н в битах, она определяет минимальное количество двоичных знаков, необходимое для кодирования одной буквы исходного сообщения.

2014-02-09

2014-02-09 5296

5296