Как и в случае регрессионного уравнения с одной переменной, целью метода является выбор вектора оценок b, минимизирующего сумму квадратов остатков et (квадрат длины вектора остатков e):

.

.

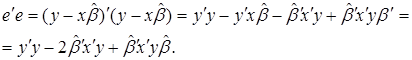

Выразим e`e через x и b:

| (44) |

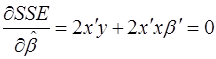

Необходимые условия минимума SSE получаются дифференцированием уравнения (44) по вектору b:

, (45)

, (45)

откуда, учитывая обратимость матрицы X`X, находим оценку метода наименьших квадратов:

bOLS = (x`x)-1 x`y. (46)

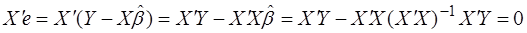

Покажем, что, как и в случае одного регрессора, формула (45) означает, что вектор остатков e ортогонален всем независимым переменным x1,…,xk (столбцам матрицы X). Условие x1e =…= x`ke = 0 эквивалентно равенству x`e = 0.

Действительно,

. (47)

. (47)

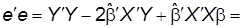

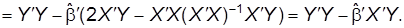

Получим полезную в дальнейшем формулу для суммы квадратов остатков:

(48)

(48)

Геометрическая интерпретация в основном совпадает с геометрической интерпретацией регрессионного уравнения с одной независимой переменной.

Представим Y, x1, …, xk как векторы в n-мерном евклидовом пространстве Rn. Векторы x1, …,.xk образуют k-мерное подпространство p.

|

|

|

Вектор  есть ортогональная проекция вектора Y на гиперплоскость p.

есть ортогональная проекция вектора Y на гиперплоскость p.

Вектор остатков e = y - y ортогонален подпространству p.

Как и в случае регрессионного уравнения с одной независимой переменной, можно показать, что оценка метода наименьших квадратов является оптимальной.

2014-02-24

2014-02-24 741

741