Информация

Понятие информации

Непрерывное сообщение может быть представлено непрерывной функцией, заданной на некотором интервале. Непрерывное сообщение можно преобразовать в дискретное (такая процедура называется дискретизацией). Любое непрерывное сообщение может быть представлено как дискретное, иначе говоря, последовательностью знаков некоторого алфавита.

Возможность дискретизации непрерывного сигнала с любой желаемой точностью (для возрастания точности достаточно уменьшить шаг) принципиально важна с точки зрения информатики. Компьютер – цифровая машина, т.е. внутреннее представление информации в нем дискретно. Дискретизация входной информации позволяет сделать её пригодной для компьютерной обработки.

Кодирование информации. Системы счисления.

У понятия «количество информации» существует два основных подхода:

вероятностный – развитый американским математиком Клодом Шенноном;

объёмный – возникший вследствие работ по созданию ЭВМ.

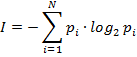

Сообщения обычно содержат информацию о каких – либо событиях. Количество информации для событий с различными вероятностями определяется по формуле Шеннона:

I – количество информации;

N – количество возможных событий;

pi – вероятности отдельных событий.

Если события равновероятны, то количество информации определяется по формуле Хартли:

или из показательного уравнения:

Для количественного выражения любой величины необходимо сначала определить единицу измерения.

За единицу количества информации принят 1 бит – количество информации, содержащееся в сообщении, уменьшающем неопределенность знаний в два раза.

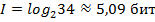

Пример. Определить количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 33 букв и знака «пробел» для разделения слов. Тогда по формуле Хартли

.

.

Очевидно, что в словах любого языка, различные буквы встречаются с неодинаковой частотой. Воспользовавшись известной таблицей вероятностной частоты употребления различных знаков русского алфавита и формулой Шеннона получим  .

.

Объёмный подход

В двоичной системе счисления знаки 0 и 1 называют битами (от английского выражения Binary digiTs – двоичные цифры). В компьютере бит является наименьшей единицей информации. Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по числу требуемых для такой записи двоичных символов. При этом, в частности, не возможно нецелое число битов (в отличие от вероятностного подхода).

Для удобства использования введены и более крупные, чем бит, единицы количества информации. Так, двоичное слово из восьми знаков содержит один байт информации.

1 байт=8 битов=23 битов

1 Кбайт=210 байт=1024 байт

1 Мбайт=210 Кбайт=1024 Кбайт

1 Гбайт=210 Мбайт=1024 Мбайт

В прикладной информатике практически всегда количество информации понимается в объёмном смысле.

Контрольные вопросы и задания для самостоятельного выполнения.

1. Какие определения понятия «информации» вы знаете?

2. Назовите основные свойства информации?

3. Каким образом возникает, хранится, обрабатывается и передается информация?

4. Какая форма представления информации – непрерывная или дискретная – приемлема для компьютеров и почему?

5. Что такое количество информации?

6. Каковы основные единицы измерения количества информации?

7. Приведите объёмы памяти известных Вам носителей информации.

8. Заполните пропуски числами:

a) 6 Кбайт=__байт=__ бит;

b) __ Кбайт=__байт=12288 бит;

c) __ Кбайт=__байт=215бит;

d) __Гбайт=1536Мбайт= __ Кбайт.

2015-06-26

2015-06-26 482

482