КУРСОВАЯ РАБОТА

на тему:

«Анализ регрессии в изучении экономических проблем»

Студентка 2 курса, группа 202-К, специальность «экономическая киберенетика»

Зворская А.В.

Научный руководитель

ф-м.к.н.,доц., Попов В.Б.

Симферополь 2010

СОДЕРЖАНИЕ

ВВЕДЕНИЕ………………………………………………………………………….3

РАЗДЕЛ 1. РЕГРЕССИОННЫЙ АНАЛИЗ………………………………………..4

РАЗДЕЛ 2 МНОЖЕСТВЕННАЯ ЛИНЕЙНАЯ РЕГРЕССИЯ……………………5

2.1 Определение параметров уравнения регрессии………………………………5

2.2 Расчет коэффициентов множественной линейной регресcии……………….9

2.3 Дисперсии и стандартные ошибки коэффициентов…………………………13

2.4 Интервальные оценки коэффициентов теоретического

уравнения регресcии…………………………………………………………..15

2.5 Анализ качества эмпирического уравнения множественной линейной регрессии………………………………………………………………………16

2.6 Проверка статистической значимости коэффициентов

уравнения регрессии………………………………………………………….16

2.7 Проверка общего качества уравнения регрессии……………………………17

2.8 Анализ статистической значимости коэффициента детерминации………..19

2.9 Проверка равенства двух коэффициентов детерминации…………………..21

2.10 Проверка гипотезы о совпадении уравнений регрессии

для двух выборок……………………………………………………………..23

РАЗДЕЛ 3 ЛИНЕЙНАЯ РЕГРЕССИЯ…………………………………………..25

ВЫВОДЫ…………………………………………………………………………..30

СПИСОК ИСПОЛЬЗОВАННОЙ ЛИТЕРАТУРЫ…………………………….....31

Введение

Постоянно усложняющиеся экономические процессы потребовали создания и совершенствования особых методов изучения и анализа. Широкое распространение получило использование моделирования и количественного анализа. На этом этапе выделилось и сформировалось одно из направлений экономических исследований – эконометрика.

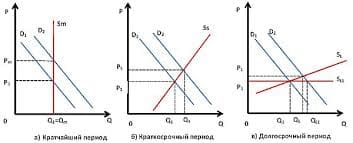

Эконометрика как научная дисциплина зародилась и получила развитие на основе слияния экономической теории, математической экономики, экономической статистики и математической статистики. Действительно, предметом ее исследования являются экономические явления. Но в отличие от экономической теории эконометрика делает упор на количественные, а не на качественные аспекты этих явлений. Например, экономическая теория утверждает, что спрос на товар с ростом его цены убывает. Но при этом практически неисследованным остается вопрос, как быстро и по какому закону происходит это убывание.

Эконометрика отвечает на этот вопрос для каждого конкретного случая. Изучение экономических процессов (взаимосвязей) в эконометрике осуществляется через математические (эконометрические) модели. В этом видится ее родство с математической экономикой. Но если математическая экономика строит и анализирует эти модели без использования реальных числовых значений, то эконометрика концентрируется на изучении моделей на базе эмпирических данных.

Одной из основных задач экономической статистики является сбор, обработка и представление экономических данных в наглядной форме в виде таблиц, графиков, диаграмм. Эконометрика также активно пользуется этим инструментарием, но идет дальше, используя его для анализа экономических взаимосвязей и прогнозирования. Мощным инструментом эконометрических исследований является аппарат математической статистики.

Цель работы: анализ экономических методов и моделей.

Задачи:

1 Обзор литературы;

2 Построение эконометрических моделей;

3 Оценка параметров построенной модели;

4 Проверка качества найденных параметров модели.

РАЗДЕЛ 1.

Регрессионный анализ

Регрессионный анализ — метод моделирования измеряемых данных и исследования их свойств. Данные состоят из пар значений зависимой переменной (переменной отклика) и независимой переменной (объясняющей переменной). Регрессионная модель есть функция независимой переменной и параметров с добавленной случайной переменной. Параметры модели настраиваются таким образом, что модель наилучшим образом приближает данные. Критерием качества приближения(целевой функцией) обычно является среднеквадратичная ошибка: сумма квадратов разности значений модели и зависимой переменной для всех значений независимой переменной в качестве аргумента. Регрессионный анализ — раздел математической статистики и машинного обучения. Предполагается, что зависимая переменная есть сумма значений некоторой модели и случайной величины. Относительно характера распределения этой величины делаются предположения, называемые гипотезой порождения данных. Для подтверждения или опровержения этой гипотезы выполняются статистические тесты, называемые анализом остатков. При этом предполагается, что независимая переменная не содержит ошибок. Регрессионный анализ используется для прогноза, анализа временных рядов, тестирования гипотез и выявления скрытых взаимосвязей в данных.

Цели регрессионного анализа:

1 Определение степени детерминированности вариации критериальной (зависимой) переменной предикторами (независимыми переменными)

2 Предсказание значения зависимой переменной с помощью независимой.

3 Определение вклада отдельных независимых переменных в вариацию зависимой.

Регрессионный анализ нельзя использовать для определения наличия связи между переменными, поскольку наличие такой связи и есть предпосылка для применения анализа.

РАЗДЕЛ 2.

Множественная линейная регрессия

Определение параметров уравнения регрессии

На любой экономический показатель практически всегда оказывает влияние не один, а несколько факторов. Например, спрос на некоторое благо определяется не только ценой данного блага, но и ценами на замещающие и дополняющие блага, доходом потребителей и многими другими факторами. В этом случае вместо парной регрессии

M(Y|x) = f(x) рассматривается множественная регрессия

М(Y|x1, x2, …, xm) = f(x1, x2, …, xm). (2.1)

Задача оценки статистической взаимосвязи переменных Y и X1, X2,..., Xm формулируется аналогично случаю парной регрессии. Уравнение множественной регрессии может быть представлено в виде

Y = f(β, X) + ε, (2.2)

где X = (X1, X2,..., Xm) − вектор независимых (объясняющих) переменных; β − вектор параметров (подлежащих определению); ε − случайная ошибка (отклонение); Y – зависимая (объясняемая) переменная. Предполагается, что для данной генеральной совокупности именно функция f связывает исследуемую переменную Y с вектором независимых переменных X. Рассмотрим самую употребляемую и наиболее простую из моделей множественной регрессии – модель множественной линейной регрессии. Теоретическое линейное уравнение регрессии имеет вид:

Y = β0 + β1X1 + β2X2 +... + βmXm + ε (2.3)

или для индивидуальных наблюдений i, i = 1, 2, …, n:

yi = β0 + β1xi1 + β2xi2 +... + βmxim + εi. (2.4)

Здесь β = (β0, β1,..., βm) – вектор размерности (m + 1) неизвестных параметров. βj, j = 1, 2, …, m, называется j-м теоретическим коэффициентом регрессии (частичным коэффициентом регрессии). Он характеризует чувствительность величины Y к изменению Xj. Другими словами, он отражает влияние на условное математическое ожидание

М(Y|x1, x2, …, xm) зависимой переменной Y объясняющей переменной Хj при условии, что все другие объясняющие переменные модели остаются постоянными. β0 – свободный член, определяющий значение Y, в случае, когда все объясняющие переменные Xj равны нулю. После выбора линейной функции в качестве модели зависимости необходимо оценить параметры регрессии. Пусть имеется n наблюдений вектора объясняющих переменных

X = (X1, X2, …, Xm) и зависимой переменной Y:

(xi1, xi2, …, xim, yi), i = 1, 2, …, n. Для того чтобы однозначно можно было бы решить задачу отыскания параметров β0, β1,..., βm (т. е. найти некоторый наилучший вектор β), должно выполняться неравенство n ≥ m + 1. Если это неравенство не будет выполняться, то существует бесконечно много различных векторов параметров, при которых линейная формула связи между Х и Y будет абсолютно точно соответствовать имеющимся наблюдениям. При этом, если n = m + 1, то оценки коэффициентов вектора β рассчитываются единственным образом – путем решения системы m + 1 линейного уравнения:

yi = β0 + β1x i1 + β2x i2 +... + βmx im, i = 1, 2,..., m + 1. (2.5)

Например, для однозначного определения оценок параметров уравнения регрессии Y = β0 + β1X1 + β2X2 достаточно иметь выборку из трех наблюдений (x i1,x i2, xi3, yi), i = 1, 2, 3. Но в этом случае найденные значения параметров β0, β1, β2 определяют такую плоскость

Y = β0 + β1X1 + β2X в трехмерном пространстве, которая пройдет именно через имеющиеся три точки. С другой стороны, добавление в выборку к имеющимся трем наблюдениям еще одного приведет к тому, что четвертая точка (x 41,x 42, x 43, y4) практически наверняка будет лежать вне построенной плоскости (и, возможно, достаточно далеко). Это потребует определенной переоценки параметров. Таким образом, вполне логичен следующий вывод: если число наблюдений больше минимально необходимого, т. е. n > m+1, то уже нельзя подобрать линейную форму, в точности удовлетворяющую всем наблюдениям, и возникает необходимость оптимизации, т. е. оценивания параметров α0, α1,..., αm, при которых формула дает наилучшее приближение для имеющихся наблюдений.

В данном случае число ν = n – m – 1 называется числом степеней свободы. Нетрудно заметить, что если число степеней свободы невелико, то статистическая надежность оцениваемой формулы невы-сока. Например, вероятность верного вывода (получения более точных оценок) по трем наблюдениям существенно ниже, чем по тридцати. Считается, что при оценивании множественной линейной регрессии для обеспечения статистической надежности требуется, чтобы число наблюдений, по крайней мере, в 3 раза превосходило число оцениваемых параметров.

Самым распространенным методом оценки параметров уравнения множественной линейной регрессии является метод наименьших квадратов (МНК). Напомним, что его суть состоит в минимизации суммы квадратов отклонений наблюдаемых значений зависимой переменной Y от ее значений YПрежде чем перейти к описанию алгоритма нахождения оценок коэффициентов регрессии, напомним о желательности выполнимости ряда предпосылок МНК, которые позволят проводить анализ в рамках классической линейной регрессионной модели.

Предпосылки МНК:

1 Математическое ожидание случайного отклонения εi равно нулю:

M(εi) = 0 для всех наблюдений. Данное условие означает, что случайное отклонение в среднем не оказывает влияния на зависимую переменную. В каждом конкретном наблюдении случайный член может быть либо положительным, либо отрицательным, но он не должен иметь систематического смещения. Отметим, что выполнимость M(εi) = 0 влечет выполнимость:

M(Y|X = = xi) = β0 + β1xi.

2 Дисперсия случайных отклонений εi постоянна:

D(εi) = D(εj) = σ2 для любых наблюдений i и j. Данное условие подразумевает, что несмотря на то, что при каждом конкретном наблюдении случайное отклонение может быть либо большим, либо меньшим, не должно быть некой априорной причины, вызывающей большую ошибку (отклонение).Выполнимость данной предпосылки называется гомоскедастичностью (постоянством дисперсии отклонений).

Невыполнимость данной предпосылки называется гетероскедастичностью (непосто-янством дисперсий отклонений). Поскольку D(εi) = M(εi − M(εi))2 = M(еi2), то данную предпосылку можно переписать в форме: M(еi2)= σ2. Причины невыполнимости данной предпосылки и проблемы, свяанные с этим, подробно рассматриваются в главе 8.

3 Случайные отклонения εi и εj являются независимыми друг от друга для i ≠ j. Выполнимость данной предпосылки предполагает, что отсутствует систематическая связь между любыми случайными отклонениями. Другими словами, величина и определенный знак любого случайного отклонения не должны быть причинами величины и знака любого другого отклонения. Поэтому, если данное условие выполняется, то говорят об отсутствии автокорреляции. С учетом выполнимости предпосылки 10 соотношение (5.6) может быть переписано в виде: M(εi εj) = 0 (i ≠ j). Причины невыполнимости данной предпосылки и проблемы, свя-занные с этим, подробно рассматриваются в главе 9.

4 Случайное отклонение должно быть независимо от объясняющих переменных. Обычно это условие выполняется автоматически при условии,что объясняющие переменные не являются случайными в данной модели. Данное условие предполагает выполнимость следующего соотношения:

у = cov(εi, xi) = M((εi − M(εi))(xi − M(xi))) = M(εi(xi − M(xi))) =

еixi = M(εi xi) − M(εi) M(xi) = M(εi xi) = 0.

Следует отметить, что выполнимость данной предпосылки не столь критична для эконометрических моделей.

5 Модель является линейной относительно параметров

6 Отсутствие мультиколлинеарности. Между объясняющими переменными отсутствует строгая (сильная) линейная зависимость.

7 Ошибки εi имеют нормальное распределение /Выполнимость данной предпосылки важна для проверки статистических гипотез и построения интервальных оценок.

Как и в случае парной регрессии, истинные значения параметров βj по выборке получить невозможно. В этом случае вместо теоретического уравнения регрессии (6.3) оценивается так называемое эмпирическое уравнение регрессии. Эмпирическое уравнение регрессии представим в виде:

Y = b0 + b1X1 + b2X2 +... + bmXm+ е. (2.6)

Здесь b0, b1,..., bm − оценки теоретических значений β1, β2,..., βm коэффициентов регрессии (эмпирические коэффициенты регрессии); е − оценка отклонения ε. Для индивидуальных наблюдений имеем:

yi = b0 + b1xi1 + … + bmxim + ei. (2.7)

Оцененное уравнение в первую очередь должно описывать общий тренд (направление) изменения зависимой переменной Y. При этом необходимо иметь возможность рассчитать отклонения от этого тренда. По данным выборки объема n: (xi1, xi2,…, xim, yi), i = 1, 2, …, n требуется оценить значения параметров βj вектора β, т. е. провести параметризацию выбранной модели (здесь xij, j = 1, 2, …, m − значение переменной Xj в i-м наблюдении). При выполнении предпосылок МНК относительно ошибок εi оценки b0, b1,..., bm параметров β1, β2,..., βm множественной линейной регрессии по МНК являются несмещенными, эффективными и состоятельными (т. е. BLUE-оценками). На основании (6.7) отклонение еi значения yi зависимой переменной Y от модельного значения y)i, соответствующего уравнению регрессии в i-м наблюдении (i = 1, 2, …, n), рассчитывается по формуле:

ei = yi – b0 – b1xi1 − … − bmxim. (2.8)

Тогда по МНК для нахождения оценок b0, b1,..., bm минимизируется следующая функция:

Q= ∑ei2 = ∑(yi −(b0 +∑bjxij))2. (2.9)

i=1 i=1 j=1

Данная функция является квадратичной относительно неизвестных величин bj, j = 0, 1,..., m. Она ограничена снизу, следовательно, имеет минимум. Необходимым условием минимума функции Q является равенство нулю всех ее частных производных по bj. Частные производные квадратичной функции (6.9) являются линейными функциями.

Приравнивая их к нулю, мы получаем систему (m + 1) линейного уравнения с (m + 1) неизвестным:

∂Q/ ∂b0 = −2∑n (yi −(b0 +∑m bjxij)),

∂Q/ ∂bj = −2∑(yi −(b0 +∑bjxij))xij, j=1, 2,..., m. (2.10)

Такая система имеет обычно единственное решение. В исключительных случаях, когда столбцы системы линейных уравнений линейно зависимы, она имеет бесконечно много решений или не имеет решения вовсе. Однако данные реальных статистических наблюдений к таким исключительным случаям практически никогда не приводят. Система (6.11) называется системой нормальных уравнений. Ее решение в явном виде наиболее наглядно представимо в векторноматричной форме.

2020-01-15

2020-01-15 196

196