При использовании гиперплоскостей каждый нейрон j с пороговой функцией активации, j Î EMBED {1,..., N }, N — число нейронов в сети, задает гиперплоскость значениями весов своих входов:

aj -  = 0,

= 0,

где n(j) — число входов нейрона j, aj — величина порога.

В этом случае запоминание примеров выполняется путем формирования нейронной сети и заданием весов входов. Изменение весов входов, числа нейронов, графа межнейронных связей меняет набор и положение разделяющих гиперплоскостей, разбивающих многомерное пространство на области.

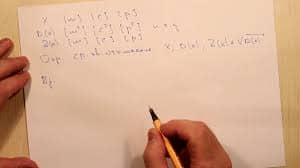

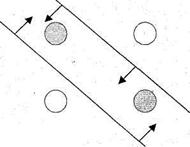

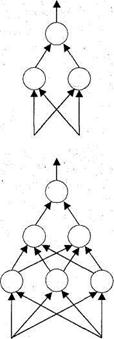

На рисунке приведено схематичное изображение возможностей сетей с двумя входами по разбиению областей двумерного пространства. Одноуровневая сеть, известная также как простой персептрон, не способна разделить на два класса точки, соответствующие нулевым и единичным значениям булевой функции "исключающее ИЛИ". Двухуровневые сети и сети с большим числом уровней способны справиться с этой задачей. Посредством нейросетей с числом уровней, превышающим два, и с n входами может быть задана произвольная булева функция от n переменных.

Двухуровневая нейронная сеть способна аппроксимировать с любой наперед заданной погрешностью EMBEDe > 0 любую непрерывную функцию f(x1, x2,..., хn), определенную на ограниченном множестве:

f(x1, x2,..., хn) =

где ni EMBED — веса входов нейрона второго слоя с линейной функцией активации; EMBED wij — вес j -го входа, j = 1,..., n, i -го нейрона, i = 1,..., N, первого слоя с сигмоидной функцией активации; N — число нейронов первого слоя.

|

| |||

| |||

|

| |||||||||

|  | ||||||||

|  | ||||||||

Рисунок. Разбиение 2-мерного пространства 2-входовыми нейросетями

Такие сети называются многоуровневыми персептронными сетями.

В случае покрытия гипершарами каждый нейрон задает значениями весов

своих входов координаты центра гипершара, а также запоминает радиус этого гиперкуба.

Эти сети называются сетями с радиусными базисными функциями.

Как видно, в обоих случаях имеет место реализация распределенного коллективного запоминания нейронами при обучении предъявленных сети примеров. Естественно, что этими двумя случаями разнообразие нейронных сетей не должно исчерпываться, т. к., например, в качестве разделяющих поверхностей могут использоваться не гиперплоскости, а гиперповерхности второго и более высоких порядков.

В ходе функционирования сеть относит предъявленный на ее входы набор значений к той или иной области, что и является искомым результатом. Заметим, что предъявляемый сети набор входных значений мог не подаваться на входы сети при обучении. Но, в силу сформированных посредством других наборов входных значений совокупности областей, этот набор попадет в одну из них. Если результат правильный, то имеет место правильно функционирующая сеть, иначе сеть обучена или сконструирована с ошибкой. Поэтому смысл процедуры обучения или конструирования — отделение множеств точек каждой области без включения посторонних точек и потери своих.

2014-02-24

2014-02-24 627

627