Элементы теории информации.

Информацией называют сведения, являющиеся объектом приема, передачи, обработки и хранения.

Сообщение – форма представления информации.

Сигнал – физическая величина, отображающая сообщение.

При разработке и анализе систем связи возникает необходимость в количественной мере оценки информации, содержащейся в сообщении и передаваемой сигналом.

Впервые такая мера была предложена американским инженером Р. Хартли в конце 20 годов, а затем эта теория была развита в известной работе американского ученого Клода Шеннона ”Математическая теория связи”1948 г.

Рассмотрим некоторые элементы этой теории.

Пусть имеется дискретный источник сообщений, который выдает последовательность сообщений, выбираемых из дискретного ансамбля (алфавита): A={ai}, i=1, 2,...,k

к- объем алфавита.

В каждом элементарном сообщении (символе, знаке) аi содержится для его получателя определенная информация, т.е. совокупность сведений о состоянии данного источника сообщений.

Очевидно, что количественная мера этой информации должна удовлетворять трем естественным требованиям:

1) количество информации в сообщении о достоверном событии должно быть равно 0.

2) количество информации должно быть аддитивной мерой, т.е. количество информации в двух независимых сообщениях должно быть равно сумме информации в каждом из них.

3) количество информации не должно зависеть от качественного содержания сообщений, в частности от его ценности и важности.

С учетом этих требований количество информации, содержащиеся в сообщении I(ai) должно быть основано на таком параметре, который в самом общем виде характеризует сообщение аi из ансамбля А.

Этим параметром может являться вероятность Р(аi) того, что источник посылает данное сообщение, следовательно количество информации I(ai) должно быть некоторой функцией этой вероятности.

Чтобы выяснить характер этой функции, вспомним второе требование: если вероятность того, что источник пошлет два независимых сообщения а1 и а2 одно за другим, равна:

, то количество информации, содержащиеся в них:

, то количество информации, содержащиеся в них:

Единственной функцией, которая обладает тем свойством, что при перемножении аргументов значения функции складываются, является логарифмическая функция.

, d - некоторая константа.

, d - некоторая константа.

Основание логарифма может быть любым, в основном берут 2.

Чтобы количество информации не было отрицательным при

;

;

[бит]

[бит]

1 бит – количество информации о событии, происходящем с вероятностью 0.5.

Эта единица очень удобна вследствие использования двоичных кодов в системах связи.

Вывод: количество информации I(ai), содержащиеся в сообщении аi тем больше, чем оно менее вероятно(более неожиданно), следовательно, чем больше множество сообщений в ансамбле, тем выше неопределенность в выборе этих сообщений и соответственно больше информации передается в одном из них.

Понятие энтропии источника сообщений.

Выведенная нами количественная мера информации I(ai) характеризует только сообщение аi и не дает общего представления о среднем количестве информации, выдаваемой источником при выборе из ансамбля одного произвольного сообщения(символа, знака).

Если источник сообщений дискретный и объем его алфавита К, то среднее количество информации, приходящиеся на 1 символ можно найти как математическое ожидание количества информации, содержащиеся в случайно выбранном с вероятностью Р(ai) символе аi. Это среднее количество информации принято называть энтропией источника сообщений.

Размерность энтропии[бит/символ].

Величину Н(В) можно считать мерой неопределенности(энтропии) дискретного распределения заданного своими безусловными вероятностями Р(ai).

Основные свойства энтропии:

1) Энтропия не отрицательна Н(А) 0.

0.

Энтропия может равняться нулю только тогда, когда одна из вероятностей Р(аi)=1, а все остальные вероятности Р(аn)=0, n  i.

i.

Здесь имеет место полная определенность выбора.

2) Энтропия независимых источников аддитивна, т.е. если рассматривать последовательностей из n-сообщений как одно укрепленное сообщение, то энтропия источника таких укрупненных сообщений в n- раз больше энтропии исходного источника.

3) Наибольшая неопределенность выбора при заданном объеме алфавита К будет тогда, когда сообщение (символы) передаются независимо и их априорные вероятности равны.

, если

, если  при любых i

при любых i

Пример:

1. Найти энтропию источника сообщений, которое выдает информацию об исходах игральной кости.

k=6,  ,

,

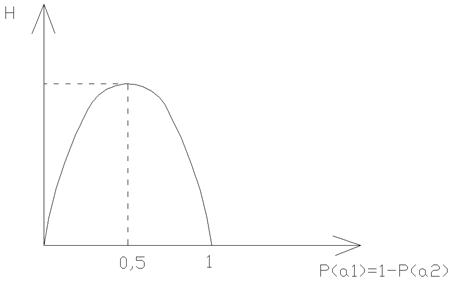

2. Двоичный источник сообщений без памяти.

k=2,  , если

, если

Если

Изобразим зависимость энтропии Н(А) от вероятности Р(аi):

2014-02-09

2014-02-09 976

976