В разделе 2.6 уже приводилось несколько примеров отчетов о выполнении тестовых примеров, однако в этом разделе основной уклон делался в сторону общей статистики выполнения тестов.

В стандарте IEEE 829 отчет о прохождении тестов разделен на три различных документа и описан в разделах 9 (Test log), 10 (Test incident report) и 11 (Test summary report). В эти разделы включены соответственно общий отчет о прохождении тестов, отчет о проблемах, выявленных в результате выполнения тестов и общую статистику прохождения тестов. В данном курсе отчет о прохождении тестов считается единым документом, разделенным на три части:

· общая (заголовочная информация);

· результаты выполнения тестовых примеров (положительные и отрицательные);

· итоговая информация о выполнении тестовых примеров (общая статистика по выполненным тестам).

Заголовочная часть отчета о прохождении тестов служит для идентификации отчета и протоколирования того, какая часть разрабатываемой системы подвергалась тестированию, какая ее версия, какая конфигурация тестового стенда использовалась для выполнения тестов.

В заголовочную часть отчета о выполнении тестов обычно включается следующая информация:

1. Название проекта или тестируемой системы

2. Общий идентификатор группы тестовых примеров, включенных в отчет

3. Идентификатор тестируемого модуля или группы модулей и номера их версий

4. Ссылку на разделы и версии тест-требований или функциональных требований, по которым написаны тесты, для которых сгенерирован отчет

5. Время начала выполнения теста и его продолжительность

6. Конфигурацию тестового стенда, на которой выполнялся тест

7. Имена и фамилии автора тестов и/или лица, выполнявшего тесты.

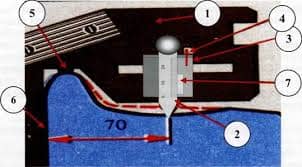

Ниже показаны два примера таких заголовочных частей отчета, создаваемых различными инструментальными средствами. Красными цифрами в скобках обозначены соответствующие пункты приведенного выше списка.

***************************************************

** Document Test Environment

** User's Computer: COMPUTER_185 (6)

** Testing Host Application: FacilityTest (6)

** Testing Host Version: 5.12 (6)

**

************* Server Related Data *************

** Server Computer: SERVER_105 (6)

** Server Version: 6.24.0 (Build 16) (6)

** Configuration: Control remote bench (6)

** Mode: Realtime (6)

** Test executed on: 7/29/06; at 10:09:40 AM (5)

** Tester Name is [ Sidorov A. ] (7)

** Software Version is: CNTRL 115 01 5 (1)

** Test Station being used is: COMPUTER_185 (6)

***************************************************

==================================================================== REMOTE CONTROL FUNCTION SOFTWARE TEST REPORT

====================================================================Project Name: Facility Remote Control (1)

Function Name: Infrared Transmitter Signal Handler (3)

Test Name: IRDA_C05A_1091K (2)

Document Name: SSRD for the Remote Control Function (4)

Paragraph Name: Button Signals (4)

Primary Paragraph Tag: [PTAG::SSRD IR BTN SIGNALS] (4)

Template Class: Test

Shall Tag(s): SSRD IR BTN SIGNALS 10 (4)

Shall(s) template: Test

------------------------------------------------------------------- MODIFICATION HISTORY:

------------------------------------------------------------------

Ver Date Author Change Description CR No.

--- --------- ---------- ------------------------ --------

01 19 Jul 06 Ivanov K. (7) Initial Development. CR_10

====================================================================

; SIMULATION RESULTS FILE

; Matrix Compiler CORE VERSION 3.00

; TEST PLAN

; ELEMENT: IRDA_IA.TMC (2)

; TITLE: Test Plan for Inrfrared source files test (1)

; TEST DATE/TIME Wed 02.11.2005 23:12:53 (5)

; SYS section: 2.3.5.6 Version: 24 (4)

; SRD section: 6.3 Version: 12 (4)

; SDD section: 12.3 Version: 33 (4)

; SOURCE FILE(S): IRDA.C Version: 18 (4)

; IRDA.H Version: 2 (4)

;

; SIMULATOR SETUP: (6)

; MODE HIGH (6)

; INC CIP.INC (6)

Следующая часть отчета о прохождении тестов должна содержать информацию о результате выполнения каждого тестового примера – завершился ли он успешно или в результате его выполнения были выявлены какие-либо несоответствия с ожидаемым результатом. В некоторых проектах эта часть отчета может быть представлена в одной из двух форм – полной или краткой. Полная форма содержит всю информацию о тестовом примере, краткая – только информацию об обнаруженных в результате выполнения тестового примера несоответствий ожидаемых и реальных выходных значений.

Обычно каждая запись о результате прохождения каждого тестового примера в полной форме содержит следующую информацию:

1. Идентификатор тестового примера

2. Краткое описание тестового примера

3. Перечисление всех входных значений тестового примера

4. Перечисление всех ожидаемых и реальных выходных значений тестового примера

5. Для каждой пары «ожидаемое-реальное выходное значение» - информацию о совпадении/несовпадении этих значений

6. Сообщение о том, пройден или не пройден тестовый пример.

В краткой форме каждая запись обычно содержит следующую информацию:

1. Идентификатор тестового примера

2. Перечисление не совпавших ожидаемых и реальных выходных значений тестового примера

3. Для каждой пары «ожидаемое-реальное выходное значение» - информацию о совпадении/несовпадении этих значений

4. Сообщение о том, пройден или не пройден тестовый пример.

Ниже приведено два примера информации о прохождении тестового примера в краткой и полной формах соответственно. Красными цифрами в скобках отмечены соответствующие пункты приведенных выше списка для краткой и полной форм соответственно.

[Testcase 163] (1):True: <EQ>:True: (4) ** Passed Number 163 **

[Testcase 164]:True: <EQ>:True: ** Passed Number 164 **

[Testcase 165]:True: <EQ>:True: ** Passed Number 165 **

[Testcase 166]:False: <EQ>:True: (4) ** Fail Number 1 **

*** Inputs for Testcase 166

DisplayTextLine2.ItemChecked = 2 (2 expected)

DisplayTextLine2.ItemChecked = 2 (2 expected)

*** Outputs for Testcase 166

DisplayTextLine2.ItemChecked = 2 (2 expected) (2)

(3) --- DisplayTextLine2.ItemChecked = 2 (1 expected)

DisplayTextLine9.ItemChecked = 2 (2 expected)

; 1) Test group 1, case a. (1)

; Test case verifies that infrared watchdog is activated by

; startup pulse sequence (2)

; Test requirements section 6.4.3.1.2

CASE DEFAULTS: (3)

T_FL_Sys_Fail_Called = 0

T_Update_Time = 1828ACh

T_CMT_Menu_Last_Update = 18639Ch

T_Level_1_Status = 180004h

T_Level_2_Status = 180304h

T_Stop_Method = 0

T_Fault_Report = 1

INPUTS: (3)

num_iterations = 1

entry_procedure = 1

T_NV_Power_On_Count = 1

T_Reset_Value = 0

T_Time_Since_Power_On = 1

OUTPUTS: EXPECTED (4) ACTUAL (4) RESULT (5)

T_NV_Power_On_Count = 1 1 PASS

T_NV_Power_On_Count_Check = 65533 65533 PASS

T_BBRAM_Power_On_Count = 1 1 PASS

T_Time_Since_Power_On = 100 100 PASS

T_FH_Queue_Msg_Count = 2 2 PASS

T_Pulse[0].Data[0] = 0 0 PASS

T_Pulse[0].Data[1] = 0 10 FAIL

Test case FAILED (6)

Завершающая часть отчета о прохождении тестов должна содержать краткую итоговую информацию о выполнении всех тестовых примеров, по которым составлялся отчет.

Обычно эта часть отчета содержит следующую информацию:

1. Общее количество выполненных тестовых примеров

2. Количество успешно пройденных тестовых примеров

3. Количество неуспешно пройденных тестовых примеров

4. Общее количество проверенных выходных значений

5. Количество выходных значений, у которых ожидаемое значение не совпало с реальным.

Ниже приведен пример этой части отчета.

TEST RESULTS:

No. of Test Cases Failed: 0 (3)

No. of Test Cases Passed: 45 (2)

Total No. of Tests Included: 46 (1)

Total No. of Outputs Checked: 2783 (4)

No. of failed Outputs Checks: 128 (5)

Часто в отчет о выполнении тестов кроме количественной статистики помещают раздел с подробным объяснением причин неуспешно пройденных тестовых примеров. Каждый пункт такого объяснения обычно содержит следующую информацию:

1. Идентификаторы тестовых примеров, благодаря неуспешному выполнению которых выявлена проблема

2. Ссылка на разделы требований, по которым написаны тестовые примеры

3. Ссылка на участки программного кода в котором выявлена проблема

4. Описание сути проблемы и (опционально) возможные пути ее решения с точки зрения тестировщика.

Данный раздел может служить основой для создания отчетов о проблемах, либо частично заменять их.

Пример такого раздела приведен ниже:

TEST CASES WITH FAILURES SUMMARY

================================

testcases | failures total | explanation in section

------------------+----------------+-----------------------

(1) 11b-l,n-p; 12b-d | 67 | 1

------------------+----------------+-----------------------

total | 67 |

1.

LOCATION:

PR_IR_DATA.C, lines 1323, 1347; (3)

Software requirements section 7.4.5.5; (2)

Test requirements section 7.4.8; (2)

PROBLEM:

Test requirements are not changed, but Software requirements are updated to reflect new system functionality. (4)

DEMONSTRATION:

Test cases: 11 b-l, n-p; 12 b-d (1)

PROPOSED SOLUTION:

Update test requirements section 7.4.8 to meet software requirements section 7.4.5.5. (4)

2015-05-15

2015-05-15 649

649