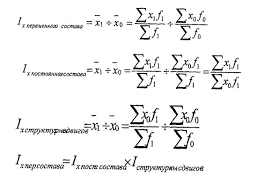

Оценка параметров регрессии a и b производится по наблюденным значениям зависимой и объясняющей переменным (x i, y i), i=1,2,…, n, где n – число пар наблюдений (объем выборки). Рассматриваются n уравнений у i= aх i +b +ei, где уклонения ei является следствием реализации случайной составляющей, и выбирают такие значения a и b, которые минимизируют сумму квадратов этих уклонений, т.е. ищется минимум

Q=åiei2= åi(у i – aх i - b)2 (2.4)

по отношению к параметрам a и b. Заметим, что указанный метод наименьших квадратов (МНК)может быть применен к любой кривой регрессии f(x). “Наилучшая” по МНК прямая линия всегда существует, но даже наилучшая не всегда является достаточно хорошей. Если в действительности зависимость у = f(x) является, например, квадратичной, то ее не сможет адекватно описать никакая линейная функция, хотя среди всех линейных функций обязательно найдется “наилучшая”.

Для отыскания минимума берутся частные производные Q по искомым параметрам (в данном случае по a0 и a1) и приравниваются к нулю. После выполнения элементарных преобразований получают так называемую систему нормальных уравнений, из которой и находятся искомые параметры. Для парной линейной регрессии получаем

a =( –

–  ×

×  )/(

)/( – (

– ( )2), (2.5)

)2), (2.5)

b =  – a ×

– a ×  =((

=(( ) ×

) ×  –

–  ×

×  )/(

)/( – (

– ( )2),

)2),

где  =å xiy i/n,

=å xiy i/n,  =å xi /n,

=å xi /n,  =å yi /n,

=å yi /n,  =å х i2/n.

=å х i2/n.

Коэффициент a называется коэффициентом регрессии и обозначается ryx. Из (2.1) и (2.5) следует, что

ryx = ryx sy /sх. (2.6)

Если выборка имеет достаточно большой объем и хорошо представляет генеральную совокупность (репрезентативна), то заключение о тесноте линейной зависимости между признаками, полученными по данным выборки, в известной степени может быть распространено и на генеральную совокупность, т.е. можно выдвинуть гипотезу об имеющейся линейной связи во всей генеральной совокупности вида у = aх+b.

2015-05-18

2015-05-18 337

337