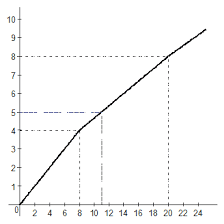

Рис. 19. Полная структура сети встречного распространения.

На рисунке 19 показана сеть встречного распространения целиком.

В режиме функционирования предъявляются входные векторы X и Y, и обученная сеть дает на выходе векторы X’ и Y’, являющиеся аппроксимациями X и Y, соответственно. Векторы X и Y предполагаются здесь нормализованными единичными векторами, следовательно, порождаемые на выходе векторы также будут иметь тенденцию быть нормализованными.

В процессе обучения векторы X и Y подаются одновременно и как входные векторы сети, и как желаемые выходные сигналы. Вектор Х используется для обучения выходов Х’, а вектор Y- для обучения выходов Y’ слоя Гроссберга. Сеть встречного распространения обучается с использованием того же самого метода, что и упрощенная структура сети. Нейроны Кохонена принимают входные сигналы как от векторов Х, так и от векторов Y. Но это неотличимо от ситуации, когда имеется один большой вектор, составленный из векторов X и Y, и не влияет на алгоритм обучения.

В качестве результирующего получается единичное отображение, при котором предъявление пары входных векторов порождает их пары на выходе. Это не представляется особенно интересным, если не заметить, что предъявление только вектора Х (с вектором Y, равным нулю) порождает как выходы Х’, так выходы и Y’. Если F- функция, отображающая Х в Y’, то сеть аппроксимирует ее. Также, если F обратима, то предъявление только вектора Y (приравнивая Х к нулю) порождает X’. Уникальная способность порождать функцию и обратную к ней делает сеть встречного распространения полезной в ряде приложений.

2015-06-05

2015-06-05 468

468