Существуют разные подходы к измерению количества информации.

Наиболее простым является объемный метод. Он основан на подсчете количества символов, из которых образовано сообщение. Главный недостаток объемного метода состоит в том, что он не учитывает разницу при анализе сообщений, выполненных с применением различных алфавитов и систем кодирования. Например, сообщения «10010100» и «Единица!» содержат одинаковое количество символов – восемь.

С технической точки зрения удобнее всего определять количество информации как меру разнообразия сигналов, передаваемых по каналам связи, сохраняемых в памяти. Это структурный подход к определению количества информации. Минимальное разнообразие и, одновременно, максимальное удобство в технической реализации обеспечивает двоичное кодирование информации.

Если какой-либо материальный объект, реагируя на внешнее воздействие способен находиться в одном из двух устойчивых состояний, которые условно обозначаются обычно как «0» и «1», то он обладает минимальной информационной ёмкостью, равной 1 бит (bit - сокращение от англ. bi nary digi t - двоичная цифра). Наименование этой единицы измерения предложено в 1946 году американцем Джоном Тьюки.

Так, например, один бит информации:

· будет получен в ответе на вопрос, если этот вопрос предполагает только два возможных ответа «да» /«нет», «истина»/ «ложь»;

· способна передать точка некоторого изображения, которая может быть либо черной, либо белой;

· содержит ячейка памяти компьютера, которая в каждый момент времени находится в одном из двух состояний: «0» или «1».

Если материальный объект имеет число вариантов устойчивых состояний больше двух, то его информационная емкость будет больше, чем 1 бит, если вариантов меньше двух, то он не способен получать и передавать информацию.

В 1928 году американский инженер Ральф Хартли предложил соответствующую расчетную формулу для определения количества информации:

где I - количество информации в сообщении;

N - количество возможных равновероятных сигналов.

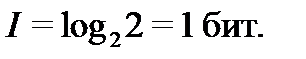

Допустим, объект переходит в одно состояние из двух равновозможных (лампа включается или выключается). Тогда, по формуле Хартли, N =2, информационная емкость (информационный объем) этого объекта составляет

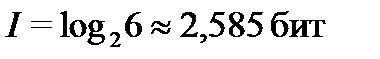

Если у объекта шесть равновероятных состояний (игральная кость), то его информационная емкость равна  и т.д.

и т.д.

Таким образом, в формуле Хартли отражается следующий важный закон:

Чем больше разнообразных сигналов способен передать объект, тем больше его информационная емкость.

Информационная ёмкость носителя информации, не может быть меньше 1-го бита, но количество получаемой информации может быть и меньше, чем 1 бит. Это утверждает вероятностный подход к измерению количества информации.

Вероятностную меру количества информации в 1948 году предложил основоположник теории информации Клод Шеннон, определив получение информации как необходимое условие для снятия неопределенности наших знаний об объекте. Неопределенность возникает в ситуации выбора. Задача, которая решается в ходе снятия неопределенности – уменьшение количества рассматриваемых вариантов сигналов (уменьшение разнообразия), и в итоге выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности дает возможность принимать обоснованные решения и действовать. В этом состоит управляющая роль информации.

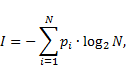

Формула Шеннонаимеет вид:

где  — вероятность того, что именно i -е сообщение выделено в наборе из N сообщений.

— вероятность того, что именно i -е сообщение выделено в наборе из N сообщений.

2015-10-14

2015-10-14 325

325