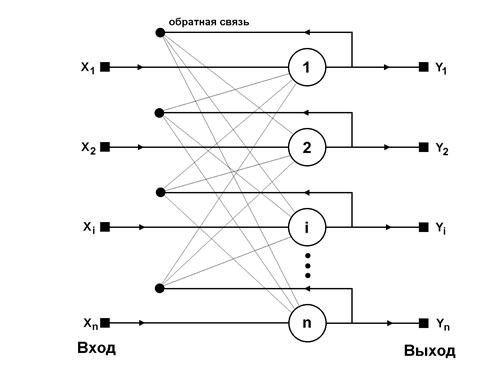

Обобщенная структура сети Хопфилда представляется, как правило, в виде системы с непосредственной обратной связью выхода с входом (рис. 6.1). Характерная особенность такой системы состоит в том, что выходные сигналы нейронов являются одновременно входными сигналами сети:

(6.3)

(6.3)

В классической системе Хопфилда отсутствует связь нейрона с собственным выходом, что соответствует  , а матрица весов является симметричной

, а матрица весов является симметричной  .

.

Процесс обучения сети формирует зоны притяжения некоторых точек равновесия, соответствующих обучающим данным. При использовании ассоциативной памяти мы имеем дело с обучающим вектором х либо с множеством этих векторов, которые в результате проводимого обучения определяют расположение конкретных точек притяжения.

Сеть Хопфилда состоит из единственного слоя нейронов, число которых является одновременно числом входов и выходов сети. Каждый нейрон связан синапсами со всеми остальными нейронами, а также имеет один входной синапс, через который осуществляется ввод сигнала. В качестве функции активации нейронов сети Хопфилда будем использовать знаковую функцию, хотя для сетей Хопфилда также можно использовать пороговую функцию, линейную функцию с насыщением или сигмоидальные функции активации.

|

Рис. 6.1 Обобщенная структура сети Хопфилда

Это означает, что выходной сигнал  нейрона определяется функцией:

нейрона определяется функцией:

, (6.4)

, (6.4)

где  обозначает число нейронов.

обозначает число нейронов.

Будем считать, что пороговые элементы являются компонентами вектора  . Без учета единичных задержек сети, представляющих собой способ синхронизации процесса передачи сигналов, основные зависимости, определяющие сеть Хопфилда, можно представить в виде:

. Без учета единичных задержек сети, представляющих собой способ синхронизации процесса передачи сигналов, основные зависимости, определяющие сеть Хопфилда, можно представить в виде:

, (6.5)

, (6.5)

с начальным условием  . В процессе функционирования сети Хопфилда можно выделить два режима: обучения и классификации. В режиме обучения на основе известных обучающих выборок

. В процессе функционирования сети Хопфилда можно выделить два режима: обучения и классификации. В режиме обучения на основе известных обучающих выборок  подбираются весовые коэффициенты

подбираются весовые коэффициенты  . В режиме классификации при зафиксированных значениях весов и вводе конкретного начального состояния нейронов

. В режиме классификации при зафиксированных значениях весов и вводе конкретного начального состояния нейронов  возникает переходной процесс, протекающий в соответствии с выражением (6.5) и завершающийся в одном из локальных минимумов, для которого

возникает переходной процесс, протекающий в соответствии с выражением (6.5) и завершающийся в одном из локальных минимумов, для которого  .

.

При вводе только одной обучающей выборки  процесс изменений продолжается до тех пор, пока зависимость (6.5) не начнет соблюдаться для всех

процесс изменений продолжается до тех пор, пока зависимость (6.5) не начнет соблюдаться для всех  нейронов. Это условие автоматически выполняется в случае выбора значений весов, соответствующих отношению

нейронов. Это условие автоматически выполняется в случае выбора значений весов, соответствующих отношению

, (6.6)

, (6.6)

поскольку только тогда  (вследствие биполярных значений элементов вектора

(вследствие биполярных значений элементов вектора  всегда выполняется соотношение

всегда выполняется соотношение  ). Следует отметить, что зависимость (6.6) представляет собой правило обучения Хебба. При вводе большого числа обучающих выборок

). Следует отметить, что зависимость (6.6) представляет собой правило обучения Хебба. При вводе большого числа обучающих выборок  для

для  веса

веса  подбираются согласно обобщенному правилу Хебба, в соответствии с которым

подбираются согласно обобщенному правилу Хебба, в соответствии с которым

. (6.7)

. (6.7)

Благодаря такому режиму обучения веса принимают значения, определяемые усреднением множества обучающих выборок.

В случае множества обучающих выборок становится актуальным фактор стабильности ассоциативной памяти. Для стабильного функционирования сети необходимо, чтобы реакция  -го нейрона

-го нейрона  на

на  -ю обучающую выборку

-ю обучающую выборку  совпадала с ее

совпадала с ее  -й составляющей

-й составляющей  . Это означает, что с учетом выражения (6.7) получим

. Это означает, что с учетом выражения (6.7) получим

. (6.8)

. (6.8)

Если взвешенную сумму входных сигналов  -го нейрона обозначить

-го нейрона обозначить  , то можно выделить в ней ожидаемое значение

, то можно выделить в ней ожидаемое значение  и остаток, называемый диафонией [4]:

и остаток, называемый диафонией [4]:

. (6.9)

. (6.9)

Вследствие применения знаковой функции активации, выполнение условия (6.8) возможно при малых значениях диафонии, не способных изменить знак  . Это означает, что, несмотря на определенное несовпадение битов, переходный процесс завершается в нужной точке притяжения. При предоставлении тестовой выборки, отличающейся некоторым количеством битов, нейронная сеть может откорректировать эти биты и завершить процесс классификации в нужной точке притяжения.

. Это означает, что, несмотря на определенное несовпадение битов, переходный процесс завершается в нужной точке притяжения. При предоставлении тестовой выборки, отличающейся некоторым количеством битов, нейронная сеть может откорректировать эти биты и завершить процесс классификации в нужной точке притяжения.

Тем не менее, правило Хебба обладает невысокой продуктивностью. Максимальная емкость ассоциативной памяти (число запомненных образцов) при обучении по правилу Хебба с допустимой погрешностью 1%, составляет примерно 14% от числа нейронов сети [4]. Кроме того, при наличии шума, применение правила Хебба приводит к различным неточностям в виде локальных минимумов, далеких от исходного решения. Поэтому в качестве альтернативы используют методы обучения, основанные на псевдоинверсии.

Идея этого метода состоит в том, что при правильно подобранных весах, каждая поданная на вход выборка  генерирует на выходе саму себя, мгновенно приводя к исходному состоянию (зависимость (6.5)) [4]. В матричной форме это можно представить в виде:

генерирует на выходе саму себя, мгновенно приводя к исходному состоянию (зависимость (6.5)) [4]. В матричной форме это можно представить в виде:

, (6.10)

, (6.10)

где  - матрица весов сети размерностью

- матрица весов сети размерностью  , а

, а  - прямоугольная матрица размерностью

- прямоугольная матрица размерностью  , составленная из

, составленная из  последовательных обучающих векторов

последовательных обучающих векторов  , то есть

, то есть  . Решение такой линейной системы уравнений имеет вид:

. Решение такой линейной системы уравнений имеет вид:

, (6.11)

, (6.11)

где знак + обозначает псевдоинверсию. Если обучающие векторы линейно независимы, последнее выражение можно представить в форме:

. (6.12)

. (6.12)

Псевдоинверсия матрицы размерностью  в этом выражении заменена обычной инверсией квадратной матрицы

в этом выражении заменена обычной инверсией квадратной матрицы  размерностью

размерностью  . Дополнительное достоинство выражения (6.12) – возможность записать его в итерационной форме, не требующей расчета обратной матрицы. В этом случае выражение (6.12) принимает вид функциональной зависимости от последовательности обучающих векторов

. Дополнительное достоинство выражения (6.12) – возможность записать его в итерационной форме, не требующей расчета обратной матрицы. В этом случае выражение (6.12) принимает вид функциональной зависимости от последовательности обучающих векторов  для

для  :

:

(6.13)

при начальных условиях  . Такая форма предполагает однократное предъявление всех обучающих выборок, в результате чего матрица весов принимает значение

. Такая форма предполагает однократное предъявление всех обучающих выборок, в результате чего матрица весов принимает значение  . Зависимости (6.12) и (6.13) называются методом проекций. Применение метода псевдоинверсии увеличивает максимальную емкость сети Хопфилда, которая становится равной

. Зависимости (6.12) и (6.13) называются методом проекций. Применение метода псевдоинверсии увеличивает максимальную емкость сети Хопфилда, которая становится равной  .

.

Модифицированный вариант метода проекций – метод  проекций – это градиентная форма алгоритма минимизации целевой функции. В соответствии с этим способом веса подбираются рекуррентно с помощью циклической процедуры, повторяемой для всех обучающих выборок:

проекций – это градиентная форма алгоритма минимизации целевой функции. В соответствии с этим способом веса подбираются рекуррентно с помощью циклической процедуры, повторяемой для всех обучающих выборок:

. (6.14)

. (6.14)

Коэффициент  - это коэффициент обучения, выбираемый обычно из интервала [0.7 – 0.9]. Процесс обучения завершается, когда изменение вектора весов становится меньше априорно принятого значения

- это коэффициент обучения, выбираемый обычно из интервала [0.7 – 0.9]. Процесс обучения завершается, когда изменение вектора весов становится меньше априорно принятого значения  .

.

По завершении подбора весов сети их значения «замораживаются», и сеть можно использовать в режиме распознавания. В этой фазе на вход сети подается тестовый вектор  и рассчитывается ее отклик в виде:

и рассчитывается ее отклик в виде:

(6.15)

(6.15)

(в начальный момент  ), причем итерационный процесс повторяется для последовательных значений

), причем итерационный процесс повторяется для последовательных значений  вплоть до стабилизации отклика.

вплоть до стабилизации отклика.

В процессе распознавания образа по зашумленным сигналам, образующим начальное состояние нейронов, возникают проблемы с определением конечного состояния, соответствующего одному из запомненных образов. Возможны ошибочные решения. Одной из причин нахождения ошибочных решений является возможность перемешивания различных компонентов запомненных образов и формирования стабильного состояния, воспринимаемого как локальный минимум.

2014-02-02

2014-02-02 3046

3046