Но, поскольку формула Хартли не учитывала вероятностей различных исходов опыта, в 1948 г. другой американский инженер Клод Шеннон предложил ее усовершенствовать, приняв в качестве меры неопределенности опыта a - с возможными исходами  величину:

величину:

где p ( ) - вероятности отдельных исходов.

) - вероятности отдельных исходов.

|

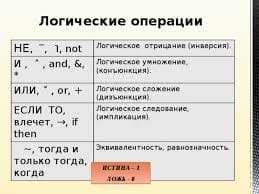

Знаменитый американский математик и электроинженер, один из создателей теории информации. Закончив в 1936 г. Мичиганский университет, Шеннон увлекся идеей применения формальной логики к анализу работы релейных систем связи (телефона, телеграфа), что и определило его последующую судьбу. Оставаясь на протяжении всей жизни неутомимым изобретателем эдисоновского типа, Шеннон попытался распространить применение формальной логики в области генетики, защитив в 1940 диссертацию на тему «Алгебра теоретической генетики», а также криптографии и создания шахматных программ.

После защиты диссертации Клод Шеннон более тридцати лет работал в математической лаборатории крупнейшей американской компании по производству аппаратуры и услуг связи - AT&T Bell Telephones. В этот период он создает основы теории информации и теории автоматического управления. В это же время он публикует свой самый знаменитый труд «Математическая теория связи» (1948). В нем Шеннон дает новую интерпретацию энтропии, как меры неопределенности сообщения, и вводит фундаментальные для современной науки понятия: информации, как количества снятой неопределенности благодаря сделанному сообщению; и пропускной способности канала связи. С 1957 г., продолжая службу в AT&T, Шеннон работал профессором математики Массачусетского технологического института.

Использование величины H(a) в качестве меры неопределенности опыта a оказалось очень удобным как для математических, так и для многих практических целей. Хотя, еще в начале 1950-х годов, ряд исследователей указывал на то, что формула Шеннона не может претендовать на полный учет всех факторов, определяющих “неопределенность опыта” в любом смысле, какой может встретиться в жизни, т.к. зависит лишь от вероятностей  различных исходов опыта и вовсе не зависит от того, каковы сами эти исходы.

различных исходов опыта и вовсе не зависит от того, каковы сами эти исходы.

Поэтому, например, формула Шеннона даст один и тот же результат для двух методов лечения больного, один из которых приводит к полному выздоровлению в 90 случаях из 100 и к заметному улучшению состояния больного в остальных случаях, а второй так же вполне успешен в 90 случаях из 100, но зато в остальных 10 случаях завершается смертельным исходом. Существенное различие между двумя опытами в этих случаях должно оцениваться совсем другими характеристиками, отличными от энтропии Шеннона.

Отмеченная особенность энтропии H(a) объясняется тем, что первоначально она была предложена для решения вопросов теории передачи сообщений по линиям связи, т.е., в тех условиях, при которых конкретное содержание самого сообщения совершенно несущественно.

Наряду с понятием энтропии H(a), Шеннон вводит еще и разностную меру J(a) для зависимых опытов a и a 1, указывающую, насколько осуществление опыта a 1 уменьшает неопределенность опыта a:

где  – энтропия опыта

– энтропия опыта  , позволяющая уменьшить неопределенность опыта a.

, позволяющая уменьшить неопределенность опыта a.

J (a) – информация об опыте a, содержащаяся в опыте  .

.

|

2015-05-12

2015-05-12 456

456