Энтропия – это мера хаотичности информации, неопределённость появления какого-либо символа первичного алфавита.

Энтропия – это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

Дискретный источник сообщений – это источник сообщений, принимающий случайным образом одно из конечного множества возможных состояний U в каждый момент времени. Совокупность состояний  источника называют его алфавитом, а количество состояний N ‑ объемом алфавита.

источника называют его алфавитом, а количество состояний N ‑ объемом алфавита.

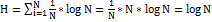

Мера неопределенности источника с равновероятными состояниями и характеризующего его ансамбля U – это логарифм объема алфавита источника:

(1.1)

(1.1)

Впервые данная мера была предложена Хартли в 1928г. Основание логарифма в формуле не имеет принципиального значения и определяет только масштаб или единицу количества информации.

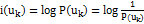

В общем случае, если вероятности различных состояний источника не одинаковы, степень неопределенности конкретного состояния зависит не только от объема алфавита источника, но и от вероятности этого состояния, тогда

(1.2)

(1.2)

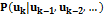

Количество информации в сообщении тем больше, чем оно более неожиданно. Если источник выдает последовательность зависимых между собой элементарных сообщений, то наличие предшествующих сообщений может изменить вероятность последующего, а, значит, и количество информации в нем. Оно должно определяться по условной вероятности  выдачи сообщения

выдачи сообщения  при известных предшествующих сообщениях

при известных предшествующих сообщениях  ,тогда количество информации будет определятся формулой:

,тогда количество информации будет определятся формулой:

(1.3)

(1.3)

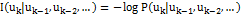

Определения (1.2) и (1.3) количества информации являются случайной величиной, поскольку сами сообщения являются случайными.

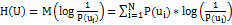

(1.4 а) – формула Шеннона.

(1.4 а) – формула Шеннона.

В тоже время энтропия по Шеннону это среднее количество информации содержащееся в одном из не равновероятных состояний. Она позволяет учесть статистические свойства источника информации.

Формула Хартли – частный случай формулы Шеннона для равновероятных альтернативных событий. Подставив в формулу (1.4 a) вместо  , которое в равновероятном случае не зависит от i, значение

, которое в равновероятном случае не зависит от i, значение  , получим:

, получим:

(1.4 b) – формула Хартли.

(1.4 b) – формула Хартли.

Из (1.4 b) следует, что чем больше количество альтернатив N, тем больше неопределенность H. Эти величины связаны в формуле (1.4 b) не линейно, а через двоичный логарифм. Логарифмирование по основанию 2 и приводит количество вариантов к единицам измерения информации – битам. Энтропия будет являться целым числом лишь в том случае, если N является степенью числа 2.

Свойства энтропии:

1) Энтропия любого дискретного ансамбля не отрицательна  (1.5).

(1.5).

2) Пусть N - объем алфавита дискретного источника, тогда  (1.6). Равенство имеет место, когда все сообщения источника равновероятные.

(1.6). Равенство имеет место, когда все сообщения источника равновероятные.

3) Энтропия объединения нескольких независимых статистических источников сообщений равна сумме энтропии исходных источников ‑ свойство аддитивности энтропии.

2015-05-13

2015-05-13 3889

3889