Теорема. Если вероятность p наступления события А в каждом испытании постоянна, то вероятность Pm,n того, что событие А наступит m раз в n независимых испытаниях, равна  , где q=1-p.

, где q=1-p.

Пусть Аi и Āi – соответственно появление и непоявление события А в i-м испытании (I = 1, 2, …, n), а Bm – событие, состоящее в том, что в n независимых испытания событие а появилось m раз.

Представим событие Bm через элементарные события Аi.

В общем виде Bm = A1A2…AmĀm+1…Ān + A1Ā2A3…Ān-1An + … + Ā1Ā2…Ān-mAn-m+1…An, т.е. каждый вариант появления события Вm (каждый член суммы) состоит из ь появлений события А и n-m непоявлений.

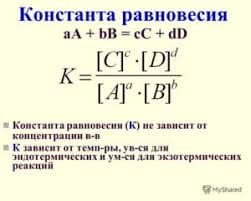

Число всех комбинаций равно числу способов выбора из n испытаний m, в которых событие А произошло, т.е. числу сочетаний Сnm. Вероятность каждой такой комбинации (каждого варианта появления события Bm) по теории умножения независимых событий равна pmqn-m, так как p(Ai)=p, p(Āi)=q, I =1, 2,.., n. В связи с тем, что комбинации между собой несовместны, то теореме сложения вероятностей получим  .

.

Число m0 наступления события А в n независимых испытаниях называется наивероятнейшим, если вероятность осуществления этого события Pm0,n по крайней мере не меньше вероятностей других событий Pm,n при любом m.

np – q ≤ m0 ≤ np + p.

(Сочетание Cnm = n!/(m!(n-m)!))

Полиномиальная схема.

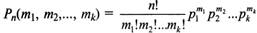

В полиномиальной (мультиноминальной) схеме осуществляется переход от последовательности независимых испытаний с двумя исходами (А и Ā) к последовательности независимых испытаний с k исключающими друг друга исходами А1, А2, …, Аk. При этом в каждом испытании события А1, А2, …, Аk наступают соответственно с вероятностями p1, p2, …, pk. Тогда вероятность Pn (m1, m2, …, mk) того, что в n независимых испытаниях событие А1 произойдет m1 раз, А2 – m2 раз и т.д., событие Ak – mk раз (m1 + m2 + … + mk = n) определится по формуле:

В полиномиальной (мультиноминальной) схеме осуществляется переход от последовательности независимых испытаний с двумя исходами (А и Ā) к последовательности независимых испытаний с k исключающими друг друга исходами А1, А2, …, Аk. При этом в каждом испытании события А1, А2, …, Аk наступают соответственно с вероятностями p1, p2, …, pk. Тогда вероятность Pn (m1, m2, …, mk) того, что в n независимых испытаниях событие А1 произойдет m1 раз, А2 – m2 раз и т.д., событие Ak – mk раз (m1 + m2 + … + mk = n) определится по формуле:

В частном случае двух исходов при m1=m, m2=n-m, p1=p, p2=q, где q=1-p, формула представляет формулу Бернулли.

Раздел4_1. Информация, данные, сигналы. Источники информации и ее носители. Количество информации и энтропия. Формулы Хартли и Шеннона. Характеристики процесса передачи информации. Математические модели каналов связи и их классификация. Помехоустойчивость передачи информации. Пропускная способность каналов связи, характеристики каналов, классификация каналов. Теорема Шеннона для каналов без помех и с ними.

Информация (в теории информации) - совокупность сведений об объектах и явлениях материального мира, рассматриваемых в аспекте их передачи в пространстве и времени.

Данные - это совокупность сведений, которые зафиксированы на каком-либо носителе - бумаге, диске, пленке. Эти сведения должны быть в форме, пригодной для хранения, передачи и обработки. Дальнейшее преобразование данных позволяет получить информацию.

Информация передается в виде сообщений с помощью сигналов.

Сообщение - информация, выраженная в определенной форме и предназначенная для передачи от источника информации к ее получателю с помощью сигналов различной физической природы.

Сигнал - материальный носитель информации, представляющий любой физический процесс, параметры которого адекватно отображают сообщение. По своей физической природе сигналы могут быть электрические, акустические, оптические, электромагнитные и т.д. Изменяющийся во времени физический процесс, отражающий передаваемое сообщение называется сигналом. Сигнал всегда является функцией времени.

В зависимости от того, какие значения могут принимать аргумент (время t) и уровни сигналов их делят на 4 типа:

1) Непрерывный или аналоговый сигналы (случайные сигналы этого типа называются непрерывными случайными процессами).

2) Дискретизированный или дискретно непрерывные сигналы (случайные сигналы этого типа называют процессами с дискретным временем или непрерывными случайными последовательностями). Они определены лишь в отдельные моменты времени и могут принимать любые значения уровня. Временной интервал Dt между соседними отсчетами называется шагом дискретизации. Часто такие сигналы называют дискретными по времени.

3) Дискретные по уровню или квантованные сигналы (случайные сигналы этого типа называют дискретными случайными процессами). Они определены для всех моментов времени и принимают лишь разрешенные значения уровней отделенные друг от друга на величину шага квантования  .

.

4) Дискретные по уровню и по времени сигналы (случайные сигналы этого типа называют дискретными случайными последовательностями). Они определены лишь в отдельные разрешенные моменты времени и могут принимать лишь разрешенные значения уровней.

Источник информации - материальный объект или субъект, способный накапливать, хранить, преобразовывать и выдавать информацию в виде сообщений или сигналов различной физической природы. Выделяют следующие основные источники информации: люди, документы, продукция, средства обработки информации, черновики и отходы производства, материалы и технологическое оборудование.

Носитель информации (информационный носитель) — любой материальный объект или среда, используемый для хранения или передачи информации. Выделяют 4 вида носителей информации: люди, материальные тела (макрочастицы), поля (акустические, магнитные и т. д.), элементарные частицы (микрочастицы).

2015-05-13

2015-05-13 888

888