3.1. Понятие энтропии

Важную роль в системном анализе играет понятие энтропии, тесно связанное с информацией.

Понятие «энтропия» ввел в 1865 г. немецкий физик Р. Клаузиус как понятие физическое: энтропия в термодинамике - функция состояния термодинамической системы, характеризующая направленность тепловых процессов. Согласно принятому в термодинамике определению, изменение энтропии некоторой системы равно отношению приращения (или уменьшения) количества теплоты к абсолютной, температуре, при которой это приращение (или уменьшение) происходит.

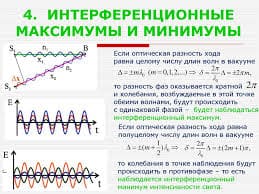

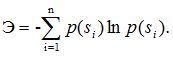

В системном анализе энтропия Э служит количественной мерой беспорядка (свободы, разнообразия) в системе и определяется числом допустимых состояний системы Ns:

Приведенная формула справедлива только для равновероятных состояний. Если же система может находиться в n состояниях —s1, s2,.... sn — с вероятностями соответственно p(s1),p (s2),....,p(sn), то ее энтропия рассчитывается по формуле

Так как логарифм является безразмерной величиной, то и энтропия также безразмерная ве-личина. С другой стороны, энтропия, как и информация, может измеряться в битах, если в формулах вместо натурального использовать двоичный логарифм.

Примеры:

1. Система с жесткой структурой (например, армейская) может находиться только в одном состоянии (в армии есть поговорка: «Из нас прав кто-нибудь один: или я, или никто»). Эн-тропия такой системы равна нулю (Э= In 1 = 0).

2. Бюрократией называют систему, в которой почти не осталось разнообразия, поэтому энтропия такой системы предельно мала.

|

|

|

3.2. Открытые и закрытые системы. Второе начало термодинамики

Как говорилось ранее, между системой и окружающей средой происходит обмен веществом, энергией и информацией. Причиной обмена является неравновесное состояние системы по отношению к окружающей среде - разность их свойств. Если свойства системы и окружающей среды идентичны, то система находится в равновесии - все обменные процессы прекращаются. Однако, несмотря на неравновесность, обменные процессы могут отсутствовать при естественном или искусственном их ограничении. В связи с этим рассматриваются понятия открытой и закрытой систем.

Открытая система - это система, способная обмениваться окружающей средой массой, энер-гией и информацией.

Закрытая, или замкнутая, система лишена этой возможности, т. е. полностью изолирована от среды.

При этом возможны и частные случаи: например, в модели системы не учитываются гравитационные и энергетические процессы, а отражается только обмен информацией со средой; тогда говорят об информационно-проницаемых или соответственно информационно-непроницаемых системах.

Строго говоря, такая полная изоляция любой системы весьма условна в силу всеобщей взаимосвязи и взаимозависимости явлений и процессов в природе и обществе. Можно лишь условно считать, что доля взаимосвязей системы со средой пренебрежимо мала по сравнению с внутренними взаимосвязями системы.

Поэтому понятие закрытой системы следует рассматривать как своего рода модель. При отображении проблемной ситуации такой моделью условно принимается, что либо «входы» и «выходы» у системы отсутствуют, либо их состояния неизменны в рассматриваемый период времени.

Поведение закрытой системы определяется начальными условиями, характеристиками ее элементов и связей, структурой, внутренними закономерностями функционирования системы. Предметом исследования являются внутренние изменения, определяющие поведение системы. Внешние же управляющие или возмущающие воздействия рассматриваются как помехи.

В частности, одним из принципиальных отличий закрытых систем от открытых является тот факт, что они оперирует обычно понятием цель как внешним по отношению к системе, а в открытых цели не задаются извне, а формируются внутри системы.

Для замкнутых систем справедливо второе начало (закон) термодинамики, согласно которому энтропия замкнутой (изолированной) системы монотонно возрастает (не убывает) со временем (ΔЭ >= 0), вплоть до достижения максимального значения (Эмакс) в конечном равновесном состоянии, когда число допустимых состояний системы максимально.

Возрастание энтропии в термодинамических системах говорит о переходе упорядоченной формы движения частиц в неупорядоченную, иначе тепловую. Превращение энергии упорядочен-ного движения в энергию хаотического движения называют диссипацией энергии (термин «диссипативный» является синонимом термина «необратимый»). Температура всех частей системы в состоянии равновесия одинакова. Термодинамическому равновесию системы соответствует состояние с максимумом энтропии. Энтропия же всех веществ при абсолютном нуле равна нулю.

Любая изолированная система стремится достичь ситуации, отвечающей наибольшему беспорядку, т. е. ситуации с максимальным значением энтропии. Однако в системе возможны флуктуации.

Флуктуации - это случайные процессы, при которых система переходит из более вероятного состояния в менее вероятное.

При флуктуации энтропия системы уменьшается, т. е. закон возрастания энтропии выполняется только в среднем для достаточно большого промежутка времени.

В незамкнутых системах энтропия может как увеличиваться (например, при подводе тепла в термодинамическую систему извне), так и уменьшаться (например, при теплоотдаче в окружающую среду) Таким образом, в отличие от закрытых в открытых системах возможно снижение энтропии. Подобные системы могут сохранять свой высокий уровень организованности и даже развиваться в сторону увеличения порядка сложности. Для повышения организованности (снижения энтропии) системы применяют управление. Именно поэтому так важен хороший обмен информацией со средой для эффективного решения задач управления, т. е. в качестве противоположности энтропии выступает обратная ей по знаку величина – информация, действие которой выражается в тенденции к увеличению упорядоченности и уменьшению неопределенности. Нужно понимать, что информация не уничтожает энтропию, но способна компенсировать ее возрастание. Так, подставленная ладонь, препятствуя падению предмета, не уменьшает действие гравитационных сил (не отменяет закон всемирного тяготения), а только компенсирует его воздействие.

|

|

|

3.3. Принцип компенсации энтропии

Представление о том, какую «плату» приходится платить за уменьшение энтропии системы, дает принцип компенсации энтропии.

Принцип компенсации энтропии гласит, что энтропия неизолированной системы может быть уменьшена только за счет компенсирующего увеличения энтропии в другой или других системах взаимодействующих с данной.

На основе вышеизложенного, можно утверждать, что прогресс не может быть общим для всех частей системы. По законам термодинамики снижение энтропии в одной части системы обязательно сопровождается повышением энтропии в другой части или окружающей среде. Поэтому невозможен всемирный прогресс и благоденствие, если мы не научимся отводить от планеты лишнюю энтропию (отходы) во внешнюю среду. Успехи развития одной группы людей (даже внутри одной семьи) или одного слоя общества, или одного государства и, следовательно, снижение их энтропии возможно только при одновременном повышении энтропии в других группах людей, в других слоях общества, в других государствах или окружающей среде соответственно. Очевидно, что безэнтропийных процессов не бывает ни в природе, ни в обществе, аналогично тому, как не бывает безотходных технологий.

|

|

|

3.4. Закон «необходимого разнообразия» Эшби

Для уменьшения разнообразия (беспорядка) необходимо привнести в систему информацию (управляющее воздействие) - негэнтропию, которую ошибочно представляют как энтропию с отрицательным знаком. Негэнтропия действительно измеряется в тех же единицах, как и энтропия (например, в битах), направление ее действительно противоположно энтропии, и увеличение негэнтропии вызывает такое же уменьшение энтропии. Несмотря на это, негэнтропия и энтропия изменяются в системе но разным самостоятельным закономерностям, и их абсолютные значения мало зависят друг от друга. При увеличении энтропии увеличивается размерность систем и количество независимых факторов - переменных. Одновременно с ростом энтропии увеличивается и неопределенность, неупорядоченность, беспорядок системы. Чтобы их уменьшить, необходимо ввести в систему негэнтропию, или информацию. При прогрессивном развитии системы, при ее организации и упорядочении больше увеличивается негэнтропия, чем энтропия. При деструкции, дезорганизации системы, наоборот, больше увеличивается энтропия, чем негэнтропия.

Какие имеются возможности по уменьшению энтропии объекта субъектом? У.Р. Эшби сформулировал закономерность, известную под названием «закон необходимого разнообразия».

Когда лицо N, принимающее решение, сталкивается с проблемой D, решение которой для него неочевидно, то имеет место некоторое разнообразие возможных решений, оцениваемое энтропией ЭD. Этому разнообразию противостоит «разнообразие» исследователя ЭN - разнообразие известных ему методов и приемов решения проблемы и способность сгенерировать новые. Задача исследователя заключается в том, чтобы свести разность разнообразий ΔЭ = ЭD - ЭN к минимуму, в идеале - к нулю.

Эшби доказал теорему, на основе которой формулируется следующий вывод: ΔЭ может быть уменьшена лишь за счет соответствующего роста ЭN. Говоря более образно, только разнообразие в N может уменьшить разнообразие, создаваемое в D, только разнообразие может уничтожить разнообразие.

Итак, для успешного решения задачи управления управляющая система (техническая или организационная) должна иметь большее (или, по крайней мере, равное) разнообразие (свободу выбора), чем объект управления:

|

|

|

2015-08-13

2015-08-13 2389

2389