Следующим этапом в изучении вариации признака в совокупности является установление типичности или показательности средней. Типичность должна показать, насколько однородна масса, которая характеризуется этой средней.

Амплитуда (размах) вариации – абсолютная разность между максимальным и минимальным значением признака:

R=Xmax-Xmin

Но он не указывает, насколько велики отклонения от вариантов признака внутри совокупности. Более точными считаются отклонения каждого из вариантов от его среднего значения. Так как, отклонений столько же, сколько и вариантов, то определяется их средняя величина: среднее линейное отклонение, среднее квадратичное отклонение и дисперсия.

Среднее линейное отклонение вычисляется по абсолютной величине как взвешенное по частоте отклонение середин интервалов от средней арифметической величины:

S (х-хs)

Ds = ------------

n

Среднее квадратичное отклонение служит мерой колеблемости вариантов, из которых выводится средняя.

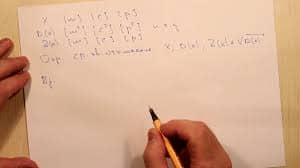

d=Ö[S (х-хs)2] /n

Для вычисления среднего квадратичного отклонения необходимо отклонения каждого варианта ряда от средней возвести в квадрат, сумму квадратов разделить на число членов ряда и из полученного результата извлечь корень.

Квадрат среднего квадратичного отклонения дает величину дисперсии, на которой основаны практически все методы математической статистики.

d2=[S (х-хs)2] /n

Коэффициент вариации является критерием типичности средней (если более 40%, то типичность – невысока):

d

V = ------ 100%

хs

Среднее квадратичное отклонение и связанные с ним расчеты, основаны на теории вероятностей.

Множество вариаций и случайных отклонений сглаживаются именно в массе, что приводит к образованию статистических закономерностей. Проявление закономерности есть результат действия закона больших чисел и находит свое выражение в средней величине, в характере распределения.

Закон больших чисел основывается на понятии случайности и вероятности – уменьшение степени случайности и возрастание степени вероятности наличия определенного признака происходит по мере увеличения статистической совокупности. Поэтому математическим обоснованием закона является теория вероятностей. Вероятность (в математике) является оценкой степени объективной возможности того или иного результата при отборе на удачу одной единицы из всей совокупности. Статистическое понятие вероятности определяется как постоянное число, вокруг которого колеблются частоты.

3. Понятие корреляции.

В процессе статистического исследования объективно существующих связей вскрываются причинно-следственные отношения между явлениями, что позволяет выявлять факторные признаки, оказывающие основное влияние на вариацию изучаемых явлений и процессов (результативные признаки).

Различают два вида связей между различными явлениями и их признаками:

- функциональную (жестко детерминированную)

- статистическую (стохастически детерминированную).

Функциональные связи характеризуются полным соответствием между изменением факторного признака и изменением результативной величины. При этом, каждому значению признака фактора соответствуют вполне определенные значения результативного признака (например, площадь круга).

В социально-правовых явлениях функциональные связи отсутствуют, т.к. в общественных процессах действует множество факторов. Статистические связи не имеют ограничений и условий, их нельзя описать строго математически.

Наиболее простой, широко применяемый метод выявления связи между признаками явлений при проведении статистического анализа – это метод параллельных рядов, который заключается в сопоставлении двух или нескольких рядов, находящихся во взаимной связи друг с другом, в результате чего выявляется зависимость между ними.

Важнейший случай статистической связи – корреляционная связь.

Корреляционная зависимость – взаимосвязь между признаками, состоящая в том, что средняя величина значений одного признака меняется в зависимости от изменения другого признака. Такая связь определяется на основе специальных уравнений, выражающих типичное соотношение между изучаемыми признаками.

Корреляционная связь между признаками может возникать разными путями: причинная зависимость, взаимосвязь признаков, каждый из которых и причина и следствие, и связь между двумя следствиями общей причины. Например, между признаком х – число пожарных в городе и признаком у – сумма убытков от пожаров, существует прямая корреляция: чем больше пожарных в городе, тем больше и убытков от пожаров (как у стекольщиков). Оба этих признака являются следствием одной причины – размера города.

Корреляционные уравнения, в зависимости от формы связи, определяемой на основе предварительного качественного анализа, могут быть прямыми (равным изменениям средних значений одного признака соответствуют приблизительно равные изменения средних значений другого признака) и обратными (наоборот).

Для определения количественной характеристики применяется коэффициент корреляции:

R= Sdxdy/ÖSdx2dy2 где dx - отклонение от средней чисел первого ряда;

dу - отклонение от средней чисел второго ряда;

Коэффициент корреляции, характеризующий меру связи, тем больше, чем более жесткая зависимость. По степени тесноты связи различают следующие количественные критерии оценки тесноты связи (+ - прямая; - - обратная):

| Коэффициент корреляции | Характер связи |

| Отсутствует | |

| До 0.3 | Очень слабая |

| 0.3 – 0.5 | Слабая |

| 0.5 – 0.7 | Умеренная |

| Свыше 0.7 | Сильная |

| 1.0 | Полная |

Задание:

1. Определите коэффициент вариации:

| Уровень (х) | Отклонения от средней (х-хs) | Квадрат отклонений (х-хs)2 | Уровень (х) | Отклонения от средней (х-хs) | Квадрат отклонений (х-хs)2 | |

| Январь | ||||||

| Февраль | ||||||

| Март | ||||||

| Апрель | ||||||

| Май | ||||||

| Июнь | ||||||

| Июль | ||||||

| Август | ||||||

| Сентябрь | ||||||

| Октябрь | ||||||

| Ноябрь | ||||||

| Декабрь | ||||||

| Средняя | 1614.4 | 1613.6 |

2. Определите коэффициент корреляции:

2015-06-28

2015-06-28 395

395