БИЛЕТ

Как соотносятся традиционная, троичная и нечеткая логики?

Традиционая логика это «логика, развиваемая с помощью математических методов». Базовыми элементами, которыми оперирует алгебра логики, являются высказывания.

Трои́чная ло́гика (трёхзначная логика) один из видов многозначной логики, предложенный ЯномЛукасевичем в 1920 году. Трёхзначная логика исторически первая многозначная логика. Она являетсяпростейшим расширением двузначной логики.Чёткую математическую троичную логику, в которой имеется три чётких значения (0,1,2),(-1,0,+1), (0,1/2,1) идр.

Нечеткая логика — это надмножество классической булевой логики, логическое исчисление, являющееся расширением многозначной логики. Употребление термина "нечеткий" применительно к математической теории может ввести в заблуждение. Более точно ее суть характеризовало бы название "непрерывная логика". Аппарат нечеткой логики столь же строг и точен, как и классический, но вместе со значениями "ложь" и "истина" он позволяет оперировать значениями в промежутке между ними. Говоря образно, нечеткая логика позволяет ощущать все оттенки окружающего мира, а не только чистые цвета. Использование нечеткой логики принципиально упрощает решение многих задач. Во-первых, значительно проще и понятнее математический аппарат решения этих задач. Во-вторых, гораздо легче создать механизм адаптации подобной системы к изменяющимся входным параметрам. В-третьих, появляется возможность оперирования не только собственно значениями данных, но и степенью их достоверности.

В нечеткой логике, в отличие от классической, вместо величин истина и ложь используется величина степень истинности, принимающая любые значения из бесконечного множества от 0 до 1 включительно. Следовательно логические операции уже нельзя представить таблично. Сегодня элементы нечеткой логики можно найти в десятках промышленных изделий - от систем управления электропоездами и боевыми вертолетами до пылесосов и стиральных машин. Без применения нечеткой логики немыслимы современные ситуационные центры руководителей западных стран, где принимаются ключевые политические решения и моделируются разные кризисные ситуации.

Какие методы обучения нейросетей вы знаете?

Процесс обучения нейронной сети заключается в подстройке ее внутренних параметров под конкретную задачу. Алгоритм работы нейронной сети является итеративным, его шаги называют эпохами или циклами. Эпоха - одна итерация в процессе обучения, включающая предъявление всех примеров из обучающего множества и, возможно, проверку качества обучения на контрольном множестве. Процесс обучения осуществляется на обучающей выборке. Обучающая выборка включает входные значения и соответствующие им выходные значения набора данных. В ходе обучения нейронная сеть находит некие зависимости выходных полей от входных. Количество необходимых наблюдений зависит от сложности решаемой задачи. При увеличении количества признаков количество наблюдений возрастает нелинейно, эта проблема носит название "проклятие размерности". При недостаточном количестве данных рекомендуется использовать линейную модель. Алгоритм обучения однослойной нейронной сети

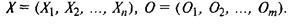

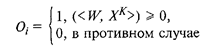

Обучение нейронной сети происходит на некоторой обучающей выборке, для каждого образца которой определяются и сравниваются с желаемыми значениями все текущие выходы. Если разница недопустима, то веса изменяются. Окончанием обучения считается ситуация, когда общая ошибка на всех образцах допустима. Рассмотрим обучение линейной однослойной сети, представленной на рис. 4.10. Структура обучающей выборки —  Пусть для обучения нам представлена выборка

Пусть для обучения нам представлена выборка

Приведем описание алгоритма обучения по шагам.

Приведем описание алгоритма обучения по шагам.

1. Введем k = 1; k — номер образца.

2. Случайным образом инициализируем матрицу весов Wij, Е = 0, где Е — ошибка.

3. Начнем обучение ( на модели ), для чего просчитаем все выходы

4. Рассчитаем разницу между текущими и желаемыми значениями выходов, т. е. вычислим (Yi — Оi, ), для каждого i.

5. Изменим веса по правилу Wi = Wi +  , || ( Уi — Оi ) || X для каждого Wi Yi.

, || ( Уi — Оi ) || X для каждого Wi Yi.

6. Вычислим накопленную ошибку Ei = Ej + 1/2  , выберем следующий образец из обучающей выборки k = k + l.

, выберем следующий образец из обучающей выборки k = k + l.

7. Проанализируем текущий результат. Если k  K тоследует учесть ошибку. Если значение ошибки Е меньше заданного уровня

K тоследует учесть ошибку. Если значение ошибки Е меньше заданного уровня  , то достигнуто окончание обучения. Если накопленная ошибка больше

, то достигнуто окончание обучения. Если накопленная ошибка больше  , то установим k = 1, Е = О и вернемся к шагу 3, т. е. продолжим обучение. В настоящее время существуют многочисленные простые примеры ( исключающее ИЛИ, счетчик количества единиц для входного вектора с размерностью больше 2), которые не решаются отдельным линейным суммирующим нейроном. Однако на сегодняшний день доказана теорема о сходимости алгоритма обучения однородной нейросети. Если задача лимейносепарабельна, то алгоритм обучения однослойной нейросети сходится за конечное число шагов. Для решения задач нелинейными разделяющими поверхностями используют многослойные нейросети, причем в качестве функций активации используют нелинейные функции. Алгоритм обучения по дельта-правилу.

, то установим k = 1, Е = О и вернемся к шагу 3, т. е. продолжим обучение. В настоящее время существуют многочисленные простые примеры ( исключающее ИЛИ, счетчик количества единиц для входного вектора с размерностью больше 2), которые не решаются отдельным линейным суммирующим нейроном. Однако на сегодняшний день доказана теорема о сходимости алгоритма обучения однородной нейросети. Если задача лимейносепарабельна, то алгоритм обучения однослойной нейросети сходится за конечное число шагов. Для решения задач нелинейными разделяющими поверхностями используют многослойные нейросети, причем в качестве функций активации используют нелинейные функции. Алгоритм обучения по дельта-правилу.

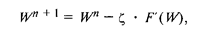

Все алгоритмы обучения нейросетей являются разновидностями алгоритма обучения по методу коррекции ошибки, которая осуществляется по-разному. Идея изменения весов НС Сводится к нахождению общей меры качества сети, в качестве 'Которой обычно выбирают функцию ошибки сети. Тогда, чтобы подобрать нужные веса, необходимо минимизировать функцию ошибки. Самым распространенным методом поиска минимума является метод градиентного спуска. Для случая функции с одной переменной веса изменяются в направлении, противоположном производной, т. е. справедлива формула

— некоторый уровень обучения, шаг изменения;

— некоторый уровень обучения, шаг изменения;

(W) — производная функции качества НС для одной переменной.

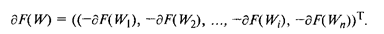

Таким образом, антиградиент — это набор следующих дифференциалов:

БИЛЕТ

2015-07-14

2015-07-14 719

719