Метод обучения. В качестве метода обучения сетей в ППП NNT версии 4 применяется функция train, которая позволяет установить процедуры обучения сети и настройки ее параметров, присваивая свойствам net.trainFcn и net.trainParam требуемые значения.

| train | Обучение нейронной сети |

Синтаксис:

[net, TR] = train(net,P,T,Pi,Ai)

[net, TR] = train(net,P,T,Pi,Ai,VV,TV)

Описание:

Функция [net, TR] = train(net, P, T, Pi, Ai) является методом для объектов класса network object, который реализует режим обучения нейронной сети. Эта функция характеризуется следующими входными и выходными аргументами.

Входные аргументы:

net – имя нейронной сети;

P – массив входов;

T – вектор целей, по умолчанию нулевой вектор;

Pi – начальные условия на линиях задержки входов, по умолчанию нулевой вектор;

Ai – начальные условия на линиях задержки слоев, по умолчанию нулевой вектор.

Выходные аргументы:

net – структура объекта network object после обучения;

TR – характеристики процедуры обучения:

TR.timesteps – длина последней выборки;

TR.perf – значения функции качества на последнем цикле обучения.

Заметим, что входной аргумент T используется только при наличии целевых выходов. Аргументы Pi и Pf используются только в случае динамических сетей, имеющих линии задержки на входах или в слоях.

Входные аргументы P и T могут иметь 2 формата: cell array и double array. Формат cell array наиболее прост для понимания и соответствует последовательному представлению данных.

Последовательное представление данных. Каждую строку массива ячеек можно рассматривать как временную последовательность, и тогда описание многомерной сети может быть представлено следующим образом:

P – массив ячеек размера Ni´TS, каждый элемент которого P{i, ts} – числовой массив размера Ri´Q;

T – массив ячеек размера Nt´TS, каждый элемент которого T{i, ts} – числовой массив размера Vi´Q;

Pi – массив ячеек размера Ni´ID, каждый элемент которого Pi{i, k} – числовой массив размера Ri´Q;

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Y – массив ячеек размера No´TS, каждый элемент которого Y{i, ts} – числовой массив размера Ui´Q;

Pf – массив ячеек размера Ni´ID, каждый элемент которого Pf{i, k} – числовой массив размера Ri´Q;

Af – массив ячеек размера Nl´LD, каждый элемент которого Af{i, k} – числовой массив размера Si´Q.

Параметры описания массивов ячеек и их связь с параметрами сети представлены

в следующей таблице.

| Параметр описания | Параметр сети | Назначение |

| Ni | net.numInputs | Количество векторов входа |

| Nl | net.numLayers | Количество слоев |

| No | net.numOutputs | Количество выходов |

| Nt | net.numTargets | Количество целевых выходов |

| ID | net.numInputDelays | Максимальное значение задержки на входе |

| TS | Число шагов по времени | |

| Q | Количество реализаций для фиксированного момента времени | |

| LD | net.numLayerDelays | Максимальные значения задержек для слоев |

| Ri | net.inputs{i}.size | Количество элементов i -го вектора входа |

| Si | net.layers{i}.size | Количество нейронов i -го слоя |

| Vi | net.targets{i}.size | Количество элементов i -го вектора цели |

| Ui | net.outputs{i}.size | Количество элементов i -го вектора выхода |

Столбцы массивов начальных условий Pi, Pf, Ai, Af упорядочены в соответствии со следующими условиями:

Pi{i, k} – значение начального условия для линии задержки i- го входа в момент времени ts = k – ID;

Pf{i, k} – значение начального условия для линии задержки i- го входа в момент времени ts = TS + k – ID;

Ai{i, k} – значение начального условия для линии задержки i- го слоя в момент времени ts = k – LD;

Af{i, k} – значение начального условия для линии задержки i- го слоя в момент времени ts = TS + k – LD.

Групповое представление данных можно использовать только при обучении статических сетей (TS = 1). При этом следует помнить, что при переходе от формата последовательного представления данных cell array к формату группового представления double array массив ячеек, содержащий, например, Ni числовых массивов размера Ri´Q, преобразуется

в единственный числовой массив размера  ´Q.

´Q.

Следующая таблица поясняет связь этих форм представления.

| Формат | |||

| Аргумент | Cell array | Double array | |

| Size(P) | Size(P{I,1}) | Size(P) | |

| P | Ni´1 | Ri´Q |

|

| T | Nt´1 | Vi´Q |

|

| Pi | Ni´ID | Ri´Q |

|

| Ai | Nl´LD | Si´Q |

|

Функция [net, TR] = train(net, P, T, Pi, Ai, VV, TV) позволяет использовать в процессе обучения контрольные и тестовые подмножества для оценки представительности используемых обучающих выборок. Эти подмножества описываются массивами структур со следующими полями:

VV.P, TV.P – контрольное и тестовое подмножества векторов входов;

VV.T, TV.T – контрольное и тестовое подмножества векторов целей;

VV.Pi, TV.Pi – начальные значения задержек на входе сети для контрольного и тестового подмножеств, по умолчанию нулевые;

VV.Ai, TV.Ai – начальные значения задержек на слоях для контрольного и тестового подмножеств, по умолчанию нулевые.

Алгоритм:

Метод train вызывает функцию обучения, заданную свойством net.trainFcn со значениями параметров обучения, заданными свойством net.trainParam. Обычно цикл обучения определяется как предъявление сети всех векторов входа. Затем выполняется настройка параметров сети. Обучение продолжается до тех пор, пока не будет выполнено заданное число циклов обучения, не будет достигнуто допустимое значение критерия качества обучения или выполнено любое другое условие остановки для выбранной функции обучения.

Сопутствующие функции: sim, init, adapt.

Представление входных данных. Для задания способа представления входных данных

в ППП NNT версии 4 включены функции trainb, trainc, trainr и trains. Эти функции должны быть заданы как значения свойства net.trainFcn. Для каждой из этих функций требуется задать желаемую функцию настройки параметров, присваивая соответствующие значения свойствам net.inputWeights{i, j}.learnFcn, net.layerWeights{i, j}.learnFcn, net.biases{i}.learnFcn.

| trainB | Групповое обучение |

1traiСинтаксис:

[net,TR,Ac,El] = trainb(net,Pd,Tl,Ai,Q,TS,VV,TV)

info = trainb(code)

Описание:

Функция trainb не вызывается непосредственно. К ней обращается метод train, когда свойство net.trainFcn соответствует значению 'trainb'. Функция trainb настраивает веса

и смещения при каждом предъявлении сети входной последовательности.

Функция [net, TR, Ac, El] = trainb(net Pd, Tl, Ai, Q, TS, VV, TV) имеет следующие входные и выходные аргументы.

Входные аргументы:

net – исходная нейронная сеть;

Pd – вектор максимальных задержек по слоям;

Tl – вектор целей для слоя;

Ai – начальные условия на линиях задержки;

Q – количество реализаций для фиксированного момента времени;

TS – число шагов по времени;

VV – структура, описывающая контрольное множество;

TV – структура, описывающая тестовое множество.

Выходные аргументы:

net – структура объекта network object после адаптации;

TR – характеристики процедуры обучения:

TR.epoch – вектор, определяющий циклы обучения;

TR.perf – значения функции качества по циклам обучения;

TR.vperf – значения контрольной функции по циклам обучения;

TR.tperf – значения тестовой функции по циклам обучения;

Ac – массив выходов слоя для последнего цикла;

El – массив ошибок слоя для последнего цикла.

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Параметры описания массивов ячеек и их связь с параметрами сети представлены

в следующей таблице.

| Параметр описания | Параметр сети | Назначение |

| Ni | net.numInputs | Количество векторов входа |

| Nl | net.numLayers | Количество слоев |

| Nt | net.numTargets | Количество целевых выходов |

| ID | net.numInputDelays | Максимальное значение задержки на входе |

| LD | net.numLayerDelays | Максимальные значения задержек для слоев |

| Ri | net.inputs{i}.size | Количество элементов i -го вектора входа |

| Si | net.layers{i}.size | Количество нейронов i -го слоя |

| Vi | net.targets{i}.size | Количество элементов i -го вектора цели |

| TS | Число шагов по времени | |

| Q | Количество реализаций для фиксированного момента времени | |

| Zij | Произведение длины вектора входа слоя i на максимальное значение задержки от слоя i к слою j: Ri * length(net.inputWeights{i, j}.delays) |

Если входные аргументы VV или TV не пустые ([ ]), то они должны быть массивами структур:

VV.PD, TV.PD – контрольное и тестовое подмножества векторов входов после линии задержки, по умолчанию нулевые;

VV.Tl, TV.Tl – контрольное и тестовое подмножества векторов целей слоя;

VV.Ai, TV.Ai – контрольное и тестовое подмножества начальных условий на входе;

VV.Q, TV.Q – число выборок контрольного и тестового подмножеств;

VV.TS, TV.TS – длина выборок контрольного и тестового подмножеств.

Контрольные и тестовые подмножества используются для предотвращения явления переобучения.

Процедура обучения прекращается при достижении следующих значений параметров функции trainb:

| Параметр | Назначение |

| net.trainParam.epochs | Максимальное число циклов обучения, по умолчанию 100 |

| net.trainParam.goal | Предельное значение показателя качества обучения, по умолчанию 0 |

| net.trainParam.max_fail | Максимально допустимый уровень превышения ошибки контрольного подмножества по сравнению с обучающим, по умолчанию 5 |

| net.trainParam.show | Интервал вывода данных, по умолчанию 25 циклов, отмена вывода – NaN |

| net.trainParam.time | Максимальное время обучения в секундах, по умолчанию Inf |

Функция info = trainb(code) возвращает информацию о параметрах группового обучения, соответствующую следующим значениям аргумента code:

'pnames' – имена параметров группового обучения;

'pdefaults' – значения параметров группового обучения, принимаемые по умолчанию.

Применение функции:

Чтобы сформировать нейронную сеть, используя функцию обучения trainb, следует:

· установить свойство net.trainFcn равным 'trainb'. Это автоматически установит свойство net.trainParam равным значению по умолчанию;

· установить значения свойств net.inputWeights{i, j}.learnFcn, net.layerWeights{i, j}.learnFcn, net.biases{i}.learnFcn соответствующими выбранным функциям настройки.

Для того чтобы фактически выполнить групповое обучение сети, необходимо:

· установить желаемые значения параметров настройки весов и смещений;

· установить желаемые значения свойств net.trainParam;

· вызвать функцию train.

Алгоритм:

Элементы матриц весов и векторов смещения изменяются в соответствии с заданной функцией настройки на каждом цикле обучения.

Обучение прекращается, когда выполняется одно из следующих условий:

· достигнуто максимальное число циклов обучения;

· значение функции качества стало меньше предельного;

· превышено максимальное время, отпущенное на обучение;

· ошибка контрольного подмножества превысила ошибку обучающего более чем

в max_fail раз.

Пример:

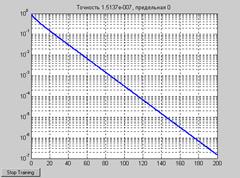

Сформировать динaмическую линейную нейронную сеть с одним выходом, линией задержки на входе [0 1], диапазоном изменения элементов входа [–1 1] и адаптивно обучить ее за 200 циклов с параметром скорости обучения 0.01.

Формирование сети:

net = newlin([–1 1],1,[0 1],0.01);

Формирование векторов входа и цели:

P1 = {0 –1 1 1 0 –1 1 0 0 1};

T1 = {0 –1 0 2 1 –1 0 1 0 1};

Групповое обучение:

net.trainFcn='trainb';

net.trainParam.epochs = 200;

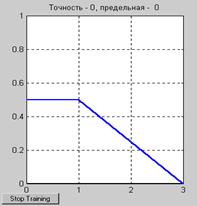

[net,TR]=train(net,P1,T1); % Рис.11.42

На рис. 11.42 представлена зависимость показателя качества в течение 200 циклов обучения.

Рис. 11.42

Рис. 11.42

Выполним моделирование сети при заданном входе:

Y = sim(net,P1); Y = [Y{:}]

Y = 0.0002 –0.9994 0.0003 1.9993 0.9997

–0.9994 0.0003 0.9997 0.0002 0.9998

Результат моделирования близок к вектору целей. При этом среднеквадратичная ошибка составляет

E = mse(Y–[T1{:}])

E = 1.5137e–007

Сопутствующие функции: NEWP, NEWLIN, TRAIN.

| trainc | Обучение нейронной сети c циклическим представлением входа |

Синтаксис:

[net,TR,Ac,El] = trainc(net,Pd,Tl,Ai,Q,TS,VV,TV)

info = trainc(code)

Описание:

Функция trainc не вызывается непосредственно. К ней обращается метод train, когда свойство net.trainFcn соответствует значению 'trainc'. Функция trainc настраивает веса и смещения при каждом предъявлении сети входной последовательности в циклическом порядке.

Функция [net, TR, Ac, El] = trainc(net Pd, Tl, Ai, Q, TS, VV, TV) имеет следующие входные и выходные аргументы.

Входные аргументы:

net – исходная нейронная сеть;

Pd – вектор максимальных задержек по слоям;

Tl – вектор целей для слоя;

Ai – начальные условия на линиях задержки;

Q – количество реализаций для фиксированного момента времени;

TS – число шагов по времени;

VV – структура, описывающая контрольное множество;

TV – структура, описывающая тестовое множество.

Выходные аргументы:

net – структура объекта network object после адаптации;

TR – характеристики процедуры обучения:

TR.epoch – вектор, определяющий циклы обучения;

TR.perf – значения функции качества по циклам обучения;

Ac – массив выходов слоя для последнего цикла;

El – массив ошибок слоя для последнего цикла.

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Параметры описания массивов ячеек и их связь с параметрами сети представлены

в следующей таблице.

| Параметр описания | Параметр сети | Назначение |

| Ni | net.numInputs | Количество векторов входа |

| Nl | net.numLayers | Количество слоев |

| Nt | net.numTargets | Количество целевых выходов |

| ID | net.numInputDelays | Максимальное значение задержки на входе |

| LD | net.numLayerDelays | Максимальные значения задержек для слоев |

| Ri | net.inputs{i}.size | Количество элементов i -го вектора входа |

| Si | net.layers{i}.size | Количество нейронов i -го слоя |

| Vi | net.targets{i}.size | Количество элементов i -го вектора цели |

| TS | Число шагов по времени | |

| Q | Количество реализаций для фиксированного момента времени | |

| Zij | Произведение длины вектора входа слоя i на максимальное значение задержки от слоя i к слою j: Ri * length(net.inputWeights{i, j}.delays) |

Функция trainc не выполняет проверки обучающей последовательности на представительность, поэтому входные аргументы VV и TV не используются.

Процедура обучения прекращается при достижении следующих значений параметров функции trainc:

| Параметр | Назначение |

| net.trainParam.epochs | Максимальное число циклов обучения, по умолчанию 100 |

| net.trainParam.goal | Предельное значение показателя качества обучения, по умолчанию 0 |

| net.trainParam.show | Интервал вывода данных, по умолчанию 25 циклов, отмена вывода – NaN |

| net.trainParam.time | Максимальное время обучения в секундах, по умолчанию Inf |

Функция info = trainc(code) возвращает информацию о параметрах обучения, соответствующую следующим значениям аргумента code:

'pnames' – имена параметров процедуры обучения с циклическим представлением входа;

'pdefaults' – значения параметров процедуры обучения с циклическим представлением входа, принимаемые по умолчанию.

Применение функции:

Чтобы сформировать нейронную сеть, используя функцию обучения trainc, следует:

· установить свойство net.trainFcn равным 'trainc'. Это автоматически установит свойство net.trainParam равным значению по умолчанию;

· установить значения свойств net.inputWeights{i, j}.learnFcn, net.layerWeights{i, j}.learnFcn, net.biases{i}.learnFcn соответствующими выбранным функциям настройки.

Для того чтобы фактически выполнить обучение сети, необходимо:

· установить желаемые значения параметров настройки весов и смещений;

· установить желаемые значения свойств net.trainParam;

· вызвать функцию train.

Алгоритм:

Элементы матриц весов и векторов смещения изменяются в соответствии с заданной функцией настройки на каждом цикле обучения.

Обучение прекращается, когда выполняется одно из следующих условий:

· достигнуто максимальное число циклов обучения;

· значение функции качества стало меньше предельного;

· превышено максимальное время, отпущенное на обучение.

Пример:

Сформировать нейронную сеть на основе персептрона с одним выходом и вектором входа из двух элементов, принимающих значения в диапазоне [–2 2].

Формирование сети:

net = newp([–2 2; –2 2],1);

Формирование векторов входа и цели:

P = [ 2 1 –2 –1;

2 –2 2 1];

T = [ 0 1 0 1];

Обучение с циклическим представлением входа:

net.trainFcn='trainc';

[net,TR]=train(net,P,T); % Рис.11.43

На рис. 11.43 представлена зависимость показателя качества обучения от количества циклов обучения. Нетрудно убедиться, что абсолютная точность достигается на третьем цикле обучения.

Рис. 11.43

Рис. 11.43

Выполним моделирование сети при заданном входе:

Y = sim(net, P)

Y = 0 1 0 1

Полученный результат полностью совпадает с заданием.

Найдем значения весов и смещения:

net.IW{1,1}, net.b{1}

ans = –2 –3

ans = 1

Сопутствующие функции: NEWP, NEWLIN, TRAIN.

| trainr | Обучение нейронной сети в режиме случайного представления входа |

Синтаксис:

[net,TR,Ac,El] = trainr(net,Pd,Tl,Ai,Q,TS,VV,TV)

info = trainr(code)

Описание:

Функция trainr не вызывается непосредственно. К ней обращается метод train, когда свойство net.trainFcn соответствует значению 'trainr'. Функция trainr настраивает веса

и смещения при каждом предъявлении сети случайной входной последовательности.

Функция [net, TR, Ac, El] = trainr(net Pd, Tl, Ai, Q, TS, VV, TV) имеет следующие входные и выходные аргументы.

Входные аргументы:

net – исходная нейронная сеть;

Pd – вектор максимальных задержек по слоям;

Tl – вектор целей для слоя;

Ai – начальные условия на линиях задержки;

Q – количество реализаций для фиксированного момента времени;

TS – число шагов по времени;

VV – структура, описывающая контрольное множество;

TV – структура, описывающая тестовое множество.

Выходные аргументы:

net – структура объекта network object после адаптации;

TR – характеристики процедуры обучения:

TR.epoch – вектор, определяющий циклы обучения;

TR.perf – значения функции качества по циклам обучения;

Ac – массив выходов слоя для последнего цикла;

El – массив ошибок слоя для последнего цикла.

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Параметры описания массивов ячеек и их связь с параметрами сети представлены

в следующей таблице.

| Параметр описания | Параметр сети | Назначение |

| Ni | net.numInputs | Количество векторов входа |

| Nl | net.numLayers | Количество слоев |

| Nt | net.numTargets | Количество целевых выходов |

| ID | net.numInputDelays | Максимальное значение задержки на входе |

| LD | net.numLayerDelays | Максимальные значения задержек для слоев |

| Ri | net.inputs{i}.size | Количество элементов i -го вектора входа |

| Si | net.layers{i}.size | Количество нейронов i -го слоя |

| Vi | net.targets{i}.size | Количество элементов i -го вектора цели |

| TS | Число шагов по времени | |

| Q | Количество реализаций для фиксированного момента времени | |

| Zij | Произведение длины вектора входа слоя i на максимальное значение задержки от слоя i к слою j: Ri * length(net.inputWeights{i, j}.delays) |

Функция trainr не выполняет проверки обучающей последовательности на представительность, поэтому входные аргументы VV и TV не используются.

Процедура обучения прекращается при достижении следующих значений параметров функции trainr:

| Параметр | Назначение |

| net.trainParam.epochs | Максимальное число циклов обучения, по умолчанию 100 |

| net.trainParam.goal | Предельное значение показателя качества обучения, по умолчанию 0 |

| net.trainParam.show | Интервал вывода данных, по умолчанию 25 циклов, отмена вывода – NaN |

| net.trainParam.time | Максимальное время обучения в секундах, по умолчанию Inf |

Функция info = trainr(code) возвращает информацию о параметрах обучения, соответствующую следующим значениям аргумента code:

'pnames' – имена параметров процедуры обучения в режиме случайного представления входа;

'pdefaults' – значения параметров процедуры обучения в режиме случайного представления входа, принимаемые по умолчанию.

Применение функции:

Чтобы сформировать нейронную сеть, используя функцию обучения trainr, следует:

· установить свойство net.trainFcn равным 'trainr'. Это автоматически установит свойство net.trainParam равным значению по умолчанию;

· установить значения свойств net.inputWeights{i, j}.learnFcn, net.layerWeights{i, j}.learnFcn, net.biases{i}.learnFcn соответствующими выбранным функциям настройки.

Для того чтобы фактически выполнить обучение сети, необходимо:

· установить желаемые значения параметров настройки весов и смещений;

· установить желаемые значения свойств net.trainParam;

· вызвать функцию train.

Алгоритм:

Элементы матриц весов и векторов смещения изменяются в соответствии с заданной функцией настройки на каждом цикле обучения.

Обучение прекращается, когда выполняется одно из следующих условий:

· достигнуто максимальное число циклов обучения;

· значение функции качества стало меньше предельного;

· превышено максимальное время, отпущенное на обучение.

Пример:

Сформировать самоорганизующуюся нейронную сеть для разделения векторов входа на 2 класса. Векторы входа состоят из двух элементов со значениями из диапазона [0 1]. Сеть имеет 2 выхода (по числу классов) и обучается с помощью функции trainr.

Формирование сети:

net = newc([0 1; 0 1], 2);

Формирование векторов входа:

P = [.1.8.1.9;

.2.9.1.8];

Обучение с циклическим представлением входа:

net.trainFcn ='trainr';

net = train(net,P,T);

Выполним моделирование сети и значения выхода преобразуем в индексы классов:

Y = sim(net,P);

Yc = vec2ind(Y)

Yc = 1 2 1 2

Нейронная сеть справилась с классификацией входных векторов на 2 класса, отнеся первый и третий векторы к классу 1, а второй и четвертый – к классу 2.

Сопутствующие функции: NEWP, NEWLIN, TRAIN.

Функции обучения. Ниже приведены функции ППП NNT, совместимые как с 11, так и с 12 выпусками ПО MW и предназначенные для реализации конкретных алгоритмов обучения и настройки параметров сети. Все эти функции имеют одинаковый формат вызова

[net,TR,Ac,El] = <имя_функции>(NET,Pd,Tl,Ai,Q,TS,VV,TV)

Они имеют следующие входные и выходные аргументы.

Входные аргументы:

net – исходная нейронная сеть;

Pd – вектор максимальных задержек по слоям;

Tl – вектор целей для слоя;

Ai – начальные условия на линиях задержки;

Q – количество реализаций для фиксированного момента времени;

TS – число шагов по времени;

VV – структура, описывающая контрольное множество;

TV – структура, описывающая тестовое множество.

Выходные аргументы:

net – структура объекта network object после адаптации;

TR – массив записей, содержащий характеристики процедуры обучения:

TR.epoch – вектор, определяющий циклы обучения;

TR.perf – значения функции качества по циклам обучения;

TR.vperf – значения контрольной функции по циклам обучения;

TR.tperf – значения тестовой функции по циклам обучения;

Ac – массив выходов слоя для последнего цикла;

El – массив ошибок слоя для последнего цикла.

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Входные и выходные массивы характеризуются следующими размерами:

Pd – массив ячеек размера ID´Ni´TS, каждый элемент которого Pd{i, j, ts} – числовой массив размера Zij´Q;

Tl – массив ячеек размера Nl´TS, каждый элемент которого Tl{i, ts} – числовой массив размера Vi´Q, возможно пустой [];

Ai – массив ячеек размера Nl´LD, каждый элемент которого Ai{i, k} – числовой массив размера Si´Q;

Ac – массив ячеек размера Nl´(LD+TS), каждый элемент которого Ac{i, k} – числовой массив размера Si´Q;

El – массив ячеек размера Nl´TS, каждый элемент которого El{i, k} – числовой массив размера Vi´Q, возможно пустой [].

Параметры описания массивов ячеек и их связь с параметрами сети представлены

в следующей таблице.

| Параметр описания | Параметр сети | Назначение |

| Ni | net.numInputs | Количество векторов входа |

| Nl | net.numLayers | Количество слоев |

| Nt | net.numTargets | Количество целевых выходов |

| ID | net.numInputDelays | Максимальное значение задержки на входе |

| LD | net.numLayerDelays | Максимальные значения задержек для слоев |

| Ri | net.inputs{i}.size | Количество элементов i -го вектора входа |

| Si | net.layers{i}.size | Количество нейронов i -го слоя |

| Vi | net.targets{i}.size | Количество элементов i -го вектора цели |

| TS | Число шагов по времени | |

| Q | Количество реализаций для фиксированного момента времени | |

| Zij | Произведение длины вектора входа слоя i на максимальное значение задержки от слоя i к слою j: Ri * length(net.inputWeights{i, j}.delays) |

Если входные аргументы VV или TV не пустые ([ ]), то они должны быть массивами структур:

VV.PD, TV.PD – контрольное и тестовое подмножества векторов входов после линии задержки, по умолчанию нулевые;

VV.Tl, TV.Tl – контрольное и тестовое подмножества векторов целей слоя;

VV.Ai, TV.Ai – контрольное и тестовое подмножества начальных условий на входе;

VV.Q, TV.Q – число выборок контрольного и тестового подмножеств;

VV.TS, TV.TS – длина выборок контрольного и тестового подмножеств.

Контрольные и тестовые подмножества используются для предотвращения явления переобучения.

Функции обучения могут включать следующие параметры:

| Параметр | Назначение |

| net.trainParam.epochs | Максимальное количество циклов (эпох) обучения, по умолчанию 100 |

| net.trainParam.goal | Предельное значение критерия обучения, по умолчанию 0 |

| net.trainParam.show | Интервал вывода данных, по умолчанию 25 циклов, отмена вывода – NaN |

| net.trainParam.min_grad | Минимальное значение градиента критерия качества, по умолчанию 1e–6 |

| net.trainParam.time | Максимальное время обучения в секундах, по умолчанию Inf |

| net.trainParam.max_fail | Максимально допустимый уровень превышения ошибки контрольного подмножества по сравнению с обучающим, по умолчанию 5 |

| net.trainParam.searchFcn | Имя функции поиска одномерного экстремума, по умолчанию 'srchbac' |

Функции поиска одномерного экстремума также включают достаточно большое

количество настраиваемых параметров, приведенных в следующей таблице:

| Параметр | Назначение |

| net.trainParam.scal_tol | Параметр, связывающий погрешность tol с шагом delta по формуле tol = delta/scale_tol, по умолчанию 20 |

| net.trainParam.alpha | Коэффициент, определяющий порог уменьшения критерия качества, по умолчанию 0.001 |

| net.trainParam.beta | Коэффициент, определяющий выбор шага, по умолчанию 0.1 |

| net.trainParam.delta | Начальное значение шага, по умолчанию 0.01 |

| net.trainParam.gama | Параметр, регулирующий изменение критерия качества, по умолчанию 0.1 |

| net.trainParam.low_lim | Нижняя граница изменения шага, по умолчанию 0.1 |

| net.trainParam.up_lim | Верхняя граница изменения шага, по умолчанию 0.5 |

| net.trainParam.maxstep | Максимальное значение шага, по умолчанию 100 |

| net.trainParam.minstep | Минимальное значение шага, по умолчанию 1.0e–6 |

| net.trainParam.bmax | Максимальный размер шага, по умолчанию 26 |

| net.trainParam.mu | Начальное значение |

| net.trainParam.mu_dec | Коэффициент уменьшения параметра mu, по умолчанию 0.1 |

| net.trainParam.mu_inc | Коэффициент увеличения параметра mu, по умолчанию 10 |

| net.trainParam.mu_max | Максимальное значение параметра mu, по умолчанию 1e–10 |

| net.trainParam.mem_reduc | Параметр разбиения матрицы Якоби на подматрицы, по умолчанию 1 |

| net.trainParam.lr | Параметр, по умолчанию 0.01 |

| net.trainParam.lr_inc | Коэффициент увеличения скорости настройки, по умолчанию 1.05 |

| net.trainParam.lr_dec | Коэффициент уменьшения скорости настройки, по умолчанию 0.7 |

| net.trainParam.delta0 | Начальное значение шага настройки в методе Rprop, по умолчанию 0.07 |

| net.trainParam.delt_inc | Коэффициент увеличения шага настройки в методе Rprop, по умолчанию 1.2 |

| net.trainParam.delt_dec | Коэффициент уменьшения шага настройки в методе Rprop, по умолчанию 0.5 |

| net.trainParam.deltamax | Максимальное значение шага настройки в методе Rprop, по умолчанию 50 |

При описании каждой функции одномерного поиска приводится перечень используемых параметров.

Кроме того, все функции возвращают информацию о параметрах обучающей функции, если используется следующий формат вызова:

info = <имя_функции>(code).

В зависимости от значения аргумента code возвращается следующая информация:

'pnames' – имена параметров процедуры обучения;

'pdefaults' – значения параметров процедуры обучения, принимаемые по умолчанию.

В качестве примера, иллюстрирующего возможности обучения, рассмотрен общий пример, что позволяет сравнивать описываемые алгоритмы обучения по скорости и точности.

2015-08-21

2015-08-21 515

515