Для измерения информации вводятся два параметра: количество информации I и объем данных V д.

Эти параметры имеют разные выражения и интерпретацию в зависимости от рассматриваемой формы адекватности. Каждой форме адекватности соответствует своя мера количества информации и объема данных

Синтаксическая мера информации

Эта мера количества информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту.

Объем данных Vд в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных системах счисления один разряд имеет различный вес и соответственно меняется единица измерения данных:

- в двоичной системе счисления один разряд имеет вес, равный 2, и соответственно единицей измерении будет – бит (bit – binary digit – двоичный разряд);

- в десятичной системе счисления один разряд имеет вес, равный 10, и соответственно единицей измерении будет – дит (десятичный разряд).

Пример. Сообщение в двоичной системе в виде восьмиразрядного двоичного кода 10111011 имеет объем данных Vд = 8 бит.

Сообщение в десятичной системе в виде шестиразрядного числа 275903 имеет объем данных Vд = 6 дит.

В современной вычислительной технике наряду с минимальной единицей измерения данных "бит" широко используется укрупненная единица измерения "байт", равная 8 бит.

При работе с большими объемами информации для подсчета ее количества применяют более крупные единицы измерения:

1 Кбайт = 1024 байт, 1 Мбайт = 1024 Кбайт, 1Гбайт = 1024 Мбайт, 1Тбайт = 1024 Гбайт (тера).

Количество информации I на синтаксическом уровне невозможно определить без рассмотрения понятия неопределенности состояния системы (энтропии системы). Действительно, получение информации о какой-либо системе всегда связано с уменьшением степени неосведомленности получателя о состоянии этой системы. Количество информации в сообщении определяется как мера уменьшения неопределенности состояния данной системы после получения сообщения.

В качестве меры неопределенности вводится энтропия Н, а количество информации равно:

,

,

где  - априорная энтропия о состоянии исследуемой системы или процесса;

- априорная энтропия о состоянии исследуемой системы или процесса;

- апостериорная энтропия.

- апостериорная энтропия.

Апостериори – происходящее из опыта (испытания, измерения).

Априори – понятие, характеризующее знание, предшествующее опыту (испытанию), и независимое от него.

В случае, когда в ходе испытания имевшаяся неопределенность снята (получен конкретный результат, т.е. Haps = 0), количество полученной информации совпадает с первоначальной энтропией  .

.

Энтропия — это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

Энтропия системы (мера неопределенности) H, имеющая N возможных состояний, согласно формуле Шеннона, равна:

гдеpi - вероятность i-го события.

Для случая, когда все состояния системы равновероятны, т.е. их вероятности равны pi = 1/N, ее энтропия определяется соотношением:

- формула Р.Хартли.

- формула Р.Хартли.

Основание логарифма в формуле Хартли не имеет принципиального значения и определяет только масштаб или единицу измерения. В зависимости от основания логарифма применяют следующие единицы измерения:

1. Биты – при этом основание логарифма равно 2:

2. Наты – при этом основание логарифма равно е:

3. Диты – при этом основание логарифма равно 10:

Так как современная информационная техника базируется на элементах, имеющих два устойчивых состояния (0 или 1), то в информатике в качестве меры неопределенности обычно используют формулу  . Информация в один бит уменьшает неопределённость информационной системы в 2 раза.

. Информация в один бит уменьшает неопределённость информационной системы в 2 раза.

Пример1. Рассмотрим систему с 256 возможными состояниями, например расширенную кодовую таблицу символов (ASCII), тогда H=log2256 = 8 бит. Другими словами, восемь бит достаточно, чтобы точно описать исход любого события (например, выборку определённого символа из таблицы).

Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус пользователя.

Тезаурус - это совокупность сведений, которыми располагает пользователь или система.

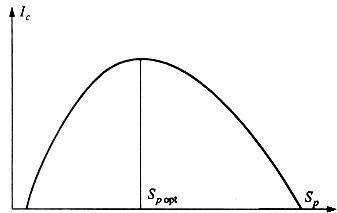

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя Sp изменяется количество семантической информации Iс, воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис. 1.

Рис. 1. Зависимость количества семантической информации, воспринимаемой потребителем, от его тезауруса Ic = f (Sp)

Рассмотрим два предельных случая, когда количество семантической информации Iс равно 0:

при Sp = 0 пользователь не воспринимает (не понимает) поступающую информацию;

при Sp ® ¥ пользователь «все знает», и поступающая информация ему не нужна.

Максимальное количество семантической информации Ic потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом Sp (Sp = Sp opt), когда поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения.

Следовательно, количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя некомпетентного.

При оценке семантического (содержательного) аспекта информации необходимо стремиться к согласованию величин S и S p.

Относительной мерой количества семантической информации может служить коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему:

.

.

Прагматическая мера информации

Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цели. Эта мера также величина относительная, обусловленная особенностями использования этой информации в той или иной системе.

Отечественный ученый А.А.Харкевич предложил принять за меру ценности информации количество информации, необходимое для достижения поставленной цели, т.е. рассчитывать приращение вероятности достижения цели. Так, если до получения информации вероятность достижения цели равнялась Р0, а после ее получения – Р1, то ценность информации определяется по формуле:

.

.

Таким образом, ценность информации при этом измеряется в единицах информации, в данном случае в битах.

2014-01-24

2014-01-24 1250

1250