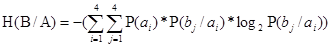

Если существует статистическая связь между символами алфавита источника и приемника, то энтропия приемника по отношению к источнику определится по формуле:

(3.6)

(3.6)

H(B/A) = 0.979 бит/символ

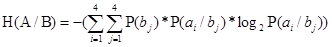

Энтропия источника по отношению к приемнику рассчитается аналогично:

(3.7)

(3.7)

H(A/B) = 1.134 бит/символ

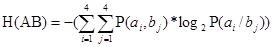

Энтропия совместных А и В будет в таком случае найдена по следующей формуле:

(3.8)

(3.8)

H(AB) = 3.134 бит/2 символа

Размерность [бит/2 символа] означает, что взаимная энтропия представляет собой неопределенность возникновения пары символов, т.е. неопределенность на два символа.

Опираясь на формулы 3.2 и 3.4, можно показать, что энтропия появления событий АВ будет также рассчитываться как:

H(AB) = H(B) – H(A/B) (3.9)

Из данной формулы можно выразить формулы для определения энтропии источника и приемника:

H(A) = H(AB) – H(B/A) (3.10)

Н(А) = 2.155 бит/символ

H(B) = H(AB) – H(A/B) (3.11)

Н(В) = 2 бит/символ

2020-01-15

2020-01-15 261

261