Интервальный метод.

При использовании этого метода регистрации сигналов недостаток обнаруживается:

1. В задержке принятия информации на время  .

.

2. Если закон полной энергии за время  будет равняться

будет равняться  , то тогда решение не определено.

, то тогда решение не определено.

Этот метод сочетает 2 предыдущих метода и позволяет избежать многих недостатков. Внутри значащего интервала  стробирование. В этом случае при решении задачи 2 используется метод мажорирования. В этом случае импульсы должны быть частотными нечетными. Метод мажорирования совпадает с логической операцией неравнозначности (сложение по модулю 2).

стробирование. В этом случае при решении задачи 2 используется метод мажорирования. В этом случае импульсы должны быть частотными нечетными. Метод мажорирования совпадает с логической операцией неравнозначности (сложение по модулю 2).

Количественная мера информации.

Центральная проблема теории информации - это выбор меры информации. Будем рассматривать дискретный источник с четным множеством своих сочетаний.

Такой источник считается заданным, если задан ансамбль состоянии:

и обязательно должны быть заданы априорные вероятности этих состояний, каким способом мы их задаем не имеет значения):

, где

, где  - число возможных состоянии,

- число возможных состоянии,  - длина).

- длина).

При  - никакого выбора нет, источник находится в состоянии 1 (ничего нового не несет).

- никакого выбора нет, источник находится в состоянии 1 (ничего нового не несет).

- предложенная мера не обладает свойством аддитивности, т.е. не обладает свойствами линейно возрастать.

- предложенная мера не обладает свойством аддитивности, т.е. не обладает свойствами линейно возрастать.

| Было замечено, что количество информации в сообщении вырабатывающего источника зависит от вероятности этого сообщения. Из соображения здравого смысла, менее вероятное событие несет больше количества информации.

события.

события.

- заданные вероятности.

- заданные вероятности.

Клод Шеннон вывел эту зависимость.

Если задан источник  , то

, то  - Хартли. Основание логарифма принципиальной меры не имеет:

- Хартли. Основание логарифма принципиальной меры не имеет:

, десятичная единица, (дит);

, десятичная единица, (дит);

, натуральная единица, (нат);

, натуральная единица, (нат);

, двоичная единица, (бит) - количество информации которое вырабатывает источник с двумя возможными состояниями.

, двоичная единица, (бит) - количество информации которое вырабатывает источник с двумя возможными состояниями.

К. Шеннон предложил оценивать количество информации содержащееся в сведении о состоянии двоичного источника с равновероятными состояниями:

Было замечено, что количество информации в сообщении, вырабатываемом источником, зависит от вероятности этого сообщения. Менее вероятное событие несет большее количество информации. Если имеется  тогда

тогда

- эту зависимость вывел Клод Шеннон.

Пример: самая вероятная буква алфавита - "О", самая маловероятная - "Ф"

Для того, чтобы сравнить информационные свойства источника принято эту оценку проводить путем усреднения, т.е. провести операцию математического, ожидания.

это среднее количество информации на сообщение, которое вырабатывает источник. [бит/сообщение ]

это среднее количество информации на сообщение, которое вырабатывает источник. [бит/сообщение ]

Энтропия источника:  - характеризует степень неопределенности состояния источника. (Но с точки зрения получателя информации: энтропия частично или полностью уменьшается).

- характеризует степень неопределенности состояния источника. (Но с точки зрения получателя информации: энтропия частично или полностью уменьшается).

Поскольку вычисленная таким образом энтропия не учитывает статистическую связь (корреляцию) между состоянием источника (сообщения), то такая энтропия называется безусловной (между сообщением  нет корреляции).

нет корреляции).

Реально между состоянием источника существует статистическая связь (существует связь между состояниями  ).

).

- вероятность перехода из состояния

- вероятность перехода из состояния  в

в  .

.

Для того, чтобы учесть статистическую связь, необходимо кроме априорных вероятностей  знать переходные вероятности

знать переходные вероятности  .

.

Пример: задан источник с состоянием ( ) и априорные состояния

) и априорные состояния  .

.

Определить безусловную энтропию источника.

| Ai | P(ai) |

| A1 | 0,5 |

| A2 | 0,25 |

| A3 | 0,125 |

| A4 | 0,125 |

Хартли:

-это частный случай

- априорная вероятность состояния 1;

- априорная вероятность состояния 1;

- априорная вероятность состояния 2;

- априорная вероятность состояния 2;

Удобной моделью источника с зависимыми выборами является Марковская модель. Представленный выше граф есть не что иное как модель однородного

марковского процесса с двумя состояниями.

Важной характеристикой Марковского процесса является его вектор финальных вероятностей за n - шагов перехода, т.е. за n - шагов перехода нужно найти эту матрицу (вектор):

- матрица финальных состояний;

это полная группа несовместных событий, поэтому сумма коэффициентов по строке =1=>

Необходимо знать вектор начальных вероятностей:

Вектор финальных вероятностей равен произведению матриц переходных вероятностей в степени n на вектор начальных вероятностей.

Пример: Задан двоичный источник информации (a1,а2), заданы априорные состояния (Р(а1), P(a2)) и переходная вероятность Pij.

Найти вероятность застать источник информации в состоянии а1 и а2 поcле п шагов перехода при условии, что процесс симметричный (т.е. переход из а1 в а1 равномерен с переходом а2 и а2).

( ) - симметричный процесс.

) - симметричный процесс.

Составляем матрицу:

Из полученного выражения видно, что при  финальные вероятности стремятся к 0,5, т.е. становятся равны.

финальные вероятности стремятся к 0,5, т.е. становятся равны.

При этом -энтропия источника максимальная.

Энтропия.

Определяется но формуле:

;

;

где  - не статистическая случайная величина.

- не статистическая случайная величина.

Свойства энтропии:

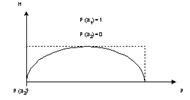

1. Максимальное значение энтропии - это когда все состояния источника равновероятны.

- числе состояний источника.

- числе состояний источника.

Пример:

2. Энтропия равна нулю, если одно из состояний источника является достоверным событием, т.е. равна 1.

3. Энтропия всегда величина положительная (неотрицательная).

Это легко показать на графике:

Значение ноль при  - это следует из второго свойства энтропии.

- это следует из второго свойства энтропии.

Условная энтропия, определяемая через условные энтропии.

Задан источник с  состояниями:

состояниями:

— состояния

— состояния

— заданы априорные вероятности.

— заданы априорные вероятности.

( - это значит, что задаются интервалы

- это значит, что задаются интервалы  – от

– от  до

до  , вероятность перехода из

, вероятность перехода из

- это случайные переходы.

- это случайные переходы.

Для того чтобы осуществить процесс перехода из одного состояния в другое, необходимо чтобы источник априори с вероятностью P(ai) находился в состоянии ( ).

).

- частная энтропия.

- частная энтропия.

Эти все случайные величины - усредненные математические ожидания - к теперь их необходимо еще раз усреднить:

- эту формулу первоначально вывел Клод Шеннон

- эту формулу первоначально вывел Клод Шеннон

Учет (наличие) статистической связи между источниками приводит к уменьшению энтропии (к степени неопределенности состояния источника).

Например:

1 случай:

вероятность каждой буквы =

- ничего не учитываем

- ничего не учитываем

2 случай: если учтем неодинаковую вероятность, то

, а статистическая связь не учитывается.

, а статистическая связь не учитывается.

(при условии, что вероятности неодинаковы).

(при условии, что вероятности неодинаковы).

(8 - глубина учета статистической связи (глубина - 8 букв)).

Таким образом можно ввести понятие об избыточности сообщения (информации в сообщении; избыточности у источника не может быть).

формула избыточности

- реальная энтрапия.

- реальная энтрапия.

- максимальная энтропия.

- максимальная энтропия.

Производительность:

Математические модели сигналов, каналов и помех.

Сигналы, каналы и помехи являются объектами сложной природы. Например: сигнал представляется некоторой случайной функцией  X(t), канал задан своей функцией

X(t), канал задан своей функцией  со своим коэффициентом передачи и т.д.

со своим коэффициентом передачи и т.д.

Одной из идей позволяющих построить мат модель сигнала является разложение на элементарные сигналы.

Появляется возможность решения некоторых задач по каналу K(t) в виде решения элементарных задач, которые заключаются в передаче простых функций (используя принцип суперпозиции).

|

Если комбинация линейна и задача 4х-полюсник (канал) то на выходе получим линейную комбинацию.

Это будет справедливо лишь тогда, когда множество этих функций  -линейно независимы. (Линейные это когда жизнь каждой из элементарных функций независима, то есть время у них одинаково, но живут они в разных пространствах.)

-линейно независимы. (Линейные это когда жизнь каждой из элементарных функций независима, то есть время у них одинаково, но живут они в разных пространствах.)

Такими свойствами (линейной независимостью) обладает класс ортогональных функций.

Две ортогональные функции:  .

.

Свойства линейно независимых функций:

1. Математически это означает, что векторы элементарных функций взаимно перпендикулярны.

2. Любые два сигнала, выбранные из множества ортогональных, статистически независимы (не коррелированны).

Корреляция - статистическая связь.

Коэффициент корреляции определяется по следующей формуле:

Общее условие: если две функции ортогональны, то:

Интеграл характеризует взаимную энергию двух сигналов (но в нашем случае они линейно независимы и не имеют взаимной энергии).

Формула энергии сигнала  :

:

Средняя мощность процесса  (средне статистическая мощность):

(средне статистическая мощность):

Иногда удобно чтобы  ,при

,при  . Для этого производят нормирование функций.

. Для этого производят нормирование функций.

……,

……,

И тогда получим ортонормированны функции:

Примерами таких линейно независимых ортогональных функций являются функции Уолша,  и т.д.

и т.д.

Как вычислить весовой коэффициент?

Подставляем:

Учитывая свойство ортогональности, можно утверждать, что при всех  -не равных

-не равных  этот интеграл равен нулю, и только водном случае,

этот интеграл равен нулю, и только водном случае,

Когда  , и будет равен интеграл

, и будет равен интеграл  :

:

-обобщенный коэффициент Фурье.

-обобщенный коэффициент Фурье.

-принято называть спектром колебаний (набор коэффициентов при разложении).

-принято называть спектром колебаний (набор коэффициентов при разложении).

-если эти два сигнала ортогональны по энергии, то они ортогональны по мощности (но наоборот это условие выполняется необязательно).

-если эти два сигнала ортогональны по энергии, то они ортогональны по мощности (но наоборот это условие выполняется необязательно).

Это выражение справедливо, когда число членов ряда бесконечно, в этом случае говорят, что энергия колеблется.

Энергия  -это сумма элементарных энергий (то же самое и для мощностей).

-это сумма элементарных энергий (то же самое и для мощностей).

Функция  задана на конечном интервале, а сумма энергий – на бесконечном интервале. Интересно, что на конечном интервале функция дает бесконечный спектр, а на бесконечном наоборот.

задана на конечном интервале, а сумма энергий – на бесконечном интервале. Интересно, что на конечном интервале функция дает бесконечный спектр, а на бесконечном наоборот.

Выражение называется равенством Парсеваля. На практике ограничиваются конечным числом  , но тогда равенство не выполняется.

, но тогда равенство не выполняется.

Можно попробовать среднеквадратическое:

Для нашей дисциплины мы будем ограничиваться тремя функциями:  . Таким образом получим разложение называемое, “ ряд Фурье”.

. Таким образом получим разложение называемое, “ ряд Фурье”.

Если выбрать  , то получим ряд Котельникова, т.е. разложение по временным характеристикам.

, то получим ряд Котельникова, т.е. разложение по временным характеристикам.

В основе представления сигналов лежит ортогональное разложение.

Ортогональные это такие функции, которые не имеют взаимной энергии, мощности (они меняются во времени) и коэффициент корреляции которых равен нулю.

2014-02-24

2014-02-24 756

756