Временная форма

Формы представления детерминированных сигналов.

Сообщение как случайный процесс

Лекция 1. Сигнал, информация и сообщение.

Цель лекции: ознакомление с основными понятиями информации, сообщении, сигналов и энтропией информации.

Содержание:

а) сообщение как случайный процесс;

б) формы представления детерминированных сигналов;

в) мера Хартли. Количественная оценка информации;

г) энтропия как мера неопределенности выбора;

д) связь энтропии Шеннона с энтропией Больцмана.

Главное отличие случайных сигналов от детерминированных состоит в том, что после наблюдения их на конечном отрезке времени tн нельзя предсказать их будущее. Все случайные сигналы являются непредсказуемыми. Таким образом, для случайных сигналов нельзя подобрать математическую формулу, по которому можно было бы рассчитать их мгновенные значения. Изменением основных закономерностей случайных сигналов занимается теория вероятностей, нахождение таких характеристик случайных явлений, которые были бы неслучайными и позволяли проводить математические расчеты случайных явлений. Исследование осуществляется статистическими методами.

Случайный процесс Х(t)- это такая функция времени t, значение которой при любом фиксированном значении аргумента t является случайной величиной. Из этого определения следует, что если будет производиться наблюдение изменения во времени любой случайной величины Х, то это уже будет случайный процесс Х(t). Гармонический сигнал,у которого хотя бы один из параметров -случайная величина, также является случайным процессом.

Пусть ξ(t) есть случайный процесс. В некоторый фиксированный момент времени t1 различные реализации процесса будут иметь различные значения ξ1(t1), ξ2(t1),…, ξn(t1). Значение ξ(t1) является случайной величиной.

Одномерная плотность вероятности случайного процесса {ξk(t)} для

t= t1:. (1.1)

Двумерная плотность вероятности случайного процесса:

. (1.2)

Произведение выражает вероятность того, что в момент времени t1 функция ξ(t) находится в интервале между х1 и, а в момент времени t2 - в интервале между х2 и. Аналогично определяются трехмерный, четырехмерный и т.д. законы распределения. Наиболее полной характеристикой случайного процесса является n – мерный закон распределения, т.е. распределение значения ξ(t) для n произвольно выбранных моментов времени.

. (1.3)

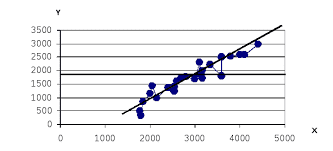

В зависимости от структуры информационных параметров, сигналы могут быть:

- непрерывные (аналоговые)

- дискретные

- дискретные-непрерывные

.

2014-02-24

2014-02-24 945

945