Объединением называются совместные опыты со взаимозависимыми исходами. Пример объединения – действие источника и приёмника сигналов в канале с помехами, если заданы вероятностные характеристики источника, приёмника и процесса передачи сигналов.

Источник производит сигнал х 1, х 2, … хi,… хm, приёмник принимает y 1, y 2, … yi,… ym при этом заданы распределения безусловных вероятностей p (х 1), p (х 2), … p (хi),… p (хm), а также условных вероятностей yj / xi, xi / yj.

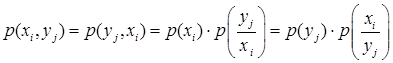

Как известно, безусловные и условные вероятности в совместных опытах связаны выражением

(1.45)

(1.45)

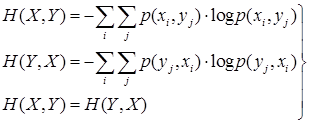

На основе этого энтропия объединения

(1.46)

(1.46)

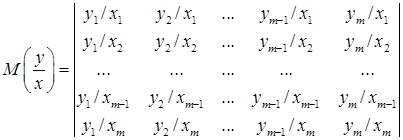

Действие помех приводит к тому, что передавая сигнал хi, в последовательности будет получать разные сигналы yj, что и отражается канальной матрицей.

Задавая качественные признаки сигналов (частоту, фазу и др.) в соответствии с характеристиками помех обеспечивают наибольшие значения условных вероятностей на главной диагонали матрицы, что и обеспечивает возможность передачи информации по каналу.

(1.47)

(1.47)

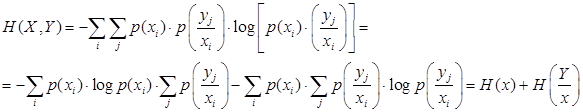

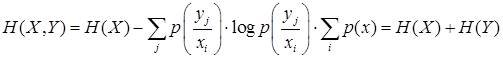

С учётом (1.45) получим

(1.48)

(1.48)

В преобразованиях (1.48) использованы замены двойных сумм вложенными, также тот факт, что сумма условных вероятностей

(1.49)

(1.49)

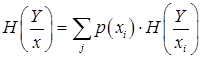

В выражении (1.48) первое слагаемое – это энтропия источника Н (X), а Н (Y/X) – это средняя условная энтропия – мера неопределённости того, какой ансамбль принятых сигналов соответствует ансамблю переданных. Эта энтропия складывается из частных условных энтропий

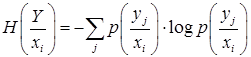

(1.50)

(1.50)

путём их усреднения с учётом распределения безусловных вероятностей p(xi)

(1.51)

(1.51)

Частная условная энтропия – мера неопределённости принятого ансамбля относительно переданного сигнала xi

На основании двойственности зависимости (1.45) можно записать

H (Y,X) = H (Y) + H (X/Y) (1.52)

Условные вероятности p (yj/xi) могут принимать граничные значения p (yj/xi) = 1, если принятые сигналы такие же, как и переданные и p (yj/xi) = p (yj), т.е. какая-либо связь между переданными и принятыми сигналами отсутствует.

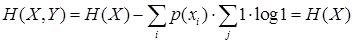

В первом случае

(1.53)

(1.53)

или H (Y,X) = H (Y) H (X) = H (Y)

Во втором

т.к.  (1.54)

(1.54)

Из (1.54) следует, что энтропия объединения здесь достигает максимума, а передача информации от источника к приёмнику отсутствует.

2014-02-12

2014-02-12 3448

3448