1. Вначале исследуем энтропию двоичного источника, который производит поток взаимонезависимых сигналов 0, 1 с безусловными вероятностями р 0, p 1.

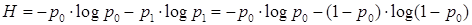

При граничных значениях p 1 = 0 (p 0 = 1 – 0 = 1) и p 1 = 1 (p 0 = 1 – 1 = 0) в соответствии со свойствами частной энтропии энтропия источника равна нулю. Так как эта величина положительна, то при промежуточных значениях вероятностей p 0, p 1 оно будет иметь экстремум. Среднее значение энтропии на сигнал здесь

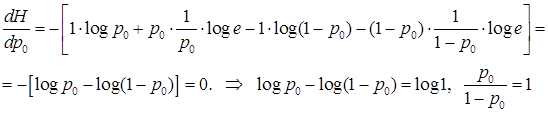

Возьмём производную  и приравняем её нулю:

и приравняем её нулю:

и экстремум имеет место при

, т.е. тогда, когда сигналы равновероятны.

, т.е. тогда, когда сигналы равновероятны.

Величина энтропии в точке экстремума

бит/сигнал

бит/сигнал

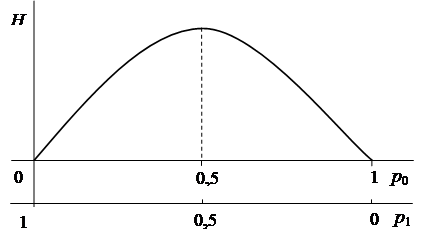

Полученные результаты в графической форме представлены на рис. 1.5.

|

Рис. 1.5

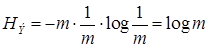

Если m >2, максимум энтропии источника также будет при условии, что сигналы равновероятны и взаимозависимы.

При этом  и согласно (…)

и согласно (…)

(1.61)

(1.61)

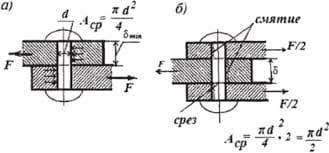

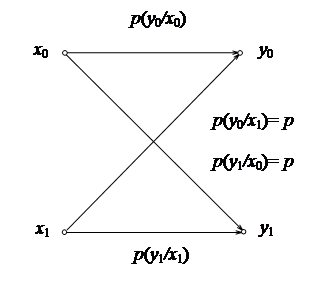

2. Симметричным называется канал, для которого условные вероятности трансформаций сигналов одинаковы

|

и

и  (1.62)

(1.62) Рис 1.6

Тогда термин «канал без памяти» обозначает то, что принятый сигнал зависит только от переданных на кануне (по аналогии с эргодическим источником при r = 1) и не зависит от переданных ранее.

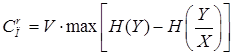

Исследуем условия реализации пропускной способности такого канала и воспользуемся для этой цели выражением

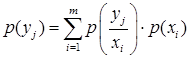

Исследуем зависимости H(Y) и H(Y/X) от вероятностных характеристик источника. Теория вероятностей устанавливает здесь следующее соотношение

(1.63)

(1.63)

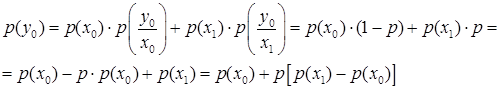

В нашем случае безусловная вероятность принятого сигнала 0

(1.64)

(1.64)

Источник производит максимум информации, если p (x 1) = p (x 0). Это приводит к тому, что в этом случае p (y 0) = p (x 0), p (y 1) = p (x 1), а следовательно здесь и энтропия H(Y) достигает максимума.

Условная энтропия согласно H (Y/X) = –p

2014-02-12

2014-02-12 1054

1054