Термин "регрессия" (лат. - "regression" - отступление, возврат к чему-либо) введен английским психологом и антропологом Ф.Гальтпном и связан только со спецификой одного из первых конкретных примеров, в котором это понятие было использовано.

Обрабатывая статистические данные в связи с вопросом о наследственности роста, Ф.Гальтон нашел, что если отцы отклоняются от среднего роста всех отцов на x дюймов, то их сыновья отклоняются от среднего роста всех сыновей меньше, чем на x дюймов. Выявленная тенденция была названа «регрессией к среднему состоянию».

Рассмотрим основные понятия регрессионного анализа

1.Результирующая (зависимая, эндогенная) переменная у, которая выступает в роли функции, значения которой определяются значениями аргументов. Переменная у всегда случайна.

2. Объясняющие (предиктивные, экзогенные) переменные Х =(х1, х2,…,хp)^T, которые поддаются регистрации, описывают условия функционирования изучаемой реальной экономической системы и в существенной мере определяющие процесс формирования значений результирующих признаков.

3. Функция регрессии у по Х =(х1, х2,…,хp)^T, математически записывается в виде

f(X*)=E(y|X=X*) или f(X)=E(y|X)

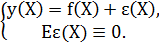

4. Уравнение регрессионной связи.

Математически записывается в виде.

5. Измеритель степени тесноты статической связи между у и Х

Универсальной характеристикой степени тесноты статической связи между у и Х является коэффициент детерминации К(у, Х), который совпадает с квадратом множественного коэффициента корреляции R^2y.X при исследовании линейных моделей.

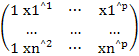

6. Исходные статистические данные, математически записывается в виде

X=

матрица размера n*(p+1),составленная из наблюдаемых значений объясняющих переменных, и Y=(y1,y2,…,yn)^T, матрица размером n*1

2015-05-18

2015-05-18 249

249