МЕТОДИЧЕСКИЕ УКАЗАНИЯ

Лабораторная работа 1

ОСНОВНЫЕ ХАРАКТЕРИСТИКИ И ЭКСПЕРИМЕНТАЛЬНЫЙ АНАЛИЗ

СЛУЧАЙНЫХ ВЕЛИЧИН

Цель работы: — изучение основных понятий теории вероятностей, ознакомление с основными характеристиками случайных величин и возможными способами их экспериментального определения.

Задание: 1. Изучить методические указания к лабораторной работе и материалы

лекций по данной теме.

2. Ознакомится с техническим описанием и принципом работы лабораторного стенда.

3. Выполнить задания (1,2) и провести обработку экспериментальных данных.

4. Оформить отчет о проделанной работе.

При подготовке к выполнению лабораторной работы необходимо изучить элементы теории вероятностей (основные понятия теории вероятностей, ознакомится с основными характеристиками случайных величин) и возможные способы экспериментального определения случайных величин.

Случайной величиной называют такую величину, значения которой изменяются при повторении опытов некоторым, заранее не предсказуемым образом. В отличие от неслучайных, детерминированных величин для случайной величины нельзя заранее точно сказать, какое конкретное значение она примет в определенных условиях, а можно только указать закон ее распределения. Закон распределения считается заданным, если: 1) указано множество возможных значений случайной величины; 2) указан способ количественного определения вероятности попадания случайной величины в любую область множества возможных значений.

|

|

|

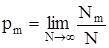

Вероятность попадания в заданную область может быть определена следующим образом:

. (1.1)

. (1.1)

Здесь Nm — количество наблюдений случайной величины, оказавшихся в заданной области; N — общее число наблюдений (частотное определение вероятности).

Аналитическими выражениями законов распределения случайных величин являются функции распределения вероятностей — интегральная и дифференциальная.

Интегральная функция распределения F (х) случайной величины Х показывает вероятность того, что случайная величина не превышает некоторого заданного или текущего значения х,т.е. F (x) =P { X Ј x }. Через Р обычно обозначают оператор вероятности, а через р — конкретную величину вероятности. Следовательно, вероятность того, что значение случайной величины Х заключено между х 1 и х 2, равна разности значений функции распределения, вычисленных в этих двух точках:

P { x 1 < X Ј x 2} = F (x 2) - F (x 1). (1.2)

Аналогично,

P { X > x } = 1 - F (x). (1.3)

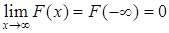

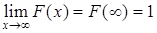

Интегральная функция распределения случайной величины Х обладает следующими свойствами:

1)  ; 2)

; 2)  ;

;

3) F (x) і 0 для всех х; 4) F (x 2) і F (x 1), если х 2 > х 1.

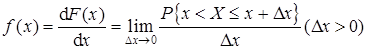

Если функция F (х) дифференцируема для всех значений случайной величины X, то закон распределения вероятностей может быть выражен в аналитической форме также с помощью дифференциальной функции распределения вероятностей:

|

|

|

. (1.4)

. (1.4)

Таким образом, значение функции f (x) приближенно равно отношению вероятности попадания случайной величины в интервал (х, х+ D х) к длине D x этого интервала, когда D х — бесконечно малая величина. Поэтому функцию f (х) называют также функцией платности распределения вероятностей (или короче — функцией плотности вероятности).

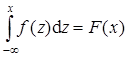

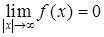

Отметим основные свойства функции; f (х):

1) f(x) і 0; 2)  ;

;

3) ; 4)

; 4)

(z — переменная интегрирования).

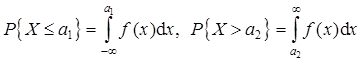

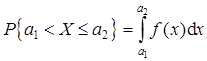

С помощью дифференциальной функции распределения вычисляется вероятность нахождения случайной величины в любой области из множества ее возможных значений. В частности,

,

,

. (1.5)

. (1.5)

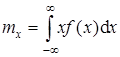

Как интегральная, так и дифференциальная функции распределения являются исчерпывающими, вероятностными характеристиками случайной величины. Однако некоторые основные свойства случайных величин могут быть описаны более просто с помощью определенных числовых параметров. Наибольшую роль среди них на практике играют два параметра, характеризующие центр рассеяния (центр распределения) случайной величины и степень ее рассеяния вокруг этого центра. Наиболее распространенной характеристикой центра распределения является математическое ожидание тх случайной величины Х (часто называемое также генеральным средним значением):

. (1.6)

. (1.6)

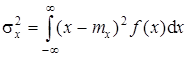

Степень рассеяния случайной величины Х относительно тх может быть охарактеризована с помощью генеральной дисперсии  :

:

. (1.7)

. (1.7)

Если f (х) все в большей степени концентрируется вблизи mх,то значения  уменьшаются. Если же имеются весьма удаленные от тх значения случайной величины Х и для них f (х) не слишком мала, то дисперсия

уменьшаются. Если же имеются весьма удаленные от тх значения случайной величины Х и для них f (х) не слишком мала, то дисперсия  увеличивается. Квадратный корень из дисперсии

увеличивается. Квадратный корень из дисперсии  называется средним квадратическим отклонением s х.

называется средним квадратическим отклонением s х.

Зачастую для описания практической ситуации оказывается необходимым использование одновременно нескольких (в простейшем случае — двух) случайных величин. Для задания вероятностных свойств двух случайных величин X, Y используются двумерные (совместные) функции распределения вероятностей: интегральная F (х, у) и дифференциальная f (x, у). Функция F (x, у), характеризующая вероятность того, что первая случайная величина принимает некоторое значение, меньшее или равное х, а вторая — значение, меньшее или равное у, называется интегральной функцией совместного распределения двух случайных величин:

F(x, у) = Р{Х Ј х; Y Ј y}. (1.8)

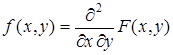

Как и для одной непрерывной случайной величины, если функция F (х, у) достаточно гладкая, то ее можно продифференцировать, в результате чего получится двумерная дифференциальная функция распределения вероятностей (двумерная плотность вероятности):

. (1.9)

. (1.9)

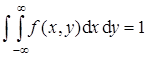

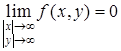

Функция f (x, у) обладает следующими свойствами:

1) f (x, y) і 0; 2)  ;

;

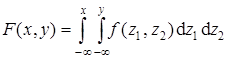

3)  ; 4)

; 4)

(z 1, z 2 — переменные интегрирования).

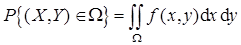

Вероятность того, что случайные величины X, Y одновременно попадут в некоторую произвольную область W составляет

. (1.10)

. (1.10)

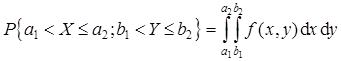

В частности,

. (1.11)

. (1.11)

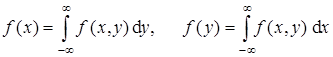

По известной двумерной плотности f (x, у) легко найти частные (одномерные) функции распределения f (x), f (у) каждой случайной величины:

. (1.12)

. (1.12)

Две случайные величины Х и Y называются независимыми, если

f (x, y) = f (x) f (y). (1.13)

Как и в одномерном случае, основные свойства двумерной совокупности величин X, Y могут быть охарактеризованы с помощью ряда числовых параметров. При этом в качестве наиболее употребительных параметров, описывающих поведение каждой из случайных величин в отдельности, как и выше, используются математическое ожидание и дисперсия соответствующей случайной величины: тх, ту,  ,

,  . Кроме подобного рода параметров для двумерной совокупности могут быть построены параметры, характеризующие степень взаимозависимости переменных Х и Y. Простейшими из них являются ковариация двух случайных величин (называемая также корреляционным моментом)

. Кроме подобного рода параметров для двумерной совокупности могут быть построены параметры, характеризующие степень взаимозависимости переменных Х и Y. Простейшими из них являются ковариация двух случайных величин (называемая также корреляционным моментом)

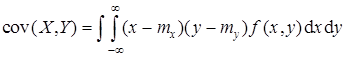

|

|

|

, (1.14)

, (1.14)

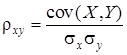

а также нормированный показатель связи — коэффициент корреляции

. (1.15)

. (1.15)

По своему физическому смыслу коэффициент корреляции является далеко не исчерпывающей характеристикой статистической связи, характеризуя лишь степень линейной зависимости между Х и Y. Коэффициент корреляции меняется в пределах -1 Ј r xy Ј 1. Если r xy = 1, то случайные величины полностью положительно коррелированы, т.е. у = а 0 + а 1 х, где а 0 и а 1 — постоянные, причем а 1 > 0. Если же r xy = -1, то случайные величины полностью отрицательно, коррелированы, т.е. у = а 0 - а 1 х. Если r xy = 0, то говорят, что случайные величины Х и Y не коррелированы: а 1 = 0. В том случае, когда Х и Y — независимые случайные величины, для них r xy = 0; следовательно, они и не коррелированы. Обратное утверждение в общем случае неверно: Х и Y могут быть связаны даже функционально и все же иметь нулевой коэффициент корреляции (при этом, конечно, функциональная связь должна быть нелинейной).

Все описанные выше функции и связанные с ними параметры являются теоретическими, характеризующими определенные свойства изучаемого объекта. На практике почти всегда эти характеристики неизвестны и возникает задача экспериментального (эмпирического) определения тех или иных характеристик случайных величин на основе наблюдений.

2014-02-10

2014-02-10 853

853