Цифровий автомат можна визначити як перетворювач інформації. Усі процеси в ЕОМ, обчислювальних комплексах і системах пов'язані з перетворенням, зберіганням і передачею інформації.

Інформація завжди представляється у вигляді повідомлення. Елементарна одиниця повідомлень - символ. Символи, зібрані в групи, - слова. Повідомлення, оформлене у вигляді слів або окремих символів, завжди передається в матеріально-енергетичній формі (електричний, світловий, звуковий сигнали і т. д.). Одним з найважливіших питань теорії інформації є встановлення міри кількості і якості інформації.

Найбільшого ширення набула двійкова міра Хартлі, відповідно до якої вводяться поняття глибини m і довжини п повідомлення.

Глибина m повідомлення - кількість символів (елементів), прийнятих для представлення інформації. У кожен момент часу реалізується тільки один який-небудь символ.

Довжина п повідомлення - кількість позицій, необхідних і достатніх для представлення повідомлення заданої величини.

При заданій глибині і довжині кількість інформації повідомлення, можна представити:

N =m n

Число N, а отже, кількість інформації знаходяться в експоненціальній залежності від довжини п повідомлення і тому його незручно використовувати як міру кількості інформації.

Поняття глибини числа можна трансформувати в поняття основи системи числення. Величина N не зручна для оцінки інформаційної ємності. Тому вводиться логарифмічна міра, яка дозволяє обчислювати кількість інформації:

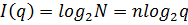

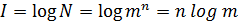

Як міру кількості інформації Р. Хартлі запропонував використовувати величину I, що обчислюється співвідношенням:

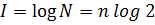

Якщо для кодування інформації використовуються двійкові символи 0 і 1, то m = 2 і співвідношення набуде вигляду:

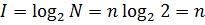

В цьому випадку зручно як основу логарифма узяти число 2 (основу системи числення) і тоді:

При n = 1, I = 1 і цю кількість інформації прийнято вважати одиницею кількості інформації та називати бітом. Передача повідомлення довжиною n = 1 еквівалентна вибору одного з двох можливих рівноімовірних повідомлень. Одне з них кодується нулем, інше - одиницею.

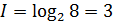

Приклад. Яку кількість інформації треба витратити для вибору однієї з 8 рівноімовірних букв?

Фактично передається 8 повідомлень тобто N = 8. Тому

Отримана величина I = 3 є довжиною повідомлення при двійковому кодуванні букви.

У статистичній теорії інформації, коли приймачем інформації є цифровий автомат, класичним підходом до оцінки кількості інформації є імовірнісний.

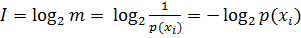

При імовірнісному підході інформація розглядається як повідомлення про результат випадкових подій, а кількість інформації ставиться в залежність від апріорної вірогідності цих подій.

Отже, 1 біт інформації відповідає одній елементарній події, яка може статися або не статися. Така міра кількості інформації зручна тим, що вона забезпечує можливість оперувати мірою як числом.

Якщо маємо алфавіт з m букв x1, …, xm, а вірогідність вибору будь-якої букви свідомо однакова і дорівнює

Тоді

Таким чином кількість інформації про вибір тієї або іншої букви тим більше, чим менше вірогідність вибору букви.

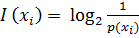

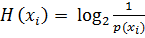

Вираз  характеризує кількість інформації, що міститься в повідомленні xi. Воно характеризує також апріорну невизначеність цього повідомлення. У зв'язку з цим вказане вираження може бути використане для кількісної оцінки невизначеності повідомлення

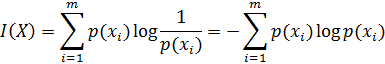

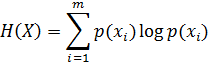

характеризує кількість інформації, що міститься в повідомленні xi. Воно характеризує також апріорну невизначеність цього повідомлення. У зв'язку з цим вказане вираження може бути використане для кількісної оцінки невизначеності повідомлення  , яка називається приватною ентропією. Кількість інформації і невизначеність для усієї сукупності випадкових повідомлень X можна отримати усереднюванням по усіх подіях:

, яка називається приватною ентропією. Кількість інформації і невизначеність для усієї сукупності випадкових повідомлень X можна отримати усереднюванням по усіх подіях:

Залежності для I(X) і Н(X) виражають відповідно середню кількість інформації і ентропії на одне повідомлення.

Незважаючи на збіг виразів для I(X) і Н(X), поняття кількість інформації і ентропія принципово різні. Н(X), що виражає середню невизначеність стану джерела повідомлень може бути вичислена апріорі, тобто, до отримання повідомлення. Величина I(X) визначається апостеріорно, після отримання повідомлень. Н(X) є міра недоліку інформації про стан системи. Зі вступом інформації про стан системи ентропія останньої знижується. Збіг виразів для I(X) і Н(X) свідчить лише про те, що кількість отримуваної інформації дорівнює чисельно ентропії, яка мала місце відносно джерела повідомлень.

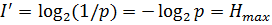

Кількість інформації тільки тоді дорівнює ентропії, коли невизначеність ситуації знімається повністю. Найбільше кількість інформації виходить тоді, коли вірогідність усіх подій однакова і при цьому знімається невизначеність. По Хартлі це максимальна кількість інформації оцінюється як

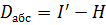

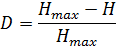

Абсолютна надмірність інформації

а відносна надмірність визначається з вираження

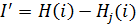

При передачі інформації через канал з перешкодами повідомлення спотворюються і на приймальній стороні немає упевненості в тому, що прийнято саме те повідомлення, яке передавалося. Отже, повідомлення недостовірне, вірогідність правильності його після прийому не дорівнює одиниці. В цьому випадку кількість отримуваної інформації зменшується на величину невизначеності, що вноситься перешкодами, тобто обчислюється як різниця ентропії повідомлення до і після прийому:

де H(i) - ентропія джерела повідомлень;

- ентропія повідомлень на приймальній стороні.

- ентропія повідомлень на приймальній стороні.

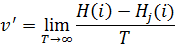

Таким чином, швидкість передачі по каналу зв'язку з перешкодами

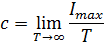

Пропускною спроможністю каналу з шумами називається максимальна швидкість передачі інформації за умови, що канал зв'язку без перешкод узгоджений з джерелом інформації:

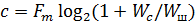

Якщо ентропія джерела інформації не перевищує пропускної спроможності каналу (𝐻≤𝑐), то існує код, що забезпечує передачу інформації через канал з перешкодами із скільки завгодно малою частотою помилок або скільки завгодно малою недостовірністю. Пропускна спроможність каналу зв'язку при обмеженій середній потужності аналогового сигналу:

де Fm - смуга частот каналу (Гц); Wc - середня потужність сигналу; Wш - середня потужність перешкод (рівномірний спектр) з нормальним законом розподілу амплітуд в смузі частот каналу зв'язку.

Отже, можна передавати інформацію по каналу з перешкодами без помилок, якщо швидкість передачі інформації менше пропускної спроможності каналу. Для швидкості v>c при будь-якій системі кодування частота помилок набуває кінцевого значення, причому воно росте із збільшенням значення v. Для каналу з дуже високим рівнем шумів (Wш>>Wc) максимальна швидкість передачі близька до нуля.

2015-07-14

2015-07-14 542

542