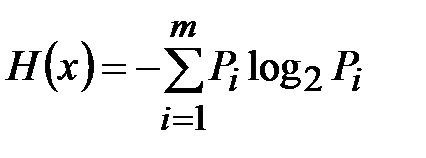

Количество информации в любом сечении тракта РТС определяется разностью начального и конечного незнания значения передаваемого сигнала. Незнание количественно характеризуется энтропией. Начальная энтропия определяется распределением параметра и погрешности, вносимой оцениваемым участком тракта РТС. Закон распределения величины х лежит в основе вычисления ее энтропии:

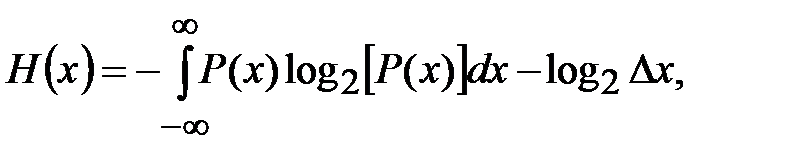

, (4.1)

, (4.1)

где Pi – вероятности появления x = xi.

Если х является непрерывной переменной с плотностью вероятностей Р (х), то характер x существенно не изменяется, если ввести дискретные х 1, х 2,..., хm, отстоящие друг от друга на равные расстояния Δ х и имеющие вероятности

Рi = Р (хi)Δ х. Замена будет тем более точной, чем меньше Δ х. Тогда энтропия непрерывного процесса определяется как

где величина log2Δ х зависит от выбранного интервала разбиения Δ х. В технических расчетах энтропия, как правило, используется для оценки количества информации, определяемого разностью априорной и апостериорной энтропии.

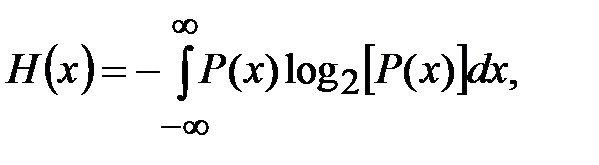

При вычислении разности величина log2Δ х, содержащаяся в вычитаемом и уменьшаемом, исчезает. Поэтому эту величину очень часто исключают из рассмотрения, полагая:

(4.2)

(4.2)

Очевидно влияние закона распределения на энтропию. Поэтому для каждого закона распределения Р (х) нужно производить вычисление Н (х), что в инженерной практике оказывается неудобным, а часто и ненужным. В связи с этим находит применение вычисление энтропии по простым формулам непосредственно через дисперсию случайной величины. Рассмотрим методику такого вычисления.

Однозначного соответствия между дисперсией случайной величины и ее энтропией не существует. Это можно показать на следующем примере.

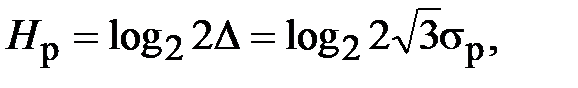

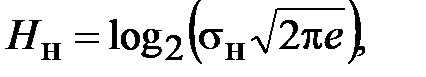

Рассмотрим две погрешности, одна из которых распределена равномерно в интервале ±Δ с дисперсией  , а вторая – нормально с дисперсией

, а вторая – нормально с дисперсией  . Вычисленные по формуле (4.2), энтропии этих погрешностей соответственно равны:

. Вычисленные по формуле (4.2), энтропии этих погрешностей соответственно равны:

где e – основание натурального логарифма.

В этих формулах под знаком логарифма стоит произведение некоторого коэффициента, определяемого видом закона распределения, и дисперсии случайной величины. Это и является исходной предпосылкой для расчета энтропии:

Н = 2 K эσ,

где K э – энтропийный коэффициент.

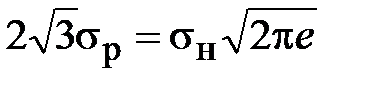

Сравнение энтропий нормального и равномерного распределения показывает, что с информационной точки зрения они эквивалентны, если:

.

.

Таким образом, нормально распределенная погрешность вносит в измерение большую неопределенность, чем равномерно распределенная при той же дисперсии. Мало того, можно сказать, что из всех возможных распределений нормальное дает наибольшую энтропию. В применении к помехе потребуется меньшая мощность, чем при любом другом распределении. С другой стороны, для произвольно распределенной помехи характерно то, что лишь часть ее мощности идет на эффективное дезинформирующее действие.

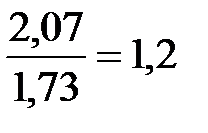

Значение энтропийного коэффициента равномерного и нормального распределений отличается в  раза. При вычислении энтропии этих распределений разница составит log21,2 = 0,26 дв. ед. Если значение энтропии (или информации) составляет значительную величину (более 10 бит), то замена одного распределения другим не приводит к большой погрешности расчетов. Эти рассуждения применимы также и в том случае, когда распределение погрешностей одномодальное и не имеет резкого выброса. Например, экспоненциальное распределение имеет K э = 1,95.

раза. При вычислении энтропии этих распределений разница составит log21,2 = 0,26 дв. ед. Если значение энтропии (или информации) составляет значительную величину (более 10 бит), то замена одного распределения другим не приводит к большой погрешности расчетов. Эти рассуждения применимы также и в том случае, когда распределение погрешностей одномодальное и не имеет резкого выброса. Например, экспоненциальное распределение имеет K э = 1,95.

На практике при анализе прохождения сигнала в РТС встречается задача суммирования большого числа погрешностей, возникающих в процессе передачи. Если порядок погрешностей, вносимых на различных этапах передачи, одинаков, то распределение результирующей ошибки согласно предельной теореме теории вероятности стремится к нормальному уже при небольшом числе составляющих. В этом случае без дополнительного анализа с достаточной для практики точностью можно принимать K э = 2…2,07.

Понятие энтропийного значения может использоваться не только применительно к погрешности, но и к любой случайной величине. Это положение используется для расчета количества информации, получаемой в результате измерения величины параметра.

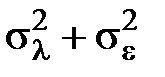

Если в некотором сечении тракта РТС сигнал может быть представлен суммой статистически независимых значений параметра λ и погрешности ε, то дисперсия распределения этого сигнала равна сумме  , где

, где  – дисперсия параметра, а

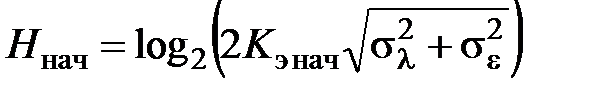

– дисперсия параметра, а  – дисперсия погрешности. Начальная или априорная энтропия

– дисперсия погрешности. Начальная или априорная энтропия

,

,

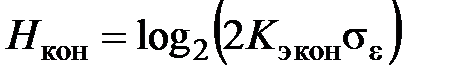

где K э нач – энтропийный коэффициент распределения сигнала и погрешности. Конечная или апостериорная энтропия определяется распределением погрешности

,

,

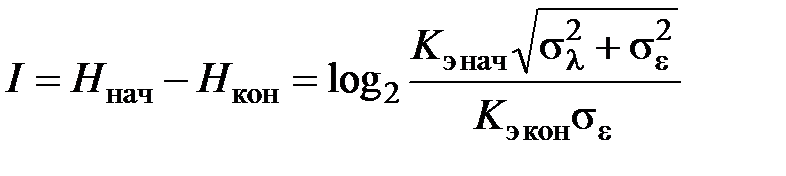

где K э кон – энтропийный коэффициент распределения погрешности. Количество информации, получаемое в результате измерения:

. (4.3)

. (4.3)

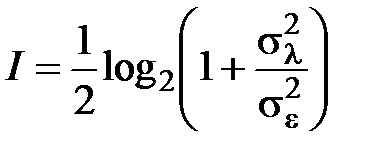

Если K э нач ≈ K э кон, то получаемое в результате измерения количество информации

. (4.4)

. (4.4)

Формулы (4.3) и (4.4) позволяют рассчитать количество информации, получаемое в результате однократного измерения параметра. Если рассматривать ряд последовательных измерений, то приведенные формулы оказываются неточными, так как не учитывают наличие корреляционных связей между отсчетами. Эти связи уменьшают количество информации, содержащейся в последующих отсчетах, так как начальная неопределенность существенно уменьшается из-за того, что по предыдущим отсчетам можно предсказать последующие.

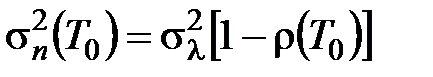

Если коэффициент корреляции отсчетов ρ(Т 0), то по предшествующему можно предсказать следующий отсчет с дисперсией предсказания

,

,

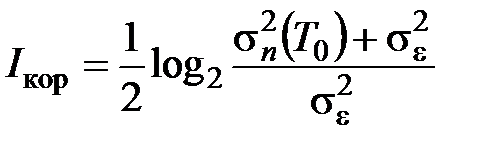

которая определяет начальную энтропию. Поэтому количество информации, которое дает последующий коррелированный с предыдущим отсчет

,

,

так как σ n <<σλ, то I кор < I.

2020-05-13

2020-05-13 147

147