Самоорганизующиеся нейронные сети обучаются без учителя. Они способны адаптироваться к входным данным, используя содержащиеся в этих данных зависимости. Такие сети используются для нахождения более компактного описания данных (сжатия), кластеризации, выделения признаков.

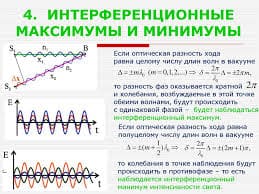

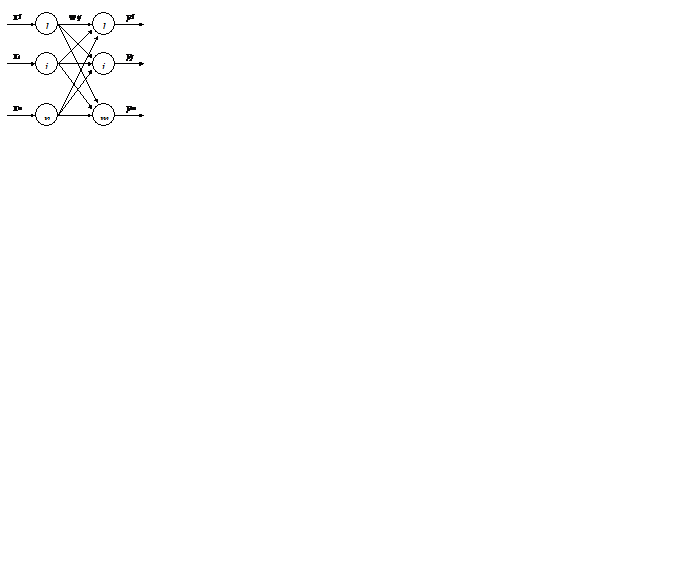

Конкурентная сеть является простейшей самоорганизующейся нейронной сетью (рис. 4.1).

Рис. 4.1. Конкурентная нейронная сеть

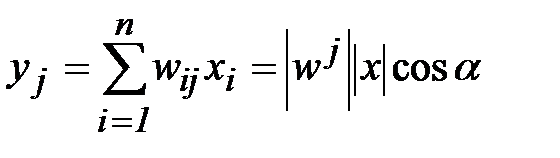

Первый слой является распределительным. Нейроны второго слоя функционируют по формуле

, (4.1)

, (4.1)

где x = (x1, x2,…,xi,…,xn) – входной вектор; w j=(w1j, w2j,…,wij,…,wnj) – вектор весовых коэффициентов нейрона, а | x | и | w j | – их модули, a – угол между ними.

Обучение. При обучении нейронной сети при подаче каждого входного вектора определяется нейрон-победитель, для которого значение (4.1) максимально. Для этого нейрона синаптические связи усиливаются по формуле

wij(t+1)=wij(t)+b(xi-wij(t)), (4.2)

где b – скорость обучения.

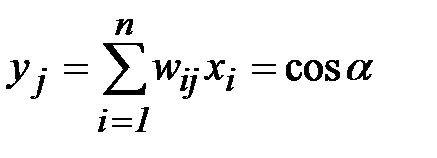

Смысл этой формулы в том, что вектор весовых коэффициентов нейрона - победителя «поворачивается» в сторону входного вектора, тем самым активность нейрона усиливается. Удобно работать с нормированными входными и весовыми векторами, когда их модуль равен 1. Нормировка уравнивает шансы в конкуренции нейронов с разным модулем вектора весовых коэффициентов. Выражение (4.1) для нормированных векторов будет выглядеть как

, (4.3)

, (4.3)

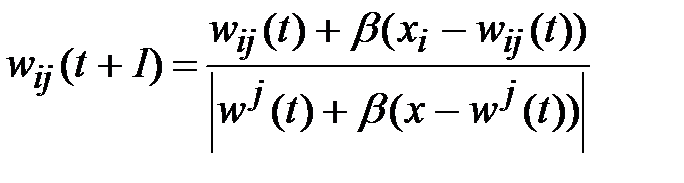

а выражение (4.2) как

. (4.4)

. (4.4)

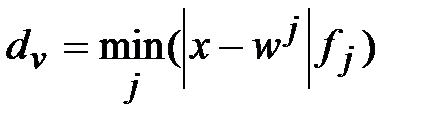

Случайное начальное распределение весовых коэффициентов может привести к тому, что некоторые нейроны никогда не станут победителями, так как их весовые векторы окажутся удаленными от всех входных векторов. Существует ряд модификаций алгоритма обучения, позволяющих устранить этот недостаток. Хорошие результаты на практике показало частотно–зависимое конкурентное обучение. Согласно нему, нейрон-победитель определяется по минимуму произведения евклидового расстояния между входным и весовым вектором и количеством побед данного нейрона fj:

. (4.5)

. (4.5)

Шансы нейрона на победу уменьшаются с количеством побед, что дает преимущество другим нейронам.

Конкурентное обучение продолжается до тех пор, пока максимум евклидового расстояния между любым входным вектором и соответствующим ему вектором весов нейрона-победителя не достигнет заданного малого значения.

Конкурентная сеть позволяет разбить входную выборку нормированных векторов на m (количество выходных нейронов сети) кластеров, расположенных на поверхности гиперсферы в пространстве признаков единичного радиуса. Входные векторы, приводящие к победе одного и того же нейрона, относят к одному кластеру.

Кохонен [5-7] предложил внести в правило конкурентного обучения (4.2) информацию о расположении нейронов в выходном слое. Для этого нейроны упорядочиваются в одномерные или двухмерные решетки. Вводится функция, корректирующая изменение весов в зависимости от расстояния до нейрона–победителя; h(t,k,j) – сила влияния между нейроном–победителем k и нейроном j в момент времени t. Для j=k эта функция всегда равна 1 и уменьшается с ростом расстояния между k и j в решетке. С течением времени радиус влияния обычно сужается. С использованием этой функции веса меняются для всех нейронов сети, а не только для нейрона-победителя:

wij(t+1)=wij(t)+b h(t,k,j)(xi-wij(t)). (4.6)

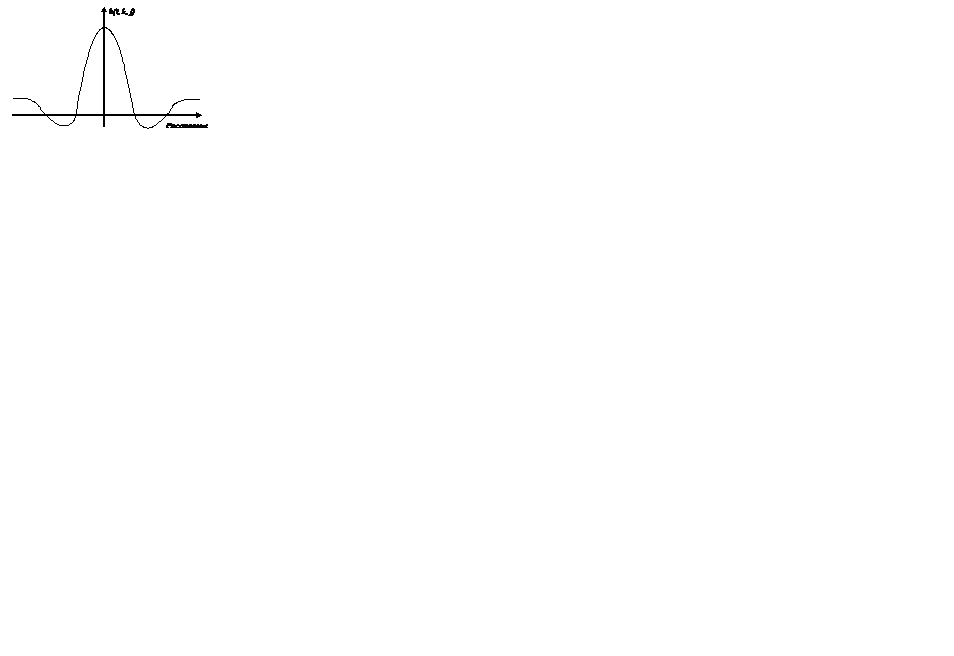

В качестве функции h(t,k,j) может использоваться гауссовый колокол (3.1) с параметром s, зависящим от времени или функция вида «мексиканская шляпа».

Рис. 4.2. Пример функции расстояния в сетях Кохонена

В результате модификации конкурентного обучения сеть Кохонена не только кластеризирует входные примеры, но и упорядочивает их в виде одномерной или двухмерной решетки. Это позволяет получить дополнительную информацию о близости кластеров. Если два кластера проецируются на соседние нейроны решетки, это говорит об их близости в исходном пространстве признаков. Обратное неверно. Из-за уменьшения размерности пространства отношение близости сохраняется только для ограниченного числа кластеров.

2015-04-12

2015-04-12 373

373