|

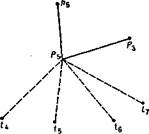

Можно совместить все три графа для всех позиций либо только для одной, и в результате мы получаем ясное представление о конкретной структуре к.-л. данной роли. Так, для роли позиции Рь имеем граф (рис.). Вплетение неформальных отношений в указанную формальную структуру значительно усложнит граф, но зато он будет более точной копией действительности.

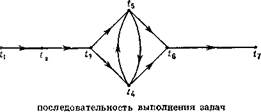

2) Анализ получен

ной модели, выделение

в ней структурных еди

ниц (подсистем) и изу

чение их связей. Таким

способом могут быть вы

делены, напр., подсистемы в крупных орг-циях.

3) Изучение уровней структуры иерархич. орг-ций:

количество уровней, количество связей, идущих из

одного уровня в другой и от одного лица к другому.

На основании этого решаются задачи:

а) количеств, оценки веса (статуса) индивида в иерархич. орг-ции. Одним из возможных вариантов определения статуса является формула:

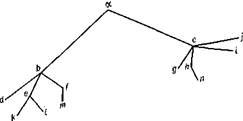

где г (р) — статус нек-рого лица р,к — величина уровня субординации, определяемая как наименьшее количество шагов от данного лица к своему подчиненному, nk — количество лиц на данном уровне к. Напр., в орг-ции, представленной след. графом:

вес а = 1-2+2-7+3-4=28; 6=1-3+2-3=9 и, т. д. См. формулу (1)

б) определение лидера группы. Лидер характеризуется обычно большей по сравнению с другими связанностью с остальными членами группы. Как и в предыдущей задаче, здесь также могут быть использованы различные способы для выделения лидера.

Наиболее простой способ дается формулой: г= *у,

т. е. частное от деления суммы всех дистанций каждого до всех других на сумму дистанций данного индивида до всех других.

4) Анализ эффективности деятельности данной системы, куда входят также такие задачи, как поиски оптимальной структуры орг-ции, повышение сплоченности группы, анализ социальной системы с т. зр.

ее устойчивости; исследование потоков информации (передачи сообщений при решении задач, влияние членов группы друг на друга в процессе сплачивания группы); при помощи Т. г. решают проблему нахождения оптимальной коммуникационной сети.

В применении к Т. г., так же как к любому матема-тич. аппарату, верно утверждение, что осн. принципы решения задачи задаются содержат, теорией (в данном случае социологией).

Лит.: Б е р ж К., Т. г. и ее применение, пер. с франц.,

М., 1962; К е и е н и Д ж., Снелл Д ж., ТомпсонД т.,

Введение в конечную математику, пер. с англ., 2 изд., М.,1963;

Оре О., Графы я их применение, пер. с англ., М., 1965;

Белых О. В., Беляев Э. В., Возможности примене

ния Т. г. в социологии, в сб.: Человек и общество, вып. 1,

[Л.], 1966; Количеств, методы в социологич. исследованиях,

М., 1966; Беляев Э. В., Проблемы социологич. измере

ния, «ВФ», 1967, № 7; Bavelas. Communication patterns in

task oriented groups, в кн.: Lerner D., Lasswell H,

Policy sciences, Stanford, 1951; К e m e n у J. G., Sne!l J.,

Mathematical models in the social sciences, N.Y., 1962; F 1 a-

m e n t C, Applications ot graph theory to group structure,

N.Y., 1963; Oeser О. А., Нага г у Р., Role structures

and description in terms of graph theory, в кн.: В i d d 1 e

В., Thomas E. J.. Role theory: concepts and research,

N. Y., 1966. Э. Беляев. Ленинград.

ТЕОРИЯ ИГР — теория матем. моделей принятия решений в условиях неопределенности, когда принимающий решение субъект («и г р о к») располагает информацией лишь о множестве возможных ситуаций, в одной из к-рых он в действительности находится, о множестве решений («стратег и й»), к-рые он может принять, и о количеств, мере того «выигрыша», к-рый он мог бы получить, выбрав в данной ситуации данную стратегию. Т. и. является естеств. развитием теорий решения экстремальных задач в условиях вероятностной, статистич. неопределенности (когда принимающий решения субъект информирован дополнительно об априорных вероятностях каждой из возможных ситуаций). В частности, в рамках Т. и. естественно рассматривать модели конфликт о в (т. е. явлений, в к-рых участвуют различные стороны, наделенные различными интересами и возможностями выбирать свои стратегии в соответствии с этими интересами). Т.о., моделями Т. и. можно в принципе описывать содержательно весьма разнообразные явления: вопросы спортивных состязаний и экономич. борьбы, военные, правовые и классовые конфликты, борьбу человека с природой, биологич. борьбу за существование и т. д. Все такие модели принято в Т. и. наз. играми. Существенно, что Т. и. моделирует не только антагонистич. конфликты, но и более сложные взаимоотношения сторон — носителей различных интересов. Следует при этом отличать теоретико-игровое понятие антагонизма от философской категории антагонизма. В Т. и. антагонизм понимается более прямолинейно и исчерпывается равенством по величине и противоположностью по знаку выигрышей игроков-антагонистов.

Важная роль понятия информации (см. Теория информации) в Т. и. предопределяет ее тесную связь с кибернетикой, на основании чего Т. и. квалифицируют иногда как раздел кибернетики. Однако в теоре-тич. отношении Т. и. следует скорее считать отраслью математики, а в практическом — определ. уровнем операций исследования.

Матем. описание игры сводится к перечислению всех участвующих в ней игроков, указанию для каждого игрока множества всех его стратегий, а также ч и с-ленного выигрыша, к-рый он получит после того, как все игроки выберут свои стратегии. В результате игра становится формальным объев-т о м, к-рый поддается матем. анализу. При совр. состоянии Т. и. осн. целями этого анализа являются: 1) выработка критериев целесообразности («оптимальности») поведения игроков в тех или иных классах игр, 2) доказательство существования у игроков в та-

ТЕОРИЯ ИГР 209

ких играх оптимальных стратегий, 3) установление важнейших свойств оптимальных стратегий (и в том числе, если это возможно, формул и алгоритмов для их фактич. вычисления). (Нахождение оптимальных стратегий игроков требует использования сложного тех-нич. аппарата совр. математики, а численное их определение обычно осуществляется с помощью быстродействующей электронной техники.)

ких играх оптимальных стратегий, 3) установление важнейших свойств оптимальных стратегий (и в том числе, если это возможно, формул и алгоритмов для их фактич. вычисления). (Нахождение оптимальных стратегий игроков требует использования сложного тех-нич. аппарата совр. математики, а численное их определение обычно осуществляется с помощью быстродействующей электронной техники.)

Для весьма широкого класса игр целесообразным поведением игроков естественно считать их стремление к ситуациям равновесия, т.е. к таким одновременным выборам игроками своих стратегий, что ни для одного из игроков не будет выгодным отклонение от этой ситуации (т. е. односторонняя замена выбранной стратегии иной). Именно ситуации равновесия могут быть предметом договорных отношений между игроками. Поэтому стремление игроков к ситуации равновесия принято называть принципом осуществимости цели. В случае антагонистич. игр принцип осуществимости цели превращается в принцип м а к с и м и и а (стремление максимизировать минимальный выигрыш, т. е. стремление действовать наилучшим образом в наихудших условиях).

Весьма часто игры не имеют ситуаций равновесия, сконструированных из первоначально заданных стратегий игроков. Это, с одной стороны, означает, что в таких играх игроки лишены возможности действовать целесообразно, а с другой — побуждает искать для игроков естеств. дополнительных возможностей поведения. Так, напр., можно вместо достоверного выбора к.-л. стратегии осуществить случайный выбор стратегии (по жребию или даже прибегая к тому или иному из суеверий, находящих тем самым практич. применение, хотя и довольно скромное), к-рый наз. с м е-гп а н н о й стратегией. Оказывается, что в большинстве практически важных случаев из смешанных стратегий удается строить ситуации равновесия. Описанный факт является (открытым в Т. и.!) примером целесообразности введения случайного в процесс принятия решений по воле принимающего решения субъекта. Наоборот, применение смешанных стратегий и др. игроками заставляет предполагать, что принятие решения происходит в случайных условиях с заданными априорными вероятностями. Тем самым, однако, эти вероятности приобретают уже не априорное, а оптимизационное происхождение.

Игры можно классифицировать по различным признакам.

Во-первых, следует выделить коалиционные игры, в к-рых принимающие решения игроки согласно правилам игры объединены в фиксиров. коалиции двух типов: коалиции действий и коалиции интересов. Члены одной коалиции действий могут свободно обмениваться информацией и тем самым принимать полностью согласованные решения. Члены одной коалиции интересов имеют единые интересы, и выигрыши коалиции разделению между игроками не подлежат. Существенным является то, что один и тот же игрок может одновременно быть участником неск. коалиций. Коалиционным играм противостоят бескоалиционные игры, в к-рых каждая коалиция состоит лишь из одного игрока. Т. н. кооперативная теория бескоалиционных игр допускает временные объединения игроков в коалиции в процессе игры с последующим разделением полученного общего выигрыша.

Во-вторых, играм в нормальной форме, в к-рых игроки получают всю предназначенную для них информацию до начала игры, противостоят динамические игры, где информация поступает к игрокам постепенно отд. порциями или даже непрерывным во времени потоком. В соответствии с

этим принятие решений участником игры в нормальной форме является однократным актом, тогда как в динамич. игре принятие решения развертывается в дискретный или непрерывный процесс принятия частичных решений. Ввиду ограниченности памяти игрока (т. е. способности хранить п использовать в процессе игры информацию об обстановке и о собственных прошлых действиях) в динамич. играх рассматриваются также случаи полной или частичной утраты информации. Особенности памяти игрока позволяют в ряде случаев упрощать поиски его оптимальных стратегий. Так как в каналах, подводящих к игрокам информацию, могут быть помехи, а пропускные способности этих каналов ограничены, игрок может в ходе игры получать информацию с искажениями и с запаздыванием. Эти обстоятельства также могут находить отражение в формулировках игр.

В-третьих, для матем. анализа игр существенно количество стратегий игроков. Если каждый игрок имеет конечное число стратегий, то игра наз. конечной, а в противном случае — бесконечной. Переход от конечных к бесконечным играм сопровождается качеств, изменением свойств игры и, в частности, оптимальных стратегий ее участников и требует привлечения существенно более сложного матем. аппарата.

Нахождение оптимальных стратегий игроков в конечных антагонистич. играх в нормальной форме (такие игры обычно наз. матричными) эквивалентно решению общей задачи линейного программирования— важной модели мн. экономич. явлений, как и вообще различных явлений организации. При «экономическом» подходе стратегии одного игрока можно интерпретировать как ассортименты выпускаемой продукции, а стратегии другого — как нормированные цены на отд. виды продукции. Оптимальная стратегия игрока будет состоять при этом в выпуске такого ассортимента продукции, что при любых нормированных ценах его гарантированный доход будет максимальным.

Теоретико-пгровые модели требуют особенно пристального рассмотрения как с философской, так и с идеологич. точек зрения, потому что по большей части они являются матем. моделями конфликтов. Конфликты же (в теоретико-игровом понимании этого слова) возможны лишь между сознат. индивидуумами и коллективами, способными предпринимать целеустремленные действия. Тем самым Т. и. оказывается теорией моделей явлений, происходящих в человеческом обществе и неизбежно имеющих поэтому классовый, политич. характер. Поэтому всякое моделирование любого явления игрой становится науч. творчеством с определенных идеологич. позиций.

Осн. проблема моделирования процессов принятия решений в условиях неопределенности (а также в условиях конфликта) касается качеств, адекватности типа игры как матем. модели, необходимости учета в ней тех пли иных частных черт моделируемого явления. Напр., конфликт двух сторон может на первый взгляд ввиду своей остроты расцениваться как антагонистический (т. е. как подлежащий моделированию антагонистич. игрой), тогда как при внимательном рассмотрении более точной его моделью оказывается нек-рая более сложная игра. Др. проблема связана с правильностью количеств, оценок параметров игры — значений выигрышей игроков в тех или иных ситуациях. Трудность такого определения усугубляется тем, что выигрыш игрока может оказаться не только детерминированной, но и случайной величиной. Последнее имеет, напр., место в условиях использования игроками смешанных стратегий.

Практич. применение Т. и. ввиду трудностей построения достаточно адекватных моделей пока ограниченно. Самыми разработанными являются теоретико-

ТЕОРИЯ ИНФОРМАЦИИ

игровые модели, описывающие наиболее четкие конфликты военного содержания. Вместе с тем довольно часто количеств, выводы, полученные на основе анализа моделей Т. и., можно рассматривать как качественные соображения при принятии решений в реальных условиях. Даваемый Т. и. анализ принятия решений в условиях неопределенности можно использовать для прогнозирования последствий от принятия этих решений. В частности, методы Т. и. позволяют в принципе оценивать и исходы достаточно простых по содержанию (но не по объему или уровню) и обозримых военных конфликтов (дуэли с небольшим числом выстрелов, схемы поиска, распределение сил п т. д.). Точность такой оценки зависит от степени адекватности игры как модели.

игровые модели, описывающие наиболее четкие конфликты военного содержания. Вместе с тем довольно часто количеств, выводы, полученные на основе анализа моделей Т. и., можно рассматривать как качественные соображения при принятии решений в реальных условиях. Даваемый Т. и. анализ принятия решений в условиях неопределенности можно использовать для прогнозирования последствий от принятия этих решений. В частности, методы Т. и. позволяют в принципе оценивать и исходы достаточно простых по содержанию (но не по объему или уровню) и обозримых военных конфликтов (дуэли с небольшим числом выстрелов, схемы поиска, распределение сил п т. д.). Точность такой оценки зависит от степени адекватности игры как модели.

Первой науч. работой, к-рую можно отнести к совр. Т. и., является статья Э. Цермело (1913) о применении теории множеств к шахматной игре. В 20-х гг. были опубликованы результаты Э. Бореля, Кальмара и Дж. Неймана, содержащие ряд важных идей Т. и. Возникновение Т. и. как целостной матем. дисциплины связано с появлением основополагающей монографии Неймана и Моргенштерна («Theory of games and economic behavior», Princeton, 1944). В наст, время по Т. и., и в т. ч. по методологпч. вопросам Т. и., публикуется большое количество книг и статей. Во многих советских и зарубежных ун-тах читаются курсы лекций по Т. и. В 1968 была проведена 1-я Всесоюзная конференция по Т. и. (г. Ереван).

Лит:: Лью с Р. Д. и Райфа X., Игры и решения,

пер. с англ., М., 1961; Матричные игры. Сб. переволов, М.,

1961; Бесконечные антагонистические игры, М., 1963; Кар

лик С, Математические методы в теории игр, программиро-

ваниий экономике, пер. с англ., М., 1964; Воробьев Н. Н.,

Некоторые методологические проблемы теории игр, «ВФ»,

1966, №1. Н. Воробьев. Ленинград.

ТЕОРИЯ ИНФОРМАЦИИ — теория, изучающая законы и способы измерения, преобразования, передачи, использования и хранения информации. В Т. и. и ее технич. приложениях центральными являются понятия количества информации и его меры. Эти понятия в известной степени'соответствуют интуитивным представлениям о количеств, оценке информации, к-рая естественно связывается с числом возможных вариантов сообщения и со степенью его неожиданности. Т. и. возникла как результат осмысления процессов шередачи сообщений, вызванного запросами практики: развитие технич. средств электросвязи требовало количественных критериев для сравнения разнородных способов передачи (телеграф, телефон, телевидение). В 1928 амер. специалист по связи Р. Хартли предложил меру информации, к^рая не зависела от способов передачи и формы сигналов в передающих каналах, а также от содержания и психологич. аспектов передаваемых сообщений. Он воспользовался универсальным свойством процессов связи: каждое сообщение — независимо- от его природы, содержания и назначения — выбирается отправителем из заранее известного получателю множества возможных различных сообщений; поэтому на приемном конце важно знать только результат (случайного для получателя) выбора, а неопределенность результата до выбора сообщения при прочих равных условиях зависит от общего числа возможных сообщений — т. Т. о., количество информации может быть измерено мерой неопределенности выбора, к-рая уничтожается после выбора сообщения. Хартли предложил логарифмич. меру неопределенности выбора: Н = к -logam (к — коэффициент пропорциональности), к-рая обладает полезным свойством аддитивности и сводит процесс измерения информации к линейному сравнению с единицей меры, т. к. для двух различных множеств сообщенпй1ода (т1 ■ т2) = = logam1-J-logam2=.ff1-f Нг. Выбор основания логариф-

ма а обусловливается областью применения меры информации; и т. к. с развитием вычислит, техники и новых средств связи распространение получила двоичная система счисления, то часто принимают £=1, а = 2. Наиболее простой выбор — выбор между двумя равными возможностями, дает одну двоичную единицу информации, пли бит (сокр. от англ. binary digit);, при то=2, log2 2=1.

Концепция выбора была развита и получила стро* гое матем. обоснование в трудах амер. ученого К. Э. Шеннона (1948). В его теории все разнообразные случаи передачи информации сводятся к абстрактной схеме: «источник сообщений — передатчик — канал — приемник — получатель», а все качественно разнородные сообщения преобразуются в единую абстрактную матем. форму. Это удается сделать всегда, если принять во внимание принципиально ограниченную' разрешающую способность получателя (любой физич. процесс измерения всегда ограничен точностью способов измерения) и те сообщения, к-рые не различаются получателем, рассматривать как одно сообщение. Тогда сообщения любых реальных источников информации, дискретных или непрерывных, можно представить конечным набором чисел или кодовых знаков, выбранных нз конечного алфавита. Напр., используя двоичную систему счисления, все сообщения можно представить (или закодировать) последовательностью из нулей п единиц. В этом случае источник в абстрактной модели схемы связи будет иметь алфавит нз двух символов, но тем не менее Полностью опишет работу реального источника с алфавитом из т. символов, а задача измерения информации сведется к определению минимально необходимого для такого-кодирования числа нулей и единиц. Это число зависит от меры неопределенности выбора символа из алфавита. Поскольку процесс создания сообщений источником заключается в последовательном и случайном для получателя выборе символов, неопределенность выбора зависит не только от т, но и от вероятностей выбора символов и вероятностных взаимосвязей между ними. Поэтому вычисление меры информации базируется на вероятностных оценках. Если р,- — вероятность выбора j-го символа алфавита s,-, то h,-= = —log pi есть количество собственной, или инд 'И'в и дуальной, информации в событии появления символа s,-. Но h,- — Величина случайная, т. к. ее значение зависит от осуществления случайного события s,-. Удобнее пользоваться др. оценкой — количеством информации, приходящейся в среднем

на символ алфавита: Н= 2aPi *< = — ZjPi 1°8Р<> T- e-

i=l t=l

просто матем. ожиданием собств. информации 1г,-. Эта формула усложняется при учете вероятностных связей между символами. Когда состояние неопределенности заменяется состоянием полного знания, т. е. вероятности выборов всех символов, кроме одного, равны нулю, а вероятность выбора этого одиночного символа равна 1, то АГ=0. Полное отсутствие знаний, напр., когда выбор производится из неизвестного получателю алфавита, также исключает передачу информации. Максимум величины Н достигается при равно-

1 вероятных символахр1=р2=...=р,/г = —, что дает меру

Хартли: Ямакс=— log p = log m.

По матем. выражению, мера количества информации совпадает с известной мерой энтропии в статистич. механике, введенной Больцманом. Это дало повод. назвать ее энтропией источника сообщений, или энтропией символов. По своему физич. смыслу энтропия источника сообщений — это минимально необходимое число знаков нек-poro кода (определяемого единицей измерения, т. е. выбором основания логарифма а)„

ТЕОРИЯ ИНФОРМАЦИИ

к-рое надо затратить в среднем на один символ реального алфавита источника, когда он посредством операции кодирования заменяется своим отображением в абстрактной схеме связи.

к-рое надо затратить в среднем на один символ реального алфавита источника, когда он посредством операции кодирования заменяется своим отображением в абстрактной схеме связи.

Приведенные подходы к оценке информации не являются единственными в своем роде. Р. А. Фишер (см. его «The design of experiments», 5 ed., Edin. — L., 1949) предложил (1921) принять за меру информации, доставляемой результатом одиночного измерения, в физич. эксперименте величину, обратно пропорциональную дисперсии результатов измерения, когда ошибки измерения подчинены нормальному закону. На возможность иных, не специально статистических, подходов к определению информации указал Колмогоров (см. сб. «Проблемы передачи информации», т. 1, вып. 1, М., 1965). Так, напр., существуют задачи, в к-рых по заданному объекту А надо построить связанный с ним объект В. Тогда количество информации в объекте А относительно объекта В можно определить как меру сложности алгоритма преобразования А в В. По существу, эта операция сводится к наиболее экономному нумерованию всех символов алфавита, причем номер каждого символа должен в среднем содержать как минимум Н бпт, если принят бинарный код. Надо иметь в виду, что численное значение энтропии символов принципиально зависит от свойств получателя различать сообщения и что в реальных системах связи по линиям связи передаются в качестве результатов выбора, конечно, не «кодовые номера», а сами сообщения, преобразованные в фпзич. сигналы. Такой мерой служит, в частности, минимально необходимое число операций, или «длина» программы, к-рая указывает, как произвести это преобразование. Этот подход получил название алгоритмического.

Тополог и ч. подход к оценке информации, когда количество информации определяется как мера топологич. различия структур, т. е. как мера тех различий, к-рые остаются инвариантными при топологич. преобразованиях, намечен Рашевским. Дальнейшим развитием этих подходов явились попытки оценить количество семантич. информации.

В семантической Т.н. пытаются преодолеть специфику абстрактных подходов и ввести количеств, оценки содержательности, важности, ценности и полезности информации, т. е. в известном смысле найти количеств, меру семантич. характеристик сообщений (предложений, высказываний). В отличие от матем. Т. п., различные варианты теории семантич. информации пытаются охарактеризовать «меру информации» гл. обр. с помощью средств логич. семантики, а также логики индуктивной и модальной логики. Хотя ни один из предложенных к наст, времени вариантов теории семантич. информации не претендует на сколько-нибудь исчерпывающее решение проблемы нахождения точных оценок семантич. информации, нек-рые из этих подходов уже дали возможность не только развить формальный матем. аппарат (как правило, впрочем, совсем простой; такова, напр., концепция семантич. информации Р. Карнапа п И. Бар-Хпл-лела, сочетающая чисто семантич. рассмотрения, базирующиеся на анализе языков прикладных предикатов исчислений, с характерными для шенноновской теории алгебро-комбинаторными схемами, предложенная ими в работе «Semantic information», в журн. «Brit. J. Philos. Sci.», 1953, v. 4, №. 14, p. 147—57), но и применить его к различным логич., лингвистич. и пси-хологич. исследованиям. Примером могут служить работы Д. Харро, посвященные формальному описанию процессов коммуникаций с помощью развиваемой им на базе логич. семантики «логики вопросов и ответов», работа сов. логика Е. К. Войшвилло, показавшего возможность объединения в рамках единой теории

шенноновской оценки количества информации с семантич. интерпретацией Карнапа и Бар-Хиллела. Ряд идей, относящихся к этой развивающейся проблематике, выдвинут советскими и иностр. учеными, работающими над задачами машинного перевода и др. проблемами лингвистики математической. Многие из этих идей предполагают выход из «чисто семантических» рамок и привлечение более общих представлений семиотики и особенно прагматики. Так, если допустить, что информация собирается для достижения нек-рой цели, то ее ценность естественно считать зависящей от того, насколько она способствует достижению этой цели. Отсюда мера ценности может быть выражена через приращение вероятности достижения цели. Продолжая развивать этот прагматич. аспект Т. п., сов. математик Е. С. Вентцель указывает след. путь оценки полезности информации: когда эффективность к.-л. мероприятий можно оценить численно, приращение эффективности (т. е. разность между эффективностью проведения мероприятий до и после получения информации об условиях, в к-рых они будут проходить) характеризует важность и ценность полученного сообщения. М. М. Бонгард (см. его «Проблема узнавания», М., 1967) связывает меру полезности сообщения с задачей, к-рую решает получатель, с запасом его знаний до прихода сообщения и способом истолкования сообщения. Если наблюдатель получает извне нек-рое сообщение, изменяющее исходную неопределенность задачи Н0 на Hlt то полезная информация, заключенная в сообщении, есть разность неопределенностей ^ПОЛезн = -^о— Hi- Под, неопределенностью задачи понимается выражение H{qlp) = —2p,log q/, где р(х) есть истинное распределение вероятностей результатов опыта, a q(x) — гипо-тетич. распределение результатов опыта, из к-рого исходит в своей деятельности наблюдатель. Заметим, что аналогичное выражение было использовано нем. психофизиком Г. Франком (1953) для меры субъективной информации, получаемой человеком при наступлении события S;, где q; играли роль «субъективных вероятностей» — величин, отражающих представления наблюдателя о численной возможности наступления события. За нулевой уровень можно при-

нять <7,-=— (t —1, 2,...,и). В этом случае количество полезной информации, содержащейся в гипотезе о том, что распределение вероятностей результатов опыта есть q(x) относительно задачи с распределением вероятностей р(х), есть Jn=H (q) — Н (q/p) = = logn—H (q/p).

Новый подход к оценке семантич. информации разрабатывается сов. математиком Ю. А. Шрейдером (см. сб. «Проблемы кибернетики», вып. 13, М., 1965). Абстрактная модель системы связи в матем. Т. и. строится в предположении, что получателю известен алфавит источника сообщений. В более общей формулировке это требование означает, что для понимания и последующего использования сообщений получатель должен обладать определ. запасом знаний. Знания получателя в ряде случаев, напр. при анализе инфор-мац. содержания в науч. статьях, можно представить в виде списка названий объектов и названий их свойств — слов, в к-ром также указаны смысловые связи между словами. Такой словарь или справочник с заданными связями представляет собой обобщение понятия тезауруса. Под влиянием сообщений, если существует алгоритм для их анализа, тезаурус будет пополняться новыми словами, в него будут добавляться новые связи и изменяться старые. При этих условиях количество семантич. информации, содержащейся в тексте сообщения, естественно измерить степенью изменения тезауруса иод влиянием сообщения. Она может быть измерена, напр., числом новых

ТЕОРИЯ ИНФОРМАЦИИ

слов и связей, числом отброшенных слов и связей и пр. Данный подход существенно отличается от концепции выбора, где предполагалось, что получаемая информация тем больше, чем меньше априорных сведений имеется об источнике информации. Напротив, мера семантич. информации растет, если один и тот же текст проектировать на все более сложные тезаурусы, т.к. в более сложных тезаурусах, вообще говоря, больше возможностей для изменения. Это хорошо согласуется с интуитивным представлением о содержат, стороне процесса обмена информацией: полное незнание предмета не позволяет извлечь существенное смысловое содержание из поступающей о нем информации. Но по мере роста наших знаний растет и извлекаемая информация. После достижения нек-рого максимума семантич. информация в поступающих к нам данных перестает расти и падает до весьма малой величины до тех пор, пока не поступят сведения, обладающие существ, новизной. Поэтому, в частности, элемент новизны в открытиях и изобретениях в любой области знаний оценивается в рамках этого подхода по степени их влияния на сложившиеся представления.

слов и связей, числом отброшенных слов и связей и пр. Данный подход существенно отличается от концепции выбора, где предполагалось, что получаемая информация тем больше, чем меньше априорных сведений имеется об источнике информации. Напротив, мера семантич. информации растет, если один и тот же текст проектировать на все более сложные тезаурусы, т.к. в более сложных тезаурусах, вообще говоря, больше возможностей для изменения. Это хорошо согласуется с интуитивным представлением о содержат, стороне процесса обмена информацией: полное незнание предмета не позволяет извлечь существенное смысловое содержание из поступающей о нем информации. Но по мере роста наших знаний растет и извлекаемая информация. После достижения нек-рого максимума семантич. информация в поступающих к нам данных перестает расти и падает до весьма малой величины до тех пор, пока не поступят сведения, обладающие существ, новизной. Поэтому, в частности, элемент новизны в открытиях и изобретениях в любой области знаний оценивается в рамках этого подхода по степени их влияния на сложившиеся представления.

Общим свойством рассмотренных мер информации является то, что они вводятся при наложении на реальную ситуацию обмена информацией строго очерченной системы абстракций. Как отметил Колмогоров, едва ли удастся такое сложное и многообразное понятие, как информация, охарактеризовать во всех случаях с помощью одной числовой величины; поэтому любой подход к количеств, оценке информации представляет собой, по существу, ту или иную форму экспликации (или ограничения) общего понятия.

Правомерно, однако, анализируя сущность пнфор-' мации как филос. категории, поставить вопрос п о наиболее общем значении и содержании этого понятия. Сов. авторы и ряд зарубежных философов-марксистов связывают категорию «информация» с объективными условиями проявления закона отражения. В этом плане информация выступает как свойство материальных объектов и процессов порождать, передавать и сохранять многообразие состояний, к-рое посредством той или иной формы отражения может быть передано от одного объекта к другому и запечатлено в его структуре. Отсюда количество информации в зависимости от уровня процесса отражения связывается с мерами упорядоченности, организованности, структурности, сложности материальных объектов, процессов и систем в их взаимодействии между собой. Вне процессов взаимодействия количеств, оценка этого свойства невозможна, поскольку многообразие состояний любого материального объекта, рассматриваемого как отдельно взятый источник информации, принципиально неограниченно (особенно если иметь в виду переход от макросостояний к микроструктуре). Конечно, на совр. этапе развития наших представлений о свойствах микромира предел различимости микросостояний объекта или физнч. переносчика сообщений устанавливается принципом неопределенности (см. Неопределенностей соотношение). Поэтому существует теоретич. возможность «абсолютной» (не зависящей от свойств «получателя») оценки макс, разнообразия, или информационной емкости. Эта величина по аналогии с физич. представлениями может быть названа «потенциальной информацией», но численная мера количества потенциальной информации, по сути дела, остается величиной относительной, определяющей своего рода предельные условия взаимодействия материальных объектов.

Определяя роль и место информации в системе диа-лектико-материалпстич. взглядов, надо иметь в виду, что информац. процессы материальны постольку, поскольку всегда воплощены в том или ином материальном процессе взаимодействия, даже если это обмен

идеями между людьми. Но статпстич. теория передачи сообщений изучает особые формы взаимодействия. Особенностью их является, во-первых, то, что хотя они и зависят от энергетич. стороны взаимодействия, но не определяются ею, т. к. информация не зависит от типа материального носителя; и, во-вторых, что осн. количеств, мера взаимодействия — энтропия источника сообщений — употребляется в том же смысле, в каком Маркс употреблял термин «мера стоимости» для обозначения одной из функций денег. В этой функции деньги, в отличие от их чувственно воспринимаемой вещественной формы, существуют лишь в идеальной форме, иначе говоря, существуют лишь в представлении (см. К. Маркс и Ф. Энгельс, Соч., 2 изд., т. 23, с. 105—06). Точно так же выражение количества информации в битах в абстрактной схеме связи носит идеальный характер, Т. е. осуществляется лишь в нашем представлении, п для этой цели применяются лишь мысленно рассматриваемые двоичные (или любые другие по произвольному выбору основания логарифма) единицы информации. В реальных сообщениях, данных, известиях никаких «бит», естественно, не содержится. Выражение "«передано 10 бит информации» означает только, что процесс передачи данного сообщения, к-рое может иметь сколь угодно сложную форму и быть телевизионным изображением, метеосводкой или сигналом в нервной сети, эквивалентен в технике связи передаче десяти чередующихся в оп-редел. порядке пауз и токовых посылок. Такова, в сущности, особенность способа измерения, вытекающая из принимаемых при построении абстрактной схемы связи допущений, особенность меры, а не особенность самой природы информации. Именно неправильное отождествление способа измерения с самой измеряемой величиной и породило представление об информации как о нематериальном объекте. Но в тех-нич. приложениях Т. и. речь всегда идет лишь о количестве информации в абстрактной схеме связи, а не об информации в ее наиболее общем смысле. Поэтому можно говорить лишь об опасности некорректного перенесения этого понятия на др. аспекты информации и, в частности, о неадекватном использовании его в методологич. работах.

Развитие Т. и. стимулируется взаимным обменом идеями и методами с др. науч. дисциплинами, напр. при решении «информационных» проблем биологии и физиологии, психологии, эстетики, языкознания, физики. Так, физнч. Т. и. изучает проблему соотношения информации и энергии. На первый взгляд энергетич. процессы в осн. построениях Т. и. не играют ч роли. Действительно, на оценке и содержательности информации не сказываются ни тип переносчика, ни физич. способ передачи. Но зависимость информации от энергии все же существует: создание информации, ее переработка и хранение невозможны без затраты энергии. В обычных условиях затраты энергии на получение одного бита информации пренебрежимо малы (в идеальном случае при очень широкой полосе частот на передачу одного бита надо затратить не менее 0,7 кТ джоулей, здесь к — постоянная Больцмана, равная 1,37-10_23 дж/град, Т — температура по шкале Кельвина). Но положение дел меняется, когда, напр., для получения информации приходится производить точные измерения на очень малых расстояниях. Бриллюэн приводит убедительный пример: если длину отрезка требуется измерить с точностью до 10~50 мм, то энергии всего лишь одного кванта волны, служащего в этом случае эталоном длины, хватило бы на разрушение всей нашей планеты. Общей формулировки ограничений, накладываемых на процессы передачи сообщений квантовыми эффектами, в настоящее время не имеется, хотя изучение квантовомеханич. каналов связи, где в ка-

ТЕОРИЯ ИНФОРМАЦИИ— ТЕОРИЯ МАЛЫХ ГРУПП 213

честве прпемо-передающих устройств используются лазеры и мазеры,— это важнейшее направление физпч. Т. п., возникшее из запросов космич. связи. Др. направление физич. Т. и. — это проблема истолкования матем. тождественности выражений для энтропии в физике и для энтропии в теории сообщений (см. Энтропия).

честве прпемо-передающих устройств используются лазеры и мазеры,— это важнейшее направление физпч. Т. п., возникшее из запросов космич. связи. Др. направление физич. Т. и. — это проблема истолкования матем. тождественности выражений для энтропии в физике и для энтропии в теории сообщений (см. Энтропия).

В экспериментальной психологии мера информации, содержащейся в предъявляемых испытуемым стимулах, позволяет отвлечься от качеств, разнообразия стимулов и ввести формальные модели процессов восприятия информации человеком и процессов памяти, допускающие применение матем. аппарата Т. и. Это стало возможным после того, как Хиком было установлено, что время реакций выбора Т„ и энтропия стимулов Н связаны между собой простой линейной зависимостью: Т=Т0-\-ЬН, где Т0 — время простой реакции, когда то=1 и выбор отсутствует, а Ъ — величина, обратно пропорциональная макс, скорости переработки информации человеком в данных условиях эксперимента. Затем последовало большое число работ, в к-рых исследовались особенности переработки информации человеком и условия применимости формулы Хика. Результаты этих исследований зачастую противоречат друг другу, и здесь все еще остается немало спорных моментов, в частности о соотношении статистич. и семантич. аспектов информации в реальной деятельности человека. Все же возможность введения математически описываемых моделей сенсомо-торных процессов, когда человека-оператора рассматривают как канал связи, включенный между двумя технич. блоками системы управления, приобретает огромное практич. значение в инженерной психологии, где без количеств, оценки всех сторон деятельности человека нельзя получить критерии эффективности и надежности сложных автоматизиров. систем управления.

В биологии, по мнению амер. биолога М. Бразье (см. сб. «Концепция информации и биологические системы», пер. с англ., М., 1966), Т. и. пока не привела к открытию новых значит, фактов, в основном потому, что для сложных биологич. систем определение количества информации настолько трудно, что большинство биологов не пользуется Т. и. в ее количеств, аспекте. С др. стороны, методологпч. основания Т. и. — упор на информационные и структурные, а не на энергетич. связи, использование вероятностных, а не детерминистских подходов, включение шумов в структуру как неотъемлемого фактора процесса переработки информации — принесли в биологию новые идеи и способствовали развитию новых направлений, в частности развитию метода моделирования важнейших биологич. и физиологич. процессов. Не-посредств. применение информац. анализа к генетич. коду хромосом тоже дало интересные результаты и позволило установить предел многообразия биологич. структур, к-рое может быть передано наследств, путем.

В лингвистике количеств, методы Т. и. способствовали появлению интересных идей. Наиболее известны работы Колмогорова (1962) в области теории языка и стихосложения, наметившие пути дальнейшего развития самой Т. п. Так, им были введены понятия информационной емкости языка — Иг, т. е. общего числа различных идей, к-рые могут быть изложены в данном языковом сообщении, и гибкости языка — й2, измеренной числом равноценных способов изложения одного и того же содержания средствами данного языка. Эти величины рассматриваются как составляющие общей энтропии языка: Д"=/г.1+^2- Необходимым условием создания поэтич. формы в языке является выполнение неравенства /i2>B, где р — коэффициент, определяемый системой фиксиров, огра-

ничений, налагаемых стихотворной формой на текст данного языка. Все эти величины измеряются статистическими или даже комбинаторными способами, и с их помощью можно производить анализ стихотворных произведений, напр. с целью установления авторства. Вообще же попытки применения Т. и. в искусстве к анализу различных форм эстетич. восприятия пока не привели к практически ценным результатам. Здесь понятие информации используется порой как синоним сложности структур, предлагаемых для восприятия, и связывается с непредсказуемостью произведения или же с его оригинальностью. Однако дей-ствит. способ количеств, оценки этой величины пока найти не удалось.

Лит.: Шеннон К., Работы по теории информации и

кибернетики, пер. с англ., М., 1963; Клаус Г., Ки

бернетика и философия, пер. с нем., М., 1963; Земан И.,

Познание и информация, пер. с чеш., М., 1966; Моль А.,

Теория информации и эстетическое восприятие, пер. с франц.,

М., 1966; В о й ш в и л л о Е. К., Попытка семантической

интерпретации статистических понятии информации и эн

тропии, в сб.: Кибернетику на службу коммунизму, т. 3,

М.—Л., 1966; Пирс Дж., Символы, сигналы, шумы, [пер.

с англ.], М., 1967; У р с у л А. Д., Природа информации, М.,

1968' Cherry С., On human communication, 2 ed., Camb.—

L., [1966]. „ Л. Фаткии. Москва.

ТЕОРИЯ МАЛЫХ ГРУПП — частная социологич. теория, предмет к-рой — структура и функционирование малых социальных объединений (коллективов), их взаимодействие с обществом и личностью.

Под малой группой (м. г.) обычно понимают малочисленную социальную группу, члены к-рой объединены общей деятельностью и находятся в непосредств. личном контакте, что является основой для возникновения как эмоц. отношений в группе (симпатии, неприязни, безразличия), так и особых групповых ценностей и норм поведения. К м. г. относят семью, производственный, научный, спортивный, воинский коллективы и нек-рые др. Минимальный размер м. г. — 2 чел., максимальный — неск. десятков человек (школьный класс). М. г. различны по роду деятельности, а также по механизмам взаимосвязи между членами группы, численности, степени устойчивости и т. д.

Среди м. г. различают: формальную, в к-рой положение и поведение отд. членов строго регламентируется офиц. правилами организации; неформальную — организацию, возникающую в рамках формальной группы на основе психологич. взаимоотношений между членами; первичную группу, отличающуюся близкими и сердечными взаимоотношениями членов и играющую гл. роль в процессе социализации личности.

М. г. характерпз5гется двусторонней структурной организацией: с одной стороны, она имеет свою собств. внутр. структуру, элементы к-рой — отд. члены, находящиеся в определ. взаимоотношениях, с другой —-она выступает в качестве элемента более сложного социального организма. Поэтому, обладая нек-рой относит, самостоятельностью, м. г. зависит от более общих социальных структур. Первичный производств, коллектив и семья — малые социальные группы, к-рые служат связующим звеном между личностью и обществом, определяя осн. особенности ее жизнедеятельности и выступая проводниками идей, установок ценностей и норм данного общества.

В немарксистской социологии основы теории м. г. были заложены в работах Зиммеля, Дюркгейма, Кули, Тенниса. По Зиммелю, исходя из критерия взаимодействия, любая м. г. — общество в миниатюре. Кули ввел понятие первичных групп. Широкое изучение м. г. в бурж. социологии в США, Англии, Франции, ФРГ, Японии и др. странах было связано с попытками ликвидации классовых, нац. и расовых конфликтов, с задачами повышения морального духа в армии и эффективности пропаганды, борьбы с преступ-

2015-05-06

2015-05-06 1501

1501