Мультиколлинеарность – это нестрогая линейная зависимость между факторными признаками (что противоречит 1-й предпосылке нормальной линейной множественной регрессионной модели о независимости факторных признаков  , которая может привести к следующим нежелательным последствиям.

, которая может привести к следующим нежелательным последствиям.

1. Оценки параметров становятся ненадежными. Они обнаруживают большие стандартные ошибки, малую значимость. В то же время модель в целом является значимой, т. е. значение множественного коэффициента корреляции завышено.

2. Небольшое изменение исходных данных приводит к существенному изменению оценок параметров модели.

3. Оценки параметров модели имеют неправильные с точки зрения теории знаки или неоправданно большие значения, что делает модель непригодной для анализа и прогнозирования.

4. Становится невозможным определить изолированное влияние факторов на результативный показатель.

Нестрогая линейная зависимость между факторными признаками совсем необязательно дает неудовлетворительные оценки. Если все другие условия благоприятствуют, т. е. если число наблюдений значительно, выборочные дисперсии факторных признаков велики, а дисперсия случайной составляющей мала, то в итоге можно получить вполне хорошие оценки. Рассмотрение данной проблемы начинается только тогда, когда это серьезно влияет на результаты оценки регрессии.

Данная проблема является обычной для регрессий временных рядов. Если независимые переменные имеют ярко выраженный временной тренд, то они будут тесно коррелированны, и это может привести к мультиколлинеарности.

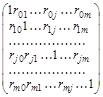

На практике о наличии мультиколлинеарности судят по матрице парных линейных коэффициентов корреляции (корреляционной матрице):

где rjk – коэффициент парной линейной корреляции между j- ми k- мфакторными признаками (j, k=1; m)

r0j – коэффициент парной линейной корреляции между результативным признаком и j -м фактором

(j=1; m).

Коэффициент корреляции, измеряющий связь признака с самим собой, равен единице, т. к. в этом случае имеет место максимально тесная связь. Поэтому на главной диагонали в корреляционной матрице стоят единицы. Корреляционная матрица является симметричной относительно главной диагонали, т. к.

rjk = rkj.

Если имеет место мультиколлинеарность, то в модель следует включать не все факторы, а только те, которые в меньшей степени ответственны за мультиколлинеарность (при условии, что качество модели снижается несущественно).

В наибольшей степени ответственным за мультиколлинеарность будет тот признак, который теснее связан с другими факторами модели (имеет более высокие по модулю значения коэффициентов парной линейной корреляции).

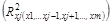

Еще один способ определения факторов, ответственных за мультиколлинеарность, основан на вычислении коэффициентов множественной детерминации  , показывающих зависимость фактора х} от других факторов модели

, показывающих зависимость фактора х} от других факторов модели  . Чем ближе значение коэффициента множественной детерминации к единице, тем больше ответственность за мультиколлинеарность фактора, выступающего в роли зависимой переменной. Сравнивая между собой коэффициенты множественной детерминации для различных факторов, можно проранжировать переменные по степени ответственности за мультиколлинеарность.

. Чем ближе значение коэффициента множественной детерминации к единице, тем больше ответственность за мультиколлинеарность фактора, выступающего в роли зависимой переменной. Сравнивая между собой коэффициенты множественной детерминации для различных факторов, можно проранжировать переменные по степени ответственности за мультиколлинеарность.

Пример. Допустим, имеются данные о заработной плате у ($), возрасте х1 (лет), стаже работы по специальности х2 (лет), выработке — x3 (шт./смену) по 10 рабочим (табл. 2.2). Требуется построить регрессионную модель заработной платы.

Таблица 2.2

| № наблюдения | у – заработная плата, $ | х1 –возраст, лёт | х2 – стаж работы по специальности, лет | х3 – выработка, шт./смену |

| ,6 | ||||

Проверим наличие мультиколлинеарности между факторами для данного примера. Для этого построим корреляционную матрицу (табл. 2.3).

Таблица 2.3

| y | x1 | x2 | x3 | |

| y | 0,853056 | 0,849877 | 0,778766 | |

| x1 | 0,853056 | 0,935263 | 0,615448 | |

| x2 | 0,849877 | 0,935263 | 0,69661 | |

| x3 | 0,778766 | 0,615448 | 0,69661 |

Из корреляционной матрицы видно, что между признаками x1 (возраст) и х2 (стаж работы по специальности) имеет место довольно сильная линейная зависимость, т. к. r1,2 = 0,935 > 0,8.

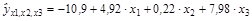

Продемонстрируем отрицательное влияние мультиколлинеарности. Для этого построим регрессионную модель заработной платы, включив в нее все исходные показатели:

(1,98) (0,08) (2,79)

В скобках указаны расчетные значения, t -критерия для проверки гипотезы о значимости коэффициента регрессии. Критическое значение tкр = 1,746 при уровне значимости  и числе степеней свободы (п - h) = 20 – 4 = 16. Из уравнения следует, что статистически значимыми являются коэффициенты регрессии только при х1 и х3, т. к. | t1 | = 1,98 > tкр = 1,746, | t3 | = 2,79 > tкр = 1,746. Таким образом, полученное уравнение регрессии неприемлемо.

и числе степеней свободы (п - h) = 20 – 4 = 16. Из уравнения следует, что статистически значимыми являются коэффициенты регрессии только при х1 и х3, т. к. | t1 | = 1,98 > tкр = 1,746, | t3 | = 2,79 > tкр = 1,746. Таким образом, полученное уравнение регрессии неприемлемо.

Из модели следует исключить фактор х2, т. к. он теснее связан с третьим фактором (выработкой), чем фактор х1,: rx2,x3г = 0,697 >rх1,х3= 0,615.

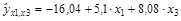

Построим теперь уравнение регрессии, исключив фактор х2. Оно будет иметь вид:

(4,76) (3,23)

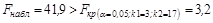

В этом уравнении все коэффициенты регрессии значимы. Причем значения t -статистик больше, чем в первом уравнении. Новое уравнение значимо в целом при  , т. к.

, т. к.

2015-05-18

2015-05-18 2234

2234