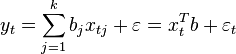

Пусть регрессионная зависимость является линейной:

Пусть y — вектор-столбец наблюдений объясняемой переменной, а  — это

— это  -матрица наблюдений факторов (строки матрицы — векторы значений факторов в данном наблюдении, по столбцам — вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид:

-матрица наблюдений факторов (строки матрицы — векторы значений факторов в данном наблюдении, по столбцам — вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид:

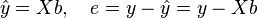

Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны

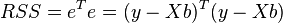

соответственно сумма квадратов остатков регрессии будет равна

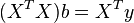

Дифференцируя эту функцию по вектору параметров  и приравняв производные к нулю, получим систему уравнений (в матричной форме):

и приравняв производные к нулю, получим систему уравнений (в матричной форме):

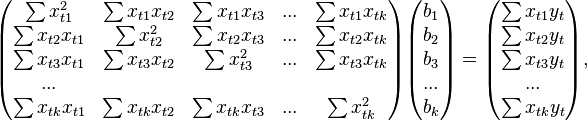

В расшифрованной матричной форме эта система уравнений выглядит следующим образом:

где все суммы берутся по всем допустимым значениям

где все суммы берутся по всем допустимым значениям  .

.

Если в модель включена константа (как обычно), то  при всех

при всех  , поэтому в левом верхнем углу матрицы системы уравнений находится количество наблюдений

, поэтому в левом верхнем углу матрицы системы уравнений находится количество наблюдений  , а в остальных элементах первой строки и первого столбца — просто суммы значений переменных:

, а в остальных элементах первой строки и первого столбца — просто суммы значений переменных:  и первый элемент правой части системы —

и первый элемент правой части системы —  .

.

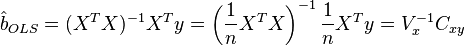

Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели:

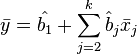

Немаловажное свойство МНК-оценок для моделей с константой — линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:

В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой — удовлетворяет критерию минимума суммы квадратов отклонений от неё.

2015-05-18

2015-05-18 807

807