Мультиколлинеарность (multicollinearity) — в эконометрике (регрессионный анализ) — наличие линейной зависимости между независимыми переменными (факторами) регрессионной модели. При этом различают полную коллинеарность, которая означает наличие функциональной (тождественной) линейной зависимости и частичную или просто мультиколлинеарность — наличие сильной корреляции между факторами.

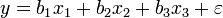

Полная коллинеарность приводит к неопределенности параметров в линейной регрессиионной модели независимо от методов оценки. Рассмотрим это на примере следующей линейной модели

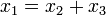

Пусть факторы этой модели тождественно связаны следующим образом:  . Тогда рассмотрим исходную линейную модель, в которой к первому коэффициенту добавим произвольное число a, а из двух других коэффициентов это же число вычтем. Тогда имеем (без случайной ошибки):

. Тогда рассмотрим исходную линейную модель, в которой к первому коэффициенту добавим произвольное число a, а из двух других коэффициентов это же число вычтем. Тогда имеем (без случайной ошибки):

Таким образом, несмотря на относительно произвольное изменение коэффициентов модели мы получили ту же модель. Такая модель принципиально неидентифицируема. Неопределенность существует уже в самой модели. Если рассмотреть 3-мерное пространство коэффициентов, то в этом пространстве вектор истинных коэффициентов в данном случае не единственный, а представляет собой целую прямую линию! Любая точка этой прямой — истинный вектор коэффициентов.

В связи с этим проблема полной коллинеарности факторов решается уже на стадии отбора переменных при моделировании и поэтому к проблеме качества эконометрических оценок параметров отношения не имеет. На практике чаще возникает другая ситуация — сильная корреляция между факторами.

Последствия мультиколлинеарности[править | править исходный текст]

Если полная коллинеарность приводит к неопределенности значений параметров, то частичная мультиколлинеарность приводит к неустойчивости их оценок. Неустойчивость выражается в увеличении статистической неопределенности — дисперсии оценок. Это означает, что конкретные результаты оценки могут сильно различаться для разных выборок несмотря на то, что выборки однородны.

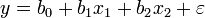

Как известно ковариационная матрица оценок параметров множественной регрессии методом наименьших квадратов равна  . Тем самым чем «меньше» ковариационная матрица (ее определитель), тем «больше» ковариационная матрица оценок параметров, и, в частности, больше диагональные элементы этой матрицы, то есть дисперсии оценок параметров. Для большей наглядности рассмотрим это на примере двухфакторной модели:

. Тем самым чем «меньше» ковариационная матрица (ее определитель), тем «больше» ковариационная матрица оценок параметров, и, в частности, больше диагональные элементы этой матрицы, то есть дисперсии оценок параметров. Для большей наглядности рассмотрим это на примере двухфакторной модели:

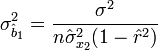

Тогда дисперсия оценки параметра, например, при первом факторе равна:

где  — выборочный коэффициент корреляции между факторами.

— выборочный коэффициент корреляции между факторами.

Здесь наглядно видно, что чем больше по модулю корреляция между факторами, тем больше дисперсия оценок параметров. При  (полная коллинеарность) дисперсия стремится к бесконечности, что соответствует сказанному ранее.

(полная коллинеарность) дисперсия стремится к бесконечности, что соответствует сказанному ранее.

Таким образом, оценки параметров получаются неточными, а значит сложно будет дать интерпретацию влияния тех или иных факторов на объясняемую переменную. При этом на качество модели в целом мультиколлинеарность не сказывается — она может признаваться статистически значимой, даже тогда, когда все коэффициенты незначимы (это один из признаков мультиколлинеарности).

2015-05-18

2015-05-18 2276

2276