Коэффициент взаимной сопряженности Чупрова более совершенен, так как учитывает число значений для изучаемых переменных

Чем ближе величины коэффициентов взаимной сопряженности к 1, тем теснее связь

Рассмотрим пример.

В таблице приведены условные данные о распределении 500 опрошенных человек по двум показателям: наличие (отсутствии) у них прививки против гриппа и факт заболевания (незаболевания) гриппом во время его эпидемии.

Таблица2. Распределение 500 опрошенных человек

| Группа лиц | Число лиц | ||

| заболевших гриппом | не заболевших гриппом | Итого | |

| Сделавших прививку | 30 (а) | 270 (b) | |

| Не сделавших прививку | 120 (c) | 80 (d) | |

| Итого |

Можно предположить, что прививка положительно влияет на предупреждение заболевания; другими словами, можно предположить, что распределение в таблице (a, b, c, d) не случайно и существует стохастическая зависимость между группировочными признаками. Однако выводы о зависимости, сделанные «на глаз», часто могут быть ненадежными (ошибочными), поэтому они должны подкрепляться определенными статистическими критериями,

Фактические частоты

| Группа | Y1 (заболели) | Y2 (не заболели) | ∑ |

| Х1 (сделали прививку) | |||

| Х2 (не сделали прививку) | |||

| ∑ |

| Группа | I (да) | II (нет) | ∑ |

| I (да) | |||

| II (нет) | |||

| ∑ |

.

.

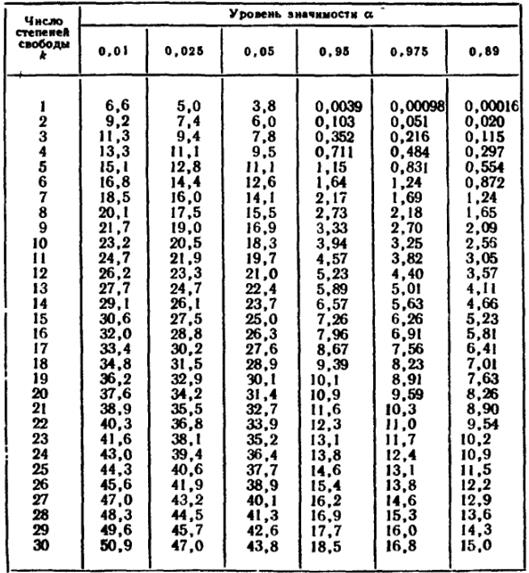

Рассчитанное (фактическое) значение χ 2 сопоставляют с табличным (критическом), определяемым по таблице для заданного уровня значимости α и числа степеней свободы  , где k1 и k2 – число групп по одному и второму признакам группировки (число строк и число столбцов в таблице).

, где k1 и k2 – число групп по одному и второму признакам группировки (число строк и число столбцов в таблице).

В рассматриваемом примере ν =(2-1)(2-1)=1, а приняв уровень значимости α =0,01, по таблице Приложения 3 находим χ2табл=6,63. Поскольку рассчитанное значение χ2> χ2табл, значит существует стохастическая зависимость между рассматриваемыми показателями.

Для измерения тесноты связи между группировочными признаками в таблицах взаимной сопряженности могут быть использованы такие показатели, как коэффициент ассоциации и контингенции (для «четырехклеточных таблиц»), а также коэффициенты взаимной сопряженности Пирсона и Чупрова (для таблиц любой размерности).

;

;

Связь считается достаточно значительной и подтвержденной, если  >0,5 или

>0,5 или  >0,3.

>0,3.

Поэтому в нашем примере оба коэффициента характеризуют достаточно большую обратную зависимость между исследуемыми признаками.

Теснота связи между 2 и более признаками измеряется с помощью коэффициентов взаимной сопряженности Пирсона или Чупрова, рассчитываемых на основе показателя χ2.

В нашем примере  .

.

Рассчитывать коэффициент Чупрова для таблицы «четырех полей» не рекомендуется, так как при числе степеней свободы ν =(2-1)(2-1)=1 он будет больше коэффициента Пирсона (в нашем примере КЧ=0,53). Для таблиц же большей размерности всегда КЧ<КП.

Таблица критических значений

2015-05-30

2015-05-30 3721

3721