Реферат

Курсовая работа включает в себя 5 заданий. В первом задании по заданным экспериментальным данным необходимо построить линейную модель (множественную регрессию) методом наименьших квадратов, а также взвешенным методом наименьших квадратов для неравноточных измерений входной величины. Суть метода заключается в решении матричного уравнения, результатом которого является вектор коэффициентов регрессии.

Вторая часть работы – численные процедуры оценивания параметров нелинейных регрессионных моделей. По-заданию требуется реализовать один из численных методов поиска МНК-оценок.

Третья часть работы включает в себя разработку аналитической модели химического реактора идеального смешения. Кроме разработки модели необходимо осуществить линеаризацию методами идентификации, а также построение кривых отклика линеаризованной и аналитической моделей.

Содержание

Реферат

Содержание

Задание 1. Идентификация объектов методом наименьших квадратов

Задание 2. Взаимосвязь различных форм моделей динамических систем

Задание 3. Построение модели с распределенными параметрами

Задание 4 численные процедуры оценивания параметров нелинейных регрессионных моделей

Задание 5 разработка аналитических моделей объектов автоматизации. Линеаризация моделей

Заключение

Задание 1. Идентификация объектов методом наименьших квадратов

1.1 Постановка задачи

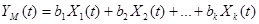

Математическая модель объекта имеет вид:

.(1.1)

.(1.1)

Имеются статистические данные наблюдений:

Известна диагональная корреляционная матрица ошибок наблюдений

.

.

Требуется:

1. Оценить вектор коэффициентов модели В методом наименьших квадратов.

2. Оценить вектор коэффициентов модели взвешенным методом наименьших квадратов, считая точность измерения входных показателей обратно пропорциональной номеру показателя.

3. Оценить вектор коэффициентов модели методом максимального правдоподобия.

4. Построить доверительные интервалы для коэффициентов модели для доверительной вероятности 0,95.

5. Проверить значимость полученной статистической модели объекта.

6. Проанализировать полученные результаты.

Таблица 1.1

Вариант задания

| Вариант | Матрица XT | Матрица YT | След матрицы D |

| 5 |

|

|

|

1.2 Математическая постановка задачи

Пусть имеются транспонированные матрицы результатов наблюдений и след диагональной корреляционной матрицы ошибок D:

Поскольку результаты наблюдений суть случайные величины, получить «истинные» значения коэффициентов  из модели

из модели

;(1.2)

;(1.2)

нельзя. Вместо этого можно получить их оценки  на основе исследований по таблице предварительно составленных наблюдений. Если речь идет о модели (1.2), то она принимает вид

на основе исследований по таблице предварительно составленных наблюдений. Если речь идет о модели (1.2), то она принимает вид

,(1.3)

,(1.3)

где  ─ предсказанное значение отклика и служит оценкой истинного значения

─ предсказанное значение отклика и служит оценкой истинного значения  . Величина отклика служит оценкой «истинного» значения

. Величина отклика служит оценкой «истинного» значения  . В регрессионном анализе для получения оценок коэффициентов модели (1.2) используется МНК.

. В регрессионном анализе для получения оценок коэффициентов модели (1.2) используется МНК.

Из-за действия случайных возмущений предсказанное значение  будет отличаться от результата измерения

будет отличаться от результата измерения  . Разности

. Разности  ,

,  , называют остатками.

, называют остатками.

Так как истинное значение вектора коэффициентов β и его оценка b различны,

, а

, а  .

.

Отсюда вектор остатков:

.

.

Оценки коэффициентов регрессии естественно искать так, чтобы обеспечить наименьшие возможные остатки, но остатки многочисленны, поэтому нужна некоторая суммарная характеристика, которая должна зависеть от различий между измеренными и предсказанными значениями выходных характеристик в каждом опыте. Такую функцию обычно называют функцией потерь, или функцией риска. Для различных целей и условий исследования она может иметь разный вид.

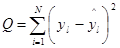

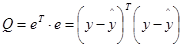

Вот одна из наиболее часто используемых функций потерь:

.(1.4)

.(1.4)

В ней остатки возведены в квадрат, чтобы компенсировать различия в их знаках.

Запишем сумму (1.4) в векторной форме. Пусть

обозначает N-мерный вектор столбец измеренных значений отклика, а

N-мерный вектор соответствующих им предсказанных значений, наконец,

вектор-столбец остатков. Как известно, скалярное произведение вектора на самого себя равно сумме квадратов его элементов, поэтому выражении (1.4) можно переписать в виде

.(1.5)

.(1.5)

Метод, позволяющий оценивать регрессионные коэффициенты, выбирают так, чтобы минимизировать величину Q. Его называют обычно методом наименьших квадратов.

Пусть на основе данных таблицы исследования нужно найти такие оценки коэффициентов регрессии, которые минимизируют сумму Q, определенную в (1.4), минимум получим, приравняв производные по неизвестным оценкам  к нулю. Но сначала подставим (1.2) в (1.4):

к нулю. Но сначала подставим (1.2) в (1.4):

.(1.6)

.(1.6)

После дифференцирования этого выражения по искомым оценкам и приравнивания нулю первых производных получаем систему уравнений:

(1.7)

(1.7)

.

.

Константы -2, входящие во все уравнения, не играют роли, ибо для равенства нулю произведения достаточно, чтобы равными нулю оказались соответствующие суммы. Поэтому полученная система сводится к виду:

(1.8)

(1.8)

Полученная система линейна относительно искомых оценок  , а число уравнений в ней равно числу неизвестных коэффициентов k модели. Она называется системой нормальных уравнений.

, а число уравнений в ней равно числу неизвестных коэффициентов k модели. Она называется системой нормальных уравнений.

Запись системы нормальных уравнений можно упростить, если положить

.(1.9)

.(1.9)

Очевидно  , поскольку порядок перемножения функций под знаком суммы не важен. В новых обозначениях система нормальных уравнений примет вид:

, поскольку порядок перемножения функций под знаком суммы не важен. В новых обозначениях система нормальных уравнений примет вид:

(1.10)

(1.10)

В дальнейшем мы воспользуемся матричной записью. Обозначим  ─ матрицу величин

─ матрицу величин  буквой G,

буквой G,  ─ вектор оценок искомых коэффициентов буквой b,

─ вектор оценок искомых коэффициентов буквой b,  ─ вектор правой части системы буквой Z. Тогда

─ вектор правой части системы буквой Z. Тогда

Важно заметить, что G ─ симметричная матрица, так как  .

.

Вот матричная запись системы нормальных уравнений:

.(1.11)

.(1.11)

Матрица G называется информационной матрицей. Ее можно представить через введенную в матрицу (1.2.2) матрицу регрессоров  . Это утверждение проверяется непосредственно транспонированием F и перемножением

. Это утверждение проверяется непосредственно транспонированием F и перемножением  . Точно так же проверяется, что

. Точно так же проверяется, что  . Значит, систему нормальных уравнений можно переписать так:

. Значит, систему нормальных уравнений можно переписать так:

.(1.12)

.(1.12)

Если ранг F равен k, то ранг  то же равенk, так как из теории матриц известно, что произведение матриц

то же равенk, так как из теории матриц известно, что произведение матриц  есть положительно определенная матрица.

есть положительно определенная матрица.

При этих условиях можно получить матрицу, обратную к информационной. Обозначим ее  . Поскольку

. Поскольку  , умножение выражения (1.12) слева на матрицу

, умножение выражения (1.12) слева на матрицу  приводит к решению системы нормальных уравнений:

приводит к решению системы нормальных уравнений:

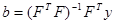

.(1.13)

.(1.13)

Таким образом, решив матричное уравнение (1.13), мы получаем в векторе b значение коэффициентов регрессии.

В случае неравноточных измерений значений входных величин применяется взвешенный метод наименьших квадратов. Данный метод отличается тем, что в матричное уравнение добавляется так называемая матрица весов. Матрица весов представляет собой диагональную матрицу, элементами которой являются величины, обратно пропорциональные квадрату дисперсии измерений входных величин:

Для взвешенного метода наименьших квадратов матричное уравнение имеет вид:

.(1.14)

.(1.14)

Для полученных коэффициентов регрессии доверительный интервал определяется таким образом:

,(1.15)

,(1.15)

где V(b) – дисперсия коэффициентов,  - коэффициент Стьюдента. Коэффициент Стьюдента определяется по таблицам. Для нашего случая он равен 2,5. Дисперсия коэффициентов определяется по следующей формуле:

- коэффициент Стьюдента. Коэффициент Стьюдента определяется по таблицам. Для нашего случая он равен 2,5. Дисперсия коэффициентов определяется по следующей формуле:

,(1.16)

,(1.16)

где S – дисперсия оценки. Определяется следующим образом:

,(1.17)

,(1.17)

Таким образом получим значения коэффициентов регрессии в виде

.

.

1.3 Результаты выполнения задания

Метод наименьших квадратов

|

|

|

|

|

| Y= | D= | W=DT= |

|

| 1 | 1 | 1 |

| 4,1 | 0,8 | 1,25 |

|

| -2 | 2 | 5 |

| 31,2 | 1,2 | 0,83 |

| X= | 5 | -2 | 3 |

| 41,3 | 0,3 | 3,33 |

|

| 2 | -1 | 1 |

| 16,5 | 0,5 | 2,00 |

|

| 3 | 2 | 1 |

| 3,2 | 0,2 | 5,00 |

|

|

|

|

|

|

|

|

|

| Решение без диагональной корреляционной матрицы | |||||||

|

|

|

|

|

|

|

|

|

|

| 1 | -2 | 5 | 2 | 3 |

|

|

| XT= | 1 | 2 | -2 | -1 | 2 |

|

|

|

| 1 | 5 | 3 | 1 | 1 |

|

|

|

|

|

|

|

|

|

|

|

|

| 43 | -9 | 11 |

|

|

|

|

| XTX= | -9 | 14 | 6 |

|

|

|

|

|

| 11 | 6 | 37 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 0,032 | 0,027 | -0,014 |

|

|

|

|

| (XTX)-1= | 0,027 | 0,099 | -0,024 |

|

|

|

|

|

| -0,014 | -0,024 | 0,035 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 190,8 |

|

|

|

|

|

|

| XTY= | -26,2 |

|

|

|

|

|

|

|

| 303,7 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1,24 |

|

|

|

|

|

|

| B=(XTX)-1XTY= | -4,77 |

|

|

|

|

|

|

|

| 8,61 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| y^ | y | y^-y | (y^-y)2 |

|

|

|

|

| 5,08 | 4,1 | 0,98 | 0,962 |

|

|

|

|

| 31,06 | 31,2 | -0,14 | 0,019 |

|

|

|

| Проверка | 41,56 | 41,3 | 0,26 | 0,066 |

|

|

|

|

| 15,85 | 16,5 | -0,65 | 0,417 |

|

|

|

|

| 2,78 | 3,2 | -0,42 | 0,174 |

|

|

|

|

|

|

| Сумма | 1,639 |

|

|

|

|

Решение с диагональной корреляционной матрицой |

|

| |||||

|

| 1,25 | 1,25 | 1,25 |

| 5,13 |

|

|

|

| -1,67 | 1,67 | 4,17 |

| 26,00 |

|

|

| WX= | 16,67 | -6,67 | 10,00 | WY= | 137,67 |

|

|

|

| 4,00 | -2,00 | 2,00 |

| 33,00 |

|

|

|

| 15,00 | 10,00 | 5,00 |

| 16,00 |

|

|

|

|

|

|

|

|

|

|

|

|

| 1 | -2 | 5 | 2 | 3 |

|

|

| XT= | 1 | 2 | -2 | -1 | 2 |

|

|

|

| 1 | 5 | 3 | 1 | 1 |

|

|

|

|

|

|

|

|

|

|

|

|

| 140,92 | -9,42 | 61,92 |

|

|

|

|

| XTWX= | -9,42 | 39,92 | -2,42 |

|

|

|

|

|

| 61,92 | -2,42 | 59,08 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 0,013 | 0,002 | -0,014 |

|

|

|

|

| (XTWX)-1= | 0,002 | 0,026 | -0,001 |

|

|

|

|

|

| -0,014 | -0,001 | 0,031 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 755,46 |

|

|

|

|

|

|

| XTWY= | -219,21 |

|

|

|

|

|

|

|

| 597,13 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1,28 |

|

|

|

|

|

|

| B=(XTWX)-1XTWY= | -4,67 |

|

|

|

|

|

|

|

| 8,57 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| y^ | y | y^-y | (y^-y)2 |

|

|

|

|

| 5,18 | 4,1 | 1,08 | 1,175 |

|

|

|

|

| 30,95 | 31,2 | -0,25 | 0,063 |

|

|

|

|

| 41,47 | 41,3 | 0,17 | 0,028 |

|

|

|

|

| 15,81 | 16,5 | -0,69 | 0,480 |

|

|

|

|

| 3,08 | 3,2 | -0,12 | 0,014 |

|

|

|

|

|

|

| Сумма | 1,761 |

|

|

|

Расчет доверительных интервалов

|

| 1 | 1 | 1 | y | y^-y | (y^-y)2 |

|

| -2 | 2 | 5 | 4,1 | 0,465 | 0,216 |

| X= | 5 | -2 | 3 | 31,2 | -0,546 | 0,298 |

|

| 2 | -1 | 1 | 41,3 | -0,252 | 0,063 |

|

| 3 | 2 | 1 | 16,5 | -0,119 | 0,014 |

|

|

|

|

| 3,2 | 0,371 | 0,138 |

|

|

|

|

|

| Сумма | 0,729 |

| Хср= | 1,8 | 0,4 | 2,2 |

|

|

|

|

|

|

|

| b1= | 1,235 |

|

|

|

|

|

| b2= | -4,769 |

|

|

| -0,8 | 0,6 | -1,2 | b3= | 8,614 |

|

|

| -3,8 | 1,6 | 2,8 |

|

|

|

| Х-Хср= | 3,2 | -2,4 | 0,8 |

|

|

|

|

| 0,2 | -1,4 | -1,2 |

|

|

|

|

| 1,2 | 1,6 | -1,2 |

|

|

|

|

|

|

|

|

|

|

|

|

| 1 | 1 | 1 |

|

|

|

|

| 4 | 4 | 25 |

|

|

|

| Х2= | 25 | 4 | 9 |

|

|

|

|

| 4 | 1 | 1 |

|

|

|

|

| 9 | 4 | 1 |

|

|

|

|

|

|

|

|

|

|

|

| Сумма | 43 | 14 | 37 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 0,64 | 0,36 | 1,44 |

|

|

|

|

| 14,44 | 2,56 | 7,84 |

|

|

|

| (X-Хcp)2= | 10,24 | 5,76 | 0,64 |

|

|

|

|

| 0,04 | 1,96 | 1,44 |

|

|

|

|

| 1,44 | 2,56 | 1,44 |

|

|

|

| Сумма | 26,8 | 13,2 | 12,8 |

|

|

|

|

| S2= | 0,243 |

|

|

|

|

|

| V(b1)= | 0,078 |

|

|

|

|

|

| V(b2)= | 0,052 |

|

|

|

|

|

| V(b3)= | 0,141 |

|

|

|

|

|

| b1 | 0,537 |

|

|

| |

|

| b2 | -5,337 |

|

|

| |

|

| b3 | 7,677 |

|

|

|

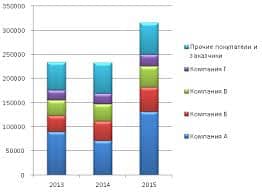

Метод наименьших квадратов рис 1.1

МНК график остатков рис 1.2

2020-01-14

2020-01-14 187

187