Количество информации по Хартли

Хартли был пионером в области Информационной Теории. Он ввёл понятие "информации" как случайная переменная и был первый, кто попытался определить "меру информации". Хартли развивал понятие информации, основанной на "физическом как противопоставлено с психологическими рассмотрениями" для использования в изучении электронных коммуникаций. Фактически, Хартли соответственно определяет это основное понятие. Вместо этого он обращается к "точности... информации" и "количества информации".

Информация существует в передаче символов, с символами, имеющими "определённые значения к партийному сообщению". Когда кто - то получает информацию, каждый полученный символ позволяет получателю "устранять возможности", исключая другие возможные символы и их связанные значения.

Точность информации зависит от того, что другие последовательности символа, возможно, были выбраны; мера этих других последовательностей обеспечивает признак количества переданной информации. Таким образом, если бы мы получили 4 различных символа, происходящие с равной частотой, то это представило бы 2 бита.

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I = log2 K,

Где К - количество равновероятных событий; I - количество бит в сообщении, такое, что любое из К событий произошло. Тогда K=2I.

Иногда формулу Хартли записывают так:

I = log2 K = log2 (1 / р) = - log2 р,

т. к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р.

Задача.

Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В.

Решение: такое сообщение содержит I = log2 3 = 1,585 бита информации.

Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона:

I = - Sum 1 / К log2 (1 / К) = I = log2 К.

При равновероятных событиях получаемое количество информации максимально.

Количество информации по Шеннону

Для определения количества информации не всегда возможно использовать формулу Хартли. Её применяют, когда выбор любого элемента из множества, содержащего N элементов, равнозначен. Или, при алфавитном подходе, все символы алфавита встречаются в сообщениях, записанных с помощью этого алфавита, одинаково часто. Однако, в действительности символы алфавитов естественных языков в сообщениях появляются с разной частотой.

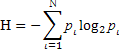

Пусть мы имеем алфавит, состоящий из N символов, с частотной характеристикой P1, P2,... PN, где Pi - вероятность появления i – го символа. Все вероятности неотрицательны и их сумма равна 1. Тогда средний информационный вес символа (количество информации, содержащееся в символе) такого алфавита выражается формулой Шеннона:

где Н – количество информации, N – количество возможных событий, Pi – вероятность отдельных событий

2015-05-06

2015-05-06 9347

9347