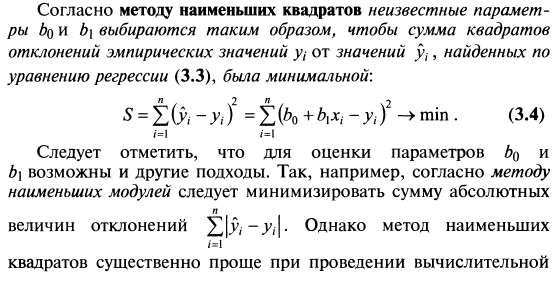

- Метод наименьших квадратов

- Функция потерь

- Метод взвешенных наименьших квадратов

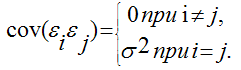

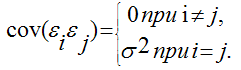

- Метод максимума правдоподобия

- Максимум правдоподобия и логит/пробит модели

- Алгоритмы минимизации функций

- Начальные значения, размеры шагов и критерий сходимости

- Штрафные функции, ограничение параметров

- Локальные минимумы

- Квази-ньютоновский метод

- Симплекс-метод

- Метод Хука-Дживиса

- Метод Розенброка

- Матрица Гессе и стандартные ошибки

Точечные оценки параметров модели парной линейной регрессии, их свойства и экономическая интерпретация. Связь оценки коэффициента регрессии с выборочным значением коэффициента корреляции.

Точечные оценки параметров модели парной линейной регрессии определяются из системы нормальных уравнений. Решением этой системы являются искомые значение коэффициентов выборочной функции регрессии, которые можно рассчитать по формулам:

=

=

=

=  -

-  *

*

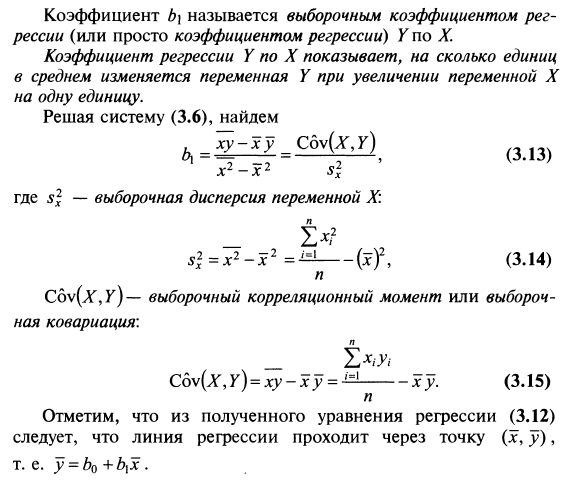

Коэффициент b1 называется выборочным коэффициентом регрессии (или просто коэффициентом регрессии) Y по X. Коэффициент регрессии показывает, на сколько единиц в среднем изменяется переменная Y при увеличении переменной Х на одну единицу.

Таким образом, мы получим выражение выборочной функции парной линейной регрессии, которое является оценкой функции парной линейной регрессии для ГС.

Свойства оценок коэффициентов функции регрессии, полученных с помощью МНК:

Предположим, что методом наименьших квадратов получена оценка  Для того, чтобы данная оценка могла быть принята за оценку параметра

Для того, чтобы данная оценка могла быть принята за оценку параметра  необходимо и достаточно выполнения трёх статистических свойств:

необходимо и достаточно выполнения трёх статистических свойств:

1) свойства несмещённости;

2) свойства состоятельности;

3) свойства эффективности.

Сделаем следующие предположения об отклонениях єi:

1) величина єiявляется случайной переменной;

2) математическое ожидание єiравно нулю: М (єi) = 0;

3) дисперсия є постоянна: D(єi) = D(єi) = s 2 для всех i, j;

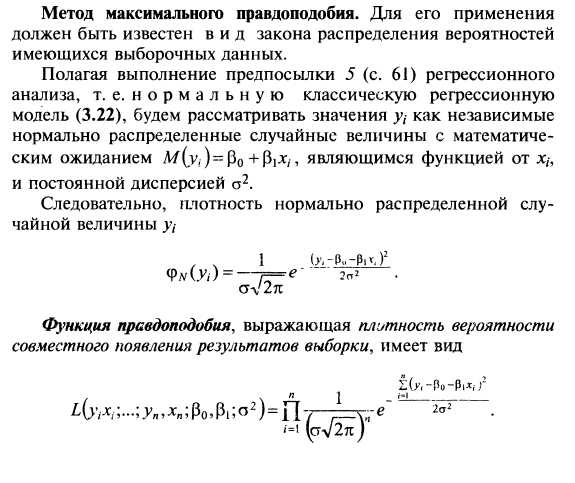

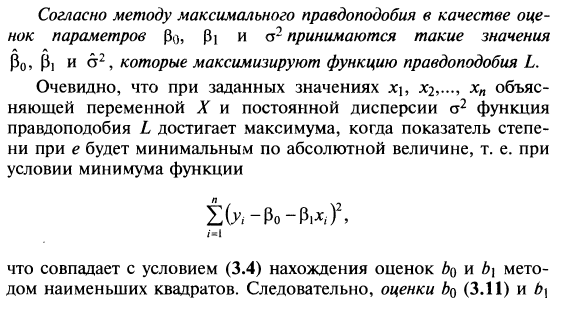

4) значения єiнезависимы между собой, следовательно, справедливо следующее выражение:

Эффективность МНК-оценок доказывается с помощью теоремы Гаусса-Маркова.

Свойство эффективности оценок неизвестных параметров модели регрессии, полученных методом наименьших квадратов, доказывается с помощью теоремы Гаусса-Маркова.

Сделаем следующие предположения о модели парной регрессии:

1) факторная переменная xi– неслучайная или детерминированная величина, которая не зависит от распределения случайной ошибки модели регрессии βi;

2) математическое ожидание случайной ошибки модели регрессии равно нулю во всех наблюдениях:

3) дисперсия случайной ошибки модели регрессии постоянна для всех наблюдений:;

4) между значениями случайных ошибок модели регрессии в любых двух наблюдениях отсутствует систематическая взаимосвязь, т. е. случайные ошибки модели регрессии не коррелированны между собой (ковариация случайных ошибок любых двух разных наблюдений равна нулю):

Это условие выполняется в том случае, если исходные данные не являются временными рядами;

5) на основании третьего и четвёртого условий часто добавляется пятое условие, заключающееся в том, что случайная ошибка модели регрессии – это случайная величина, подчиняющейся нормальному закону распределения с нулевым математическим ожиданием и дисперсией G2: εi~N(0, G2).

Если выдвинутые предположения справедливы, то оценки неизвестных параметров модели парной регрессии, полученные методом наименьших квадратов, имеют наименьшую дисперсию в классе всех линейных несмещённых оценок, т. е. МНК-оценки можно считать эффективными оценками неизвестных параметров β0 и β1.

Если выдвинутые предположения справедливы для модели множественной регрессии, то оценки неизвестных параметров данной модели регрессии, полученные методом наименьших квадратов, имеют наименьшую дисперсию в классе всех линейных несмещённых оценок, т. е. МНК-оценки можно считать эффективными оценками неизвестных параметров β0…βn.

Коэффициент корреляции связан с коэффициентом регрессии в виде следующей зависимости:

Точечные оценки параметров модели парной линейной регрессии, их свойства и экономическая интерпретация. Связь оценки коэффициента регрессии с выборочным значением коэффициента корреляции.

Точечные оценки параметров модели парной линейной регрессии определяются из системы нормальных уравнений. Решением этой системы являются искомые значение коэффициентов выборочной функции регрессии, которые можно рассчитать по формулам:

=

=

=

=  -

-  *

*

Коэффициент b1 называется выборочным коэффициентом регрессии (или просто коэффициентом регрессии) Y по X. Коэффициент регрессии показывает, на сколько единиц в среднем изменяется переменная Y при увеличении переменной Х на одну единицу.

Таким образом, мы получим выражение выборочной функции парной линейной регрессии, которое является оценкой функции парной линейной регрессии для ГС.

Свойства оценок коэффициентов функции регрессии, полученных с помощью МНК:

Предположим, что методом наименьших квадратов получена оценка  Для того, чтобы данная оценка могла быть принята за оценку параметра

Для того, чтобы данная оценка могла быть принята за оценку параметра  необходимо и достаточно выполнения трёх статистических свойств:

необходимо и достаточно выполнения трёх статистических свойств:

1) свойства несмещённости;

2) свойства состоятельности;

3) свойства эффективности.

Сделаем следующие предположения об отклонениях єi:

1) величина єiявляется случайной переменной;

2) математическое ожидание єiравно нулю: М (єi) = 0;

3) дисперсия є постоянна: D(єi) = D(єi) = s 2 для всех i, j;

4) значения єiнезависимы между собой, следовательно, справедливо следующее выражение:

Эффективность МНК-оценок доказывается с помощью теоремы Гаусса-Маркова.

Свойство эффективности оценок неизвестных параметров модели регрессии, полученных методом наименьших квадратов, доказывается с помощью теоремы Гаусса-Маркова.

Сделаем следующие предположения о модели парной регрессии:

1) факторная переменная xi– неслучайная или детерминированная величина, которая не зависит от распределения случайной ошибки модели регрессии βi;

2) математическое ожидание случайной ошибки модели регрессии равно нулю во всех наблюдениях:

3) дисперсия случайной ошибки модели регрессии постоянна для всех наблюдений:;

4) между значениями случайных ошибок модели регрессии в любых двух наблюдениях отсутствует систематическая взаимосвязь, т. е. случайные ошибки модели регрессии не коррелированны между собой (ковариация случайных ошибок любых двух разных наблюдений равна нулю):

Это условие выполняется в том случае, если исходные данные не являются временными рядами;

5) на основании третьего и четвёртого условий часто добавляется пятое условие, заключающееся в том, что случайная ошибка модели регрессии – это случайная величина, подчиняющейся нормальному закону распределения с нулевым математическим ожиданием и дисперсией G2: εi~N(0, G2).

Если выдвинутые предположения справедливы, то оценки неизвестных параметров модели парной регрессии, полученные методом наименьших квадратов, имеют наименьшую дисперсию в классе всех линейных несмещённых оценок, т. е. МНК-оценки можно считать эффективными оценками неизвестных параметров β0 и β1.

Если выдвинутые предположения справедливы для модели множественной регрессии, то оценки неизвестных параметров данной модели регрессии, полученные методом наименьших квадратов, имеют наименьшую дисперсию в классе всех линейных несмещённых оценок, т. е. МНК-оценки можно считать эффективными оценками неизвестных параметров β0…βn.

Коэффициент корреляции связан с коэффициентом регрессии в виде следующей зависимости:

2015-05-18

2015-05-18 1051

1051