Дня оценки параметров регрессионного уравнения наиболее часто используют метод наименьших квадратов (МНК).

Метод наименьших квадратов дает оценки, имеющие наименьшую дисперсию в классе всех линейных оценок, если выполняются предпосылки нормальной линейной регрессионной модели.

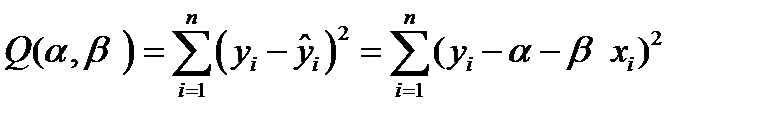

МНК минимизирует сумму квадратов отклонения наблюдаемых значений  от модельных значений

от модельных значений  .

.

Те мин отклонение прямой от точек.

1. Математическое ожидание случайного отклонения еi равно нулю: M(еi) = 0 для всех наблюдений.

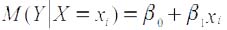

Данное условие означает, что случайное отклонение в среднем не оказывает влияния на зависимую переменную. В определенном наблюдении случайный член может быть положительным или отрицательным, но он не должен иметь систематического смещения. Выполнимость M(еi) = 0 влечет выполнимость:

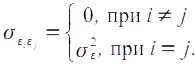

2. Дисперсия случайных отклонений epsiloni постоянна: D(εi) = D (εj) = σ2 = const для любых наблюдений i и j.

Условие независимости дисперсии ошибки от номера наблюдения называется гомоскедастичностью (homoscedasticity). Невыполнимость этой предпосылки называется гетероскедастичностью (heteroscedasticity).

|

|

|

Поскольку D(ε)=M((εj - Mεj))2 = M(ε2), то эту предпосылку можно переписать в форме: M(е2i) = σ2. Причины невыполнимости данной предпосылки и проблемы, связанные с этим, подробно рассматриваются ниже.

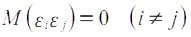

3. Случайные отклонения εi и εj являются независимыми друг от друга для i ≠ j.

Выполнимость этой предпосылки предполагает, что отсутствует систематическая связь между любыми случайными отклонениями. Величина и определенный знак любого случайного отклонения не должны быть причинами величины и знака любого другого отклонения.

Выполнимость данной предпосылки влечет следующее соотношение:

Если данное условие выполняется, то можно говорить об отсутствии автокорреляции. С учетом выполнимости предпосылки 1 данное соотношение можно переписать в виде:

Причины невыполнимости этой предпосылки и проблемы, связанные с ними, рассматриваются ниже.

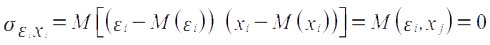

4. Случайное отклонение должно быть независимо от объясняющих переменных.

Обычно это условие выполняется автоматически, если объясняющие переменные не являются случайными в модели.

Данное условие предполагает выполнимость следующего соотношения:

Заметим, что выполнимость этой предпосылки не столь критична для эконометрических моделей.

5. Модель является линейной относительно параметров.

Для случая множественной линейной регрессии существенными являются еще две предпосылки.

6. Отсутствие мультиколлинеарности.

Между объясняющими переменными отсутствует сильная линейная зависимость.

7. Случайные отклонения εi, i = 1, 2,..., n, имеют нормальное распределение.

|

|

|

Выполнимость данной предпосылки важна для проверки статистических гипотез и построения интервальных оценок.

Наряду с выполнимостью указанных предпосылок при построении классических линейных регрессионных моделей делаются еще некоторые предположения. Например:

· объясняющие переменные не являются случайными величинами;

· число наблюдений намного больше числа объясняющих переменных (числа факторов уравнения);

· отсутствуют ошибки спецификации, т. е. правильно выбран вид уравнения и в него включены все необходимые переменные.

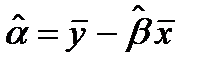

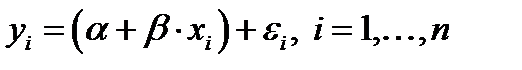

Согласно принципу метода наименьших квадратов, оценки  и

и  находятся путем минимизации суммы квадратов

находятся путем минимизации суммы квадратов

по всем возможным значениям  и

и  при заданных (наблюдаемых) значениях

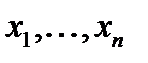

при заданных (наблюдаемых) значениях  .

.

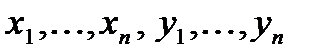

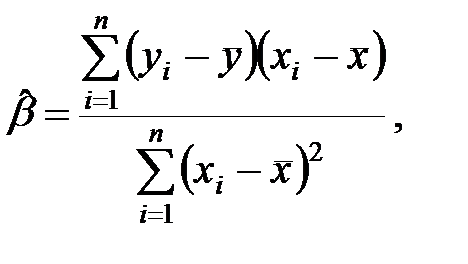

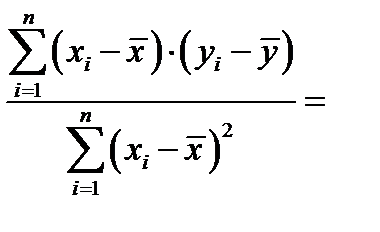

В результате применения МНК получаем формулы для вычисления параметров модели парной регрессии.

(3)

(3)

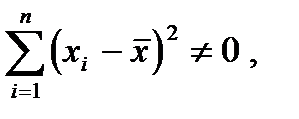

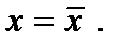

Такое решение может существовать только при выполнении условия

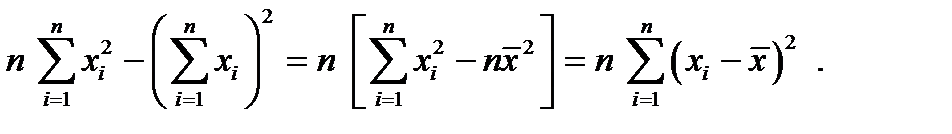

что равносильно отличию от нуля определителя системы нормальных уравнений. Действительно, этот определитель равен

Последнее условие называется условием идентифицируемости модели наблюдений  , и означает, что не все значения

, и означает, что не все значения  совпадают между собой. При нарушении этого условия все точки

совпадают между собой. При нарушении этого условия все точки  , лежат на одной вертикальной прямой

, лежат на одной вертикальной прямой

Оценки  и

и  называют оценками наименьших квадратов. Обратим внимание на полученное выражение для параметра

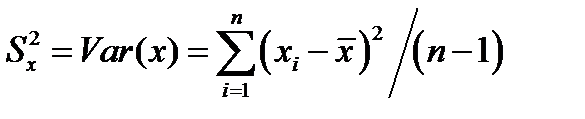

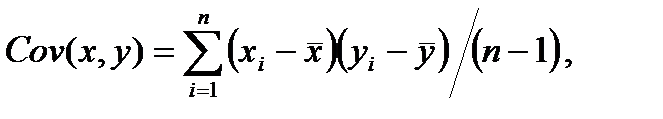

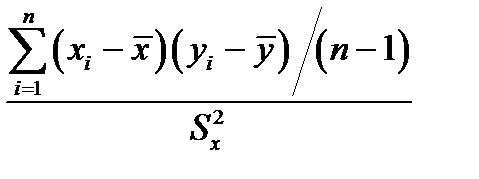

называют оценками наименьших квадратов. Обратим внимание на полученное выражение для параметра  . В это выражение входят суммы квадратов, участвовавшие ранее в определении выборочной дисперсии

. В это выражение входят суммы квадратов, участвовавшие ранее в определении выборочной дисперсии

и выборочной ковариации

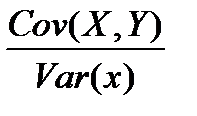

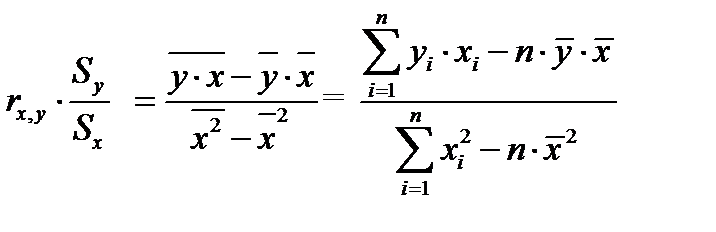

так что, в этих терминах параметр

так что, в этих терминах параметр  можно получить следующим образом:

можно получить следующим образом:

=

=  =

=

=

=

=

11. Уравнение регрессии в стандартизованном масштабе

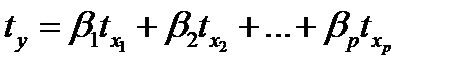

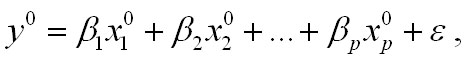

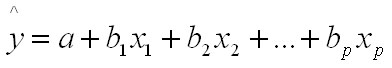

Другой вид уравнения множественной регрессии - уравнение регрессии в стандартизованном масштабе:

,

,

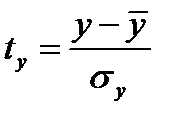

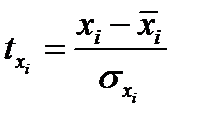

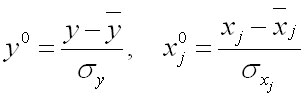

где  ,

,  - стандартизованные переменные;

- стандартизованные переменные;

- стандартизованные коэффициенты регрессии.

- стандартизованные коэффициенты регрессии.

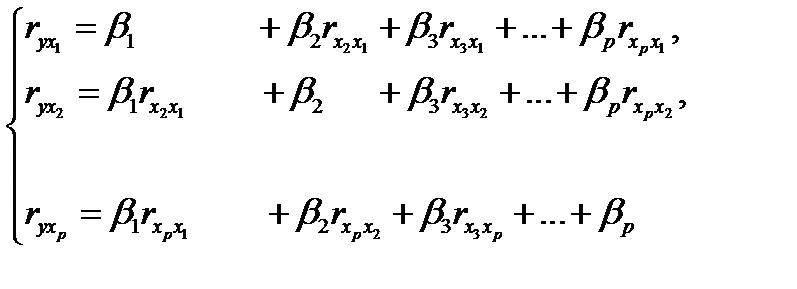

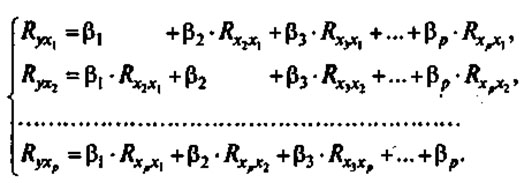

К уравнению множественной регрессии в стандартизованном масштабе применим МНК. Стандартизованные коэффициенты регрессии (β-коэффициенты) определяются из следующей системы уравнений:

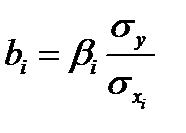

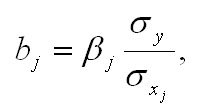

Связь коэффициентов множественной регрессии  со стандартизованными коэффициентами

со стандартизованными коэффициентами  описывается соотношением

описывается соотношением

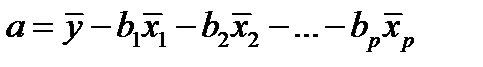

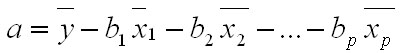

Параметр a определяется как

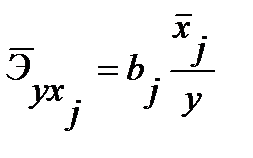

Средние коэффициенты эластичности для линейной регрессии рассчитываются по формуле:

.

.

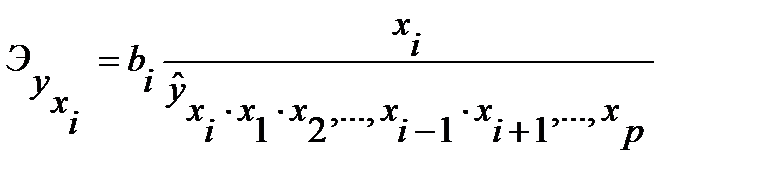

Для расчета частных коэффициентов эластичности применяется следующая формула:

.

.

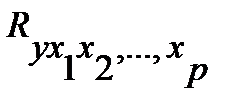

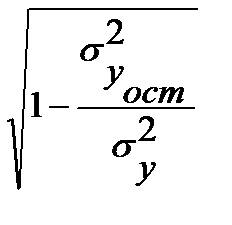

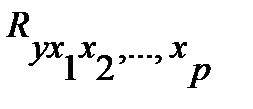

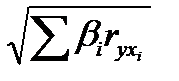

Тесноту совместного влияния факторов на результат оценивает индекс множественной корреляции:

=

=  .

.

Значение индекса множественной корреляции лежит в пределах от 0 до 1 и должно быть больше или равно максимальному парному индексу корреляции:

.

.

Индекс множественной корреляции для уравнения в стандартизованном масштабе можно записать в виде:

=

=  .

.

При линейной зависимости коэффициент множественной корреляции можно определить через матрицу парных коэффициентов корреляции:

=

=  ,

,

Параметры уравнения множественной регрессии в задачах по эконометрике оценивают аналогично парной регрессии, методом наименьших квадратов (МНК). При применении этого метода строится система нормальных уравнений, решение которой и позволяет получать оценки параметров регрессии.

При определении параметров уравнения множественной регрессии на основе матрицы парных коэффициентов корреляции строим уравнение регрессии в стандартизованном масштабе:

в уравнении стандартизированные переменные

Применяя метод МНК к моделям множественной регрессии в стандартизованном масштабе, после опрделенных преобразований получим систему нормальных уравнений вида

Решая системы методом определителей, находим параметры — стандартизованные коэффициенты регрессии (бета - коэффициенты). Сравнивая коэффициенты друг с другом, можно ранжировать факторы по силе их воздействия на результат. В этом заключается основное достоинство стандартизованных коэффициентов в отличие от обычных коэффициентов регрессии, которые несравнимы между собой.

|

|

|

В парной зависимости стандартизованный коэффициент регрессии связан с соответствующим коэфициентом уравнения зависимостью

Это позволяет от уравнения в стандартизованном масштабе переходить к регрессионному уравнению в натуральном масштабе переменных:

Параметр а определяется из следующего уравнения

Стандартизованные коэффициенты регрессии показывают, на сколько сигм изменится в среднем результат, если соответствующий фактор xj изменится на одну сигму при неизменном среднем уровне других факторов. В силу того, что все переменные заданы как центрированные и нормированные, стандартизованные коэффициенты регрессии сравнимы между собой.

Рассмотренный смысл стандартизованных коэффициентов позволяет использовать их при отсеве факторов, исключая из модели факторы с наименьшим значением.

Компьютерные программы построения уравнения множественной регрессии позволяют получать либо только уравнение регрессии для исходных данных и уравнение регрессии в стандартизованном масштабе.

2015-05-18

2015-05-18 2567

2567