1. Линейная  .

.

2. Парабола 2 порядка  .

.

3. Гипербола  .

.

4. Показательная  .

.

5. Степенная  .

.

6. Полулогарифмическая  .

.

7. Логистическая  .

.

8. Обратная  .

.

Несмотря на широкое использование в эконометрике коэффициентов эластичности, возможны случаи, когда их расчет экономического смысла не имеет. Это происходит тогда, когда для рассматриваемых признаков бессмысленно определение изменения значений в процентах. Например, вряд ли кто будет определять, на сколько процентов может измениться заработная плата с ростом стажа работы на 1 %. Или, например, на сколько процентов изменится урожайность пшеницы, если качество почвы, измеряемое в баллах, изменится на 1 %.

Уравнение нелинейной регрессии, так же как и в линейной зависимости, дополняется показателем корреляции, а именно индексом корреляции (R):

или

или

Величина данного показателя находится в границах: 0 ≤ R ≤ 1, чем ближе к единице, тем теснее связь рассматриваемых признаков, тем более надежно найденное уравнение регрессии.

Поскольку в расчете индекса корреляции используется соотношение факторной и общей суммы квадратов отклонений, то R2 имеет тот же смысл, что и коэффициент детерминации. В специальных исследованиях величину R2 для нелинейных связей называют индексом детерминации.

Оценка существенности индекса корреляции проводится, так же как и оценка надежности коэффициента корреляции.

28. Проверка гипотезы о наличии линейной связи между зависимой и независимыми переменными.

29. Проверка существенности влияния факторов на результативную переменную.

30. Понятие мультиколлинеарности факторов.

Мультиколлениарность факторов – тесная корреляционная взаимосвязь между отбираемыми для анализа факторами, совместно воздействующими на общий результат, которая затрудняет оценивание регрессионных параметров

– наличие высокой линейной связи между всеми или несколькими факторами.

Причинами возникновения мультиколлинеарности между признаками являются:

1. Изучаемые факторные признаки, характеризуют одну и ту же сторону явления или процесса. Например, показатели объема производимой продукции и среднегодовой стоимости основных фондов одновременно включать в модель не рекомендуется, так как они оба характеризуют размер предприятия;

2. Использование в качестве факторных признаков показателей, суммарное значение которых представляет собой постоянную величину;

3. Факторные признаки, являющиеся составными элементами друг друга;

4. Факторные признаки, по экономическому смыслу дублирующие друг друга.

5. Одним из индикаторов определения наличия мультиколлинеарности между признаками является превышение парным коэффициентом корреляции величины 0,8 (rxi xj) и др.

Наличие мультиколлинеарности факторов может означать, что некоторые факторы будут всегда действовать в унисон, и в результате нельзя будет оценить воздействие каждого фактора в отдельности.

Включение в модель мультиколлинеарных факторов нежелательно в силу следующих последствий:

1) оценки параметров становятся ненадежными, обнаруживают большие стандартные ошибки и меняются с изменением объема наблюдений (не только в величине, но и по знаку), что делает модель непригодной для анализа и прогнозирования.

2) затрудняется интерпретация параметров множественной регрессии как характеристик действия факторов в «чистом» виде, ибо факторы коррелированны; параметры линейной регрессии теряют экономический смысл;

3) нельзя определить изолированное влияние факторов на результативный показатель.

Для оценки мультиколлинеарности факторов может использоваться определитель матрицы парных коэффициентов корреляции между факторами. Чем ближе к 0 определитель матрицы межфакторной корреляции, тем сильнее мультиколлениарность факторов и ненадежнее результаты множественной регрессии. Чем ближе определитель к 1 – тем ниже мультиколлениарность.

Если между факторами существует высокая корреляция, то нельзя определить их изолированное влияние на результативный показатель и параметры уравнения регрессии оказываются неинтерпретируемыми.

Существуют различные подходы преодоления сильной межфакторной корреляции. Простейший из них - исключение из модели фактора (или факторов), в наибольшей степени ответственных за мультиколлинеарность при условии, что качество модели при этом пострадает несущественно (а именно,  снизится несущественно).

снизится несущественно).

31. Определение мультиколлинеарности факторов (критерий).

Определение мультиколлинеарности.

Наибольшие затруднения в использовании аппарата множественной регрессии возникают при наличии мультиколлинеарности факторных переменных, когда более чем два фактора связаны между собой линейной зависимостью.

Мультиколлинеарностью для линейной множественной регрессии называется наличие линейной зависимости между факторными переменными, включёнными в модель.

Мультиколлинеарность – нарушение одного из основных условий, лежащих в основе построения линейной модели множественной регрессии.

Мультиколлинеарность в матричном виде – это зависимость между столбцами матрицы факторных переменных Х:

Если не учитывать единичный вектор, то размерность данной матрицы равна n*n. Если ранг матрицы Х меньше n, то в модели присутствует полная или строгая мультиколлинеарность. Но на практике полная мультиколлинеарность почти не встречается.

Можно сделать вывод, что одной из основных причин присутствия мультиколлинеарности в модели множественной регрессии является плохая матрица факторных переменных Х.

Чем сильнее мультиколлинеарность факторных переменных, тем менее надежной является оценка распределения суммы объясненной вариации по отдельным факторам с помощью метода наименьших квадратов.

Включение в модель мультиколлинеарных факторов нежелательно по нескольким причинам:

1) основная гипотеза о незначимости коэффициентов множественной регрессии может подтвердиться, но сама модель регрессии при проверке с помощью F-критерия оказывается значимой, что говорит о завышенной величине коэффициента множественной корреляции;

2) полученные оценки коэффициентов модели множественной регрессии могут быть неоправданно завышены или иметь неправильные знаки;

3) добавление или исключение из исходных данных одного-двух наблюдений оказывает сильное влияние на оценки коэффициентов модели;

4) мультиколлинеарные факторы, включённые в модель множественной регрессии, способны сделать её непригодной для дальнейшего применения.

Конкретных методов обнаружения мультиколлинеарности не существует, а принято применять ряд эмпирических приёмов. В большинстве случаев множественный регрессионный анализ начинается с рассмотрения корреляционной матрицы факторных переменных R или матрицы (ХТХ).

Корреляционной матрицей факторных переменных называется симметричная относительно главной диагонали матрица линейных коэффициентов парной корреляции факторных переменных:

где rij – линейный коэффициент парной корреляции между i-м и j-ым факторными переменными, На диагонали корреляционной матрицы находятся единицы, потому что коэффициент корреляции факторной переменной с самой собой равен единице.

При рассмотрении данной матрицы с целью выявления мультиколлинеарных факторов руководствуются следующими правилами:

1) если в корреляционной матрице факторных переменных присутствуют коэффициенты парной корреляции по абсолютной величине большие 0,8, то делают вывод, что в данной модели множественной регрессии существует мультиколлинеарность;

2) вычисляют собственные числа корреляционной матрицы факторных переменных λmin и λmax. Если λmin‹10-5, то в модели регрессии присутствует мультиколлинеарность. Если отношение

то также делают вывод о наличии мультиколлинеарных факторных переменных;

3) вычисляют определитель корреляционной матрицы факторных переменных. Если его величина очень мала, то в модели регрессии присутствует мультиколлинеарность.

32. Избавление от мультиколлинеарности факторов (Метод гребневой регрессии).

При использовании «ридж-регрессии» (или «гребневой регрессии») вместо несмещённых оценок рассматривают смещённые оценки, задаваемые вектором

βτ^=(X`X+τ Ep+1)-1 X`Y,

где τ – некоторое положительное число, называемое «гребнем» или «хребтом»,

Ep+1 – единичная матрица (р+1) –го порядка.

Добавление τ к диагональным элементам матрицы X`X делает оценки параметров модели смещёнными, но при этом увеличивается определитель матрицы системы нормальных уравнений – вместо (X`X) от будет равен

|X`X+τ Ep+1|

Таким образом, становится возможным исключение мультиколлинеарности в случае, когда определитель |X`X| близок к нулю.

33. Избавление от мультиколлинеарности факторов (Метод главных компонент).

Для устранения мультиколлинеарности может быть использован переход от исходных объясняющих переменных X1,X2,…,Xn, связанных между собой достаточно тесной корреляционной зависимостью, к новым переменным, представляющим линейные комбинации исходных. При этом новые переменные должны быть слабо коррелированными либо вообще некоррелированными. В качестве таких переменных берут, например, так называемые главные компоненты вектора исходных объясняющих переменных, изучаемые в компонентном анализе, и рассматривают регрессию на главных компонентах, в которой последние выступают в качестве обобщённых объясняющих переменных, подлежащих в дальнейшем содержательной (экономической) интерпритации.

34. Избавление от мультиколлинеарности факторов (Метод исключения).

исключении факторов с помощью t -критерия. Она заключается в том, что после построения уравнения регрессии и оценки значимости всех коэффициентов регрессии из модели исключают тот фактор, коэффициент при котором незначим и имеет наименьший коэффициент t. После этого получают новое уравнение множественной регрессии и снова производят оценку значимости всех оставшихся коэффициентов регрессии. Если среди них опять окажутся незначимые, то опять исключают фактор с наименьшим значением t -критерия. Процесс исключения факторов останавливается на том шаге, при котором все регрессионные коэффициенты значимы.

35. Нелинейная регрессия. Виды нелинейных зависимостей. Линеаризуемые и нелинеаризуемые функции.

Если между экономическими явлениями существуют нелинейные соотношения, то они выражаются с помощью соответствующих нелинейных функций: например, равносторонней гиперболы, параболы второй степени и др.

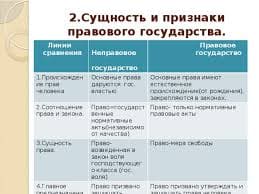

Различают два класса нелинейных регрессий:

§ регрессии, нелинейные относительно включенных в анализ объясняющих переменных, но линейные по оцениваемым параметрам;

§ регрессии, нелинейные по оцениваемым параметрам.

Примером нелинейной регрессии по включаемым в нее объясняющим переменным могут служить следующие функции:

· полиномы разных степеней – у = а + bх + с2 + ε,

у = а + bх + сх + dx3 + ε,

§ равносторонняя гипербола

К нелинейным регрессиям по оцениваемым параметрам относятся функции:

§ степенная — y = axb ε

§ показательная – у = аbх ε

§ экспоненциальная – y = ea+bx ε

2015-04-20

2015-04-20 3547

3547